Unter der Haube bei Grammarly: Erkennung von unorganisiertem Schreiben mit KI

Veröffentlicht: 2018-07-10Wann immer Sie etwas schreiben, das länger als ein Satz ist, müssen Sie Entscheidungen darüber treffen, wie Sie Ihre Gedanken organisieren und präsentieren. Gutes Schreiben ist leicht verständlich, weil jeder Satz auf dem vorangegangenen aufbaut. Wenn sich das Thema ändert, verwenden starke Autoren Übergangssätze und Absatzumbrüche als Wegweiser, um den Lesern mitzuteilen, was sie als Nächstes erwartet.

Linguisten nennen diesen Aspekt des Schreibens Diskurskohärenz, und es ist das Thema einiger cooler neuer Forschungsergebnisse des Grammarly Research-Teams, die diese Woche auf der SIGDIAL-Konferenz in Melbourne, Australien, erscheinen werden.

Was ist Diskurskohärenz und warum sollte man sich darum kümmern?

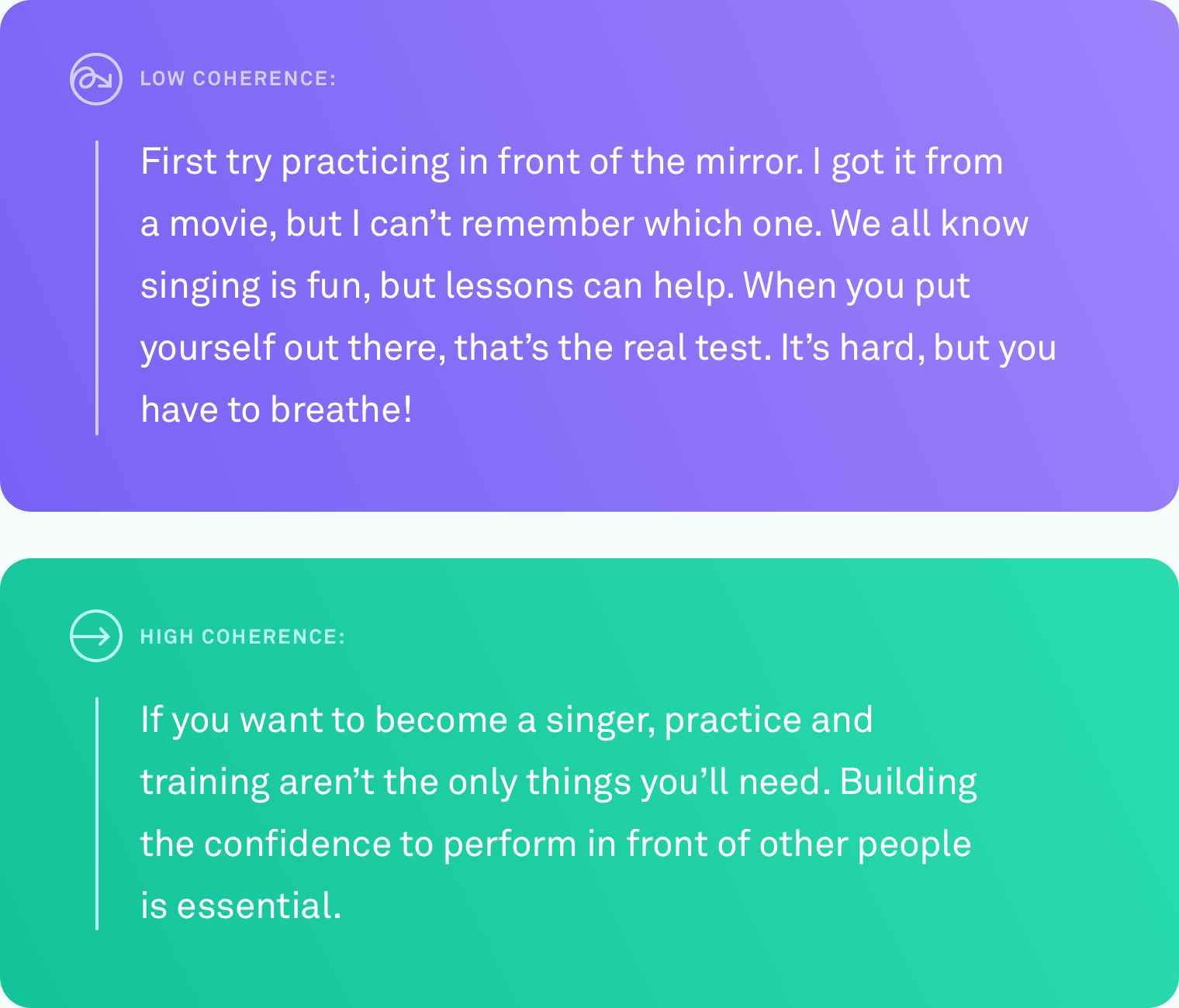

Wenn wir sagen, dass ein Text ein hohes Maß an Diskurskohärenz hat, meinen wir damit, dass alle Sätze logisch miteinander verknüpft sind. Der Autor weicht nicht vom Thema ab. Verschiedene Punkte werden durch Übergänge verbunden. Der Text ist von Anfang bis Ende leicht verständlich.

Diese Art der Organisation ist nicht immer selbstverständlich. Nur wenige von uns denken in perfekt linearen Ideenfolgen. Ein System, das Ihnen automatisch mitteilen könnte, wenn Sie etwas geschrieben haben, dem andere nur schwer folgen können – und Ihnen schließlich vorschlagen könnte, wie Sie dies beheben können – wäre enorm hilfreich, um zu kommunizieren, was Sie meinen.

Was wurde getan

Einem Computer beizubringen, das Kohärenzniveau von Text genau zu beurteilen, ist eine Herausforderung. Bis heute basiert die gebräuchlichste Methode zur Bewertung, wie gut ein Computer die Diskurskohärenz bewertet, auf einer Satzordnungsaufgabe. Bei dieser Methode nehmen die Forscher einen vorhandenen, gut redigierten Text, z. B. einen Nachrichtenartikel, und ordnen alle Sätze nach dem Zufallsprinzip neu an. Die Annahme ist, dass die zufällige Permutation als inkohärent angesehen werden kann und die ursprüngliche Reihenfolge als kohärent angesehen werden kann. Die Aufgabe besteht darin, einen Computeralgorithmus zu bauen, der zwischen der inkohärenten Version und dem Original unterscheiden kann. Unter diesen Bedingungen haben einige Systeme eine Genauigkeit von bis zu 90 Prozent erreicht. Ziemlich beeindruckend.

Aber es gibt einen großen potenziellen Fehler bei dieser Methode. Vielleicht ist es Ihnen schon aufgefallen. Das zufällige Neuordnen von Sätzen kann einen Text mit geringer Kohärenz erzeugen, aber es erzeugt keinen Text, der wie etwas aussieht, das ein Mensch natürlicherweise schreiben würde.

Bei Grammarly konzentrieren wir uns darauf, reale Probleme zu lösen, daher wussten wir, dass jede Arbeit, die wir in diesem Bereich leisten, mit echtem Schreiben und nicht mit künstlichen Szenarien verglichen werden muss. Überraschenderweise gibt es nur sehr wenige Arbeiten, die Diskursbewertungsmethoden an echtem Text testen, der von Menschen unter normalen Umständen geschrieben wurde. Es ist Zeit, das zu ändern.

Recherche in der realen Welt, Autoren in der realen Welt

Das erste Problem, das wir lösen mussten, war das gleiche, mit dem jeder andere Forscher, der sich mit Diskurskohärenz beschäftigt, konfrontiert war: ein Mangel an Daten aus der realen Welt. Es gab keinen bestehenden Korpus aus gewöhnlichem, natürlich geschriebenem Text, an dem wir unsere Algorithmen testen konnten.

Wir haben ein Korpus erstellt, indem wir Text aus mehreren öffentlichen Quellen gesammelt haben: Yahoo Answers, Yelp Reviews und öffentlich zugängliche Regierungs- und Unternehmens-E-Mails. Wir haben diese spezifischen Quellen ausgewählt, weil sie die Art von Dingen repräsentieren, die Menschen an einem typischen Tag schreiben – Forenbeiträge, Rezensionen und E-Mails.

Um all diesen Text in ein Korpus zu verwandeln, aus dem Computeralgorithmen lernen können, mussten wir auch die Kohärenzniveaus jedes Textes bewerten. Dieser Vorgang wird Annotation genannt. Egal wie gut Ihr Algorithmus ist, schlampige Anmerkungen werden Ihre Ergebnisse drastisch verzerren. In unserem Artikel stellen wir Details zu den vielen Annotationsansätzen vor, die wir getestet haben, einschließlich einiger, die Crowdsourcing beinhalteten. Wir entschieden uns schließlich dafür, dass fachkundige Kommentatoren den Kohärenzgrad jedes Textstücks auf einer Drei-Punkte-Skala (niedrige, mittlere oder hohe Kohärenz) bewerten. Jeder Text wurde von drei Kommentatoren bewertet.

Algorithmen auf den Prüfstand stellen

Sobald wir das Korpus hatten, war es an der Zeit zu testen, wie genau verschiedene Computersysteme das Kohärenzniveau eines bestimmten Textstücks identifizieren konnten. Wir haben drei Arten von Systemen getestet:

In der ersten Kategorie befinden sich entitätsbasierte Modelle. Diese Systeme verfolgen, wo und wie oft dieselben Entitäten in einem Text erwähnt werden. Findet das System beispielsweise das Wort „Transport“ in mehreren Sätzen, wertet es dies als Zeichen dafür, dass diese Sätze logisch zusammenhängen.

In der zweiten Kategorie haben wir ein Modell getestet, das auf einem lexikalischen Kohärenzgraphen basiert. Dies ist eine Möglichkeit, Sätze als Knoten in einem Diagramm darzustellen und Sätze zu verbinden, die Paare ähnlicher Wörter enthalten. Beispielsweise würde diese Art von Modell einen Satz mit „Auto“ und einen Satz mit „Lkw“ verbinden, da es in beiden Sätzen wahrscheinlich um Fahrzeuge oder Transportmittel geht.

In der dritten Kategorie befinden sich neuronale Netzwerk- oder Deep-Learning-Modelle. Wir haben mehrere davon getestet, darunter zwei brandneue Modelle, die vom Grammarly-Team gebaut wurden. Dies sind KI-basierte Systeme, die eine Darstellung jedes Satzes lernen, die seine Bedeutung erfasst, und sie können die allgemeine Bedeutung eines Dokuments lernen, indem sie diese Satzdarstellungen kombinieren. Sie können nach Mustern suchen, die nicht auf Entitätsvorkommen oder ähnliche Wortpaare beschränkt sind.

Die Satzordnungsaufgabe

Wir haben die hochkohärenten Texte aus unserem neuen Korpus verwendet, um eine Aufgabe zur Satzordnung für alle drei Arten von Modellen zu erstellen. Wir haben festgestellt, dass Modelle, die bei anderen Datensätzen zur Satzordnung gut abgeschnitten haben, auch bei unserem Datensatz gut abgeschnitten haben, mit einer Genauigkeit von bis zu 89 Prozent. Die entitätsbasierten Modelle und lexikalischen Kohärenzgraphen zeigten eine anständige Genauigkeit (im Allgemeinen 60 bis 70 Prozent Genauigkeit), aber es waren die neuronalen Modelle, die die anderen Modelle in drei der vier Bereiche um mindestens zehn Prozentpunkte übertrafen.

Der echte Schreibtest

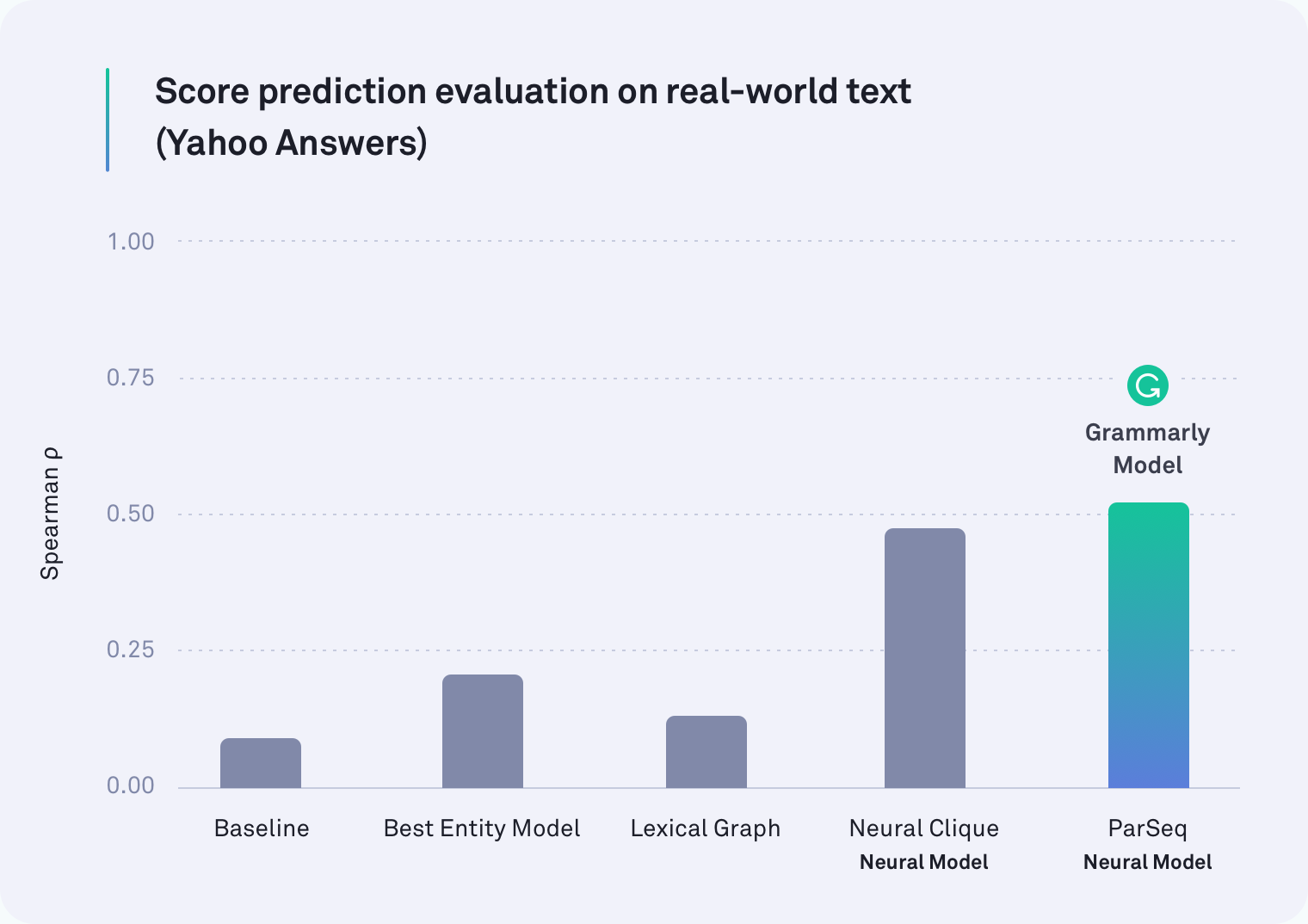

Was wir wirklich wissen wollten, war, ob eines dieser Modelle bei echtem, natürlich geschriebenem Text mit der gleichen Genauigkeit arbeiten kann. Wir haben die Beschriftungen der Kommentatoren in numerische Werte umgewandelt (niedrig=1, mittel=2, hoch=3) und die Zahlen gemittelt, um einen Kohärenzwert für jeden Textteil zu erhalten.

In jedem Bereich übertraf mindestens eines der auf neuronalen Netzwerken basierenden Systeme alle anderen. Tatsächlich war eines der Modelle von Grammarly, das Absatzumbrüche berücksichtigt, der beste Performer bei Text von Yahoo Answers, wie in der folgenden Tabelle gezeigt. Das Neural Clique-Modell, das von Forschern in Stanford entwickelt wurde, war ebenfalls ein starker Performer.

Aber unsere ursprüngliche Hypothese war richtig: Alle Modelle schnitten bei der realen Aufgabe schlechter ab als bei der Satzordnungsaufgabe – einige waren viel schlechter. Beispielsweise war die lexikalische Graphmethode für Unternehmens-E-Mails im künstlichen Satzumordnungsszenario zu 78 Prozent genau, erreichte aber in dieser realistischeren Bewertung nur 45 Prozent.

Was wir gefunden haben

Es stellt sich heraus, dass frühere Arbeiten zur Diskurskohärenz das Falsche getestet haben. Die Satzstellungsaufgabe ist definitiv kein guter Proxy für die Messung der Diskurskohärenz. Unsere Ergebnisse sind eindeutig: Systeme, die im künstlichen Szenario gut abschneiden, schneiden bei realem Text viel schlechter ab.

Es ist wichtig zu beachten, dass diese Erkenntnis kein Rückschlag ist. Weit gefehlt. Ein Teil des Wachstums eines Feldes besteht darin, zu bewerten, wie Sie bewerten – von Zeit zu Zeit anzuhalten, um einen Blick darauf zu werfen, was Sie wirklich gemessen haben. Aufgrund dieser Arbeit verfügen Forschende, die sich mit Diskurskohärenz befassen, nun über zwei wichtige Informationen. Eine davon ist die Einsicht, dass die Satzordnungsaufgabe nicht länger die Art und Weise sein sollte, wie wir die Genauigkeit messen. Das zweite ist ein öffentlich verfügbarer, kommentierter Korpus aus Texten aus der realen Welt und neuen Benchmarks (unsere neuronalen Modelle), die in zukünftigen Forschungsarbeiten verwendet werden können.

Ich freue mich auf

Es gibt noch viel zu tun und viele spannende Anwendungen für ein System, das die Diskurskohärenz in einem Textstück zuverlässig beurteilen kann. Eines Tages könnte Ihnen ein System wie dieses nicht nur sagen, wie kohärent Ihre Gesamtbotschaft ist, sondern auch auf bestimmte Passagen hinweisen, die möglicherweise schwer zu verstehen sind. Wir hoffen, dass wir Ihnen eines Tages dabei helfen können, diese Passagen leichter verständlich zu machen, damit Ihr Empfänger versteht, was Sie zu sagen versuchen.

Schließlich geht es auf dem Weg von Grammarly zu einem umfassenden Kommunikationsassistenten nicht nur darum, sicherzustellen, dass Ihr Schreiben grammatikalisch und stilistisch korrekt ist – es geht darum sicherzustellen, dass Sie genau so verstanden werden, wie Sie es beabsichtigt haben.

—-

Joel Tetreault ist Forschungsdirektor bei Grammarly. Alice Lai ist Doktorandin an der University of Illinois at Urbana-Champaign und war Forschungspraktikantin bei Grammarly. Diese Forschung wird auf der Jahreskonferenz SIGDIAL 2018 in Melbourne, Australien, vom 12. bis 14. Juli 2018 vorgestellt. Das begleitende Forschungspapier mit dem Titel „Discourse Coherence in the Wild: A Dataset, Evaluation and Methods“ wird in den Proceedings of veröffentlicht das 19. Jahrestreffen der Special Interest Group on Discourse and Dialogue. Der in diesem Blogbeitrag beschriebene Datensatz heißt Grammarly Corpus of Discourse Coherence und kann hier kostenlos für Forschungszwecke heruntergeladen werden.