Computer Vision und KI: Visuelles Verständnis verändern

Veröffentlicht: 2025-01-15Computer Vision ist einer der grundlegenden Teilbereiche der künstlichen Intelligenz (KI). In diesem Leitfaden wird Computer Vision erläutert, wie es funktioniert, wo es eingesetzt wird und welche Vor- und Nachteile es hat.

Inhaltsverzeichnis

- Was ist Computer Vision?

- Geschichte und Entwicklung der Computer Vision

- Wie Computer Vision funktioniert

- Anwendungen von Computer Vision

- Vorteile von Computer Vision

- Nachteile von Computer Vision

- Abschluss

Was ist Computer Vision?

Der Bereich Computer Vision umfasst alle KI-Techniken, die Computersysteme zur Analyse visueller Daten nutzen, beispielsweise der Daten in Videos und Fotos. Das Gebiet existiert offiziell seit den 1960er Jahren, und frühe Computer-Vision-Anwendungen nutzten Mustervergleich und andere Heuristiken, um Bilder in der Biomedizin, der fortgeschrittenen Physik und anderen hochmodernen Forschungsbereichen zu verbessern. Fast alle neueren Computer-Vision-Systeme verlassen sich bei ihrer Arbeit ausschließlich auf Algorithmen des maschinellen Lernens (ML) (genauer gesagt Deep-Learning-Algorithmen), da sie viel effektiver sind als ältere Techniken.

Geschichte und Entwicklung der Computer Vision

Computer Vision geht auf Experimente von Neurophysiologen zurück, die verstehen wollten, wie vom Auge erzeugte Bilder im Gehirn verarbeitet werden. In den ersten Jahrzehnten seiner Entwicklung stützte sich Computer Vision stark auf die Forschung zum menschlichen und tierischen Sehen und wurde von dieser inspiriert.

Obwohl es schwierig ist, ein genaues Startjahr zu bestimmen, wird 1959 oft als Beginn des Fachgebiets angesehen. In diesem Jahr wurden zwei Kernkonzepte der Bildanalyse festgelegt: (1) Die Bildanalyse sollte sich zunächst auf die Identifizierung von Unterkomponenten eines Bildes konzentrieren und (2) diese Komponenten sollten dann hierarchisch analysiert werden.

Die folgende Liste hebt einige der wichtigsten Meilensteine zwischen der Entdeckung dieser grundlegenden Konzepte und der jüngsten Explosion der Fortschritte in der Computer Vision hervor. Heutzutage sind Computer-Vision-Systeme auf komplexe Deep-Learning-Algorithmen angewiesen, um realistische Bilder in Echtzeit zu verarbeiten, zu verstehen, zu bearbeiten und zu erstellen.

Wichtige Meilensteine in der Entwicklung von Computer Vision

1959:Untersuchungen an Tiergehirnen zeigten, dass einfache Bestandteile eines Bildes (wie Kanten und Linien) zuerst erkannt und dann hierarchisch verarbeitet wurden. Diese Erkenntnisse wurden zu zwei der grundlegenden Konzepte der Computer Vision und gelten als die offiziellen Anfänge des Fachgebiets.

1960er Jahre:Die ersten offiziellen KI- und Computer-Vision-Bemühungen begannen. Zu den Fortschritten gehörten Systeme, die Teile von Fotos automatisch in gleichwertige dreidimensionale Objekte umwandelten.

1970er Jahre:Durch die Konzentration auf Computer-Vision-Forschung und -Ausbildung wurden viele Kernalgorithmen für Computer-Vision hervorgebracht, die auch heute noch verwendet werden, darunter solche zur Mustererkennung, Bewegungsschätzung, Kantenerkennung, Linienmarkierung und geometrischen Modellierung von Bildkomponenten.

1980er Jahre:Convolutional Neural Networks (CNNs) wurden im Laufe des Jahrzehnts erheblich weiterentwickelt. Im Jahr 1989 wurde das erste CNN erfolgreich auf ein Sehproblem angewendet und erkannte automatisch Postleitzahlen in Bildern.

1990er Jahre:Intelligente Kameras erfreuen sich immer größerer Beliebtheit und werden häufig in industriellen Umgebungen eingesetzt. Die wachsende Nachfrage nach Werkzeugen zur Verarbeitung großer Mengen digitaler Bilder führte zu einem explosionsartigen Anstieg der kommerziellen Investitionen und brachte den Bereich weiter voran. Die Computer-Vision-Industrie war geboren und formale Methoden zur Bewertung der Qualität von Computer-Vision-Systemen wurden entwickelt.

2000:In den späten 1990er und frühen 2000er Jahren etablierten Forscher das Konzept der Veränderungsblindheit. Sie zeigten, dass Menschen bei der Beobachtung visueller Daten häufig wesentliche Veränderungen übersehen. Diese Entdeckung trug dazu bei, ein weiteres Konzeptpaar – die Ideen der Aufmerksamkeit und der Teilverarbeitung – als Kernelemente der Computer Vision zu etablieren.

2011:Zum ersten Mal zeigte ein Team in der Schweiz, dass auf GPUs angewendete CNNs ein definitiv effizientes Computer-Vision-ML-System sind. Diese Systeme waren revolutionär, brachen zahlreiche Sehrekorde und übertrafen erstmals den Menschen. Computer-Vision-Systeme begannen mit der Umstellung auf CNN-basierte Implementierungen.

2015:Eine Deep-Learning-Implementierung von CNNs gewann zum ersten Mal den ImageNet-Wettbewerb und markierte damit den Beginn der modernen Ära des Computer Vision.

Wie Computer Vision funktioniert

Computer-Vision-Arbeit umfasst normalerweise drei Teile, die wir im Folgenden beschreiben. Implementierungsdetails auf niedrigerer Ebene können sehr komplex sein und häufig wiederholte Phasen umfassen, wie im dritten Teil unten beschrieben. Auch wenn die Implementierungsdetails kompliziert sind, folgt die Arbeit in der Regel diesen Mustern.

1 Bildaufnahme

Wie andere ML-Systeme sind auch visuelle Datenverarbeitungssysteme von der Menge und Qualität der Daten abhängig, auf die sie zugreifen können. Beim Entwurf eines Computer-Vision-Systems wird sorgfältig darauf geachtet, wann und wie Quelldaten und Bilder erfasst werden, um die Verarbeitungsqualität zu verbessern. Verschiedene Faktoren müssen berücksichtigt und optimiert werden, darunter:

- Sensoren:Die Anzahl und Art der verwendeten Sensoren. Computer-Vision-Systeme nutzen Sensoren, um Daten aus ihrer Umgebung zu erfassen, darunter Videokameras, Lidar (Lichterkennung und Entfernungsmessung), Radar und Infrarotsensoren.

- Einsatz:Die Anordnung und Ausrichtung von Sensoren, um tote Winkel zu minimieren und die Sensorinformationen optimal zu nutzen.

- Sensordaten:Unterschiedliche Datentypen und -mengen müssen unterschiedlich verarbeitet und interpretiert werden. Für MRT-, Röntgen- und Videodaten gelten beispielsweise besondere Anforderungen an die Verarbeitung, Speicherung und Interpretation.

Ein Computer-Vision-System sollte idealerweise Zugriff auf gerade genug Bilddaten haben. Bei zu wenigen Daten werden nicht genügend Informationen angezeigt, um die Probleme zu lösen, die es lösen soll. Zu viele irrelevante Daten verbrauchen die Ressourcen des Systems, verlangsamen es und machen den Betrieb teurer. Eine sorgfältige Optimierung der Bildaufnahmephase ist für den Aufbau effektiver Computer-Vision-Systeme von entscheidender Bedeutung.

2 Bild(vor)verarbeitung

Dieselben visuellen Daten aus zwei unterschiedlichen Quellen können unterschiedliche Bedeutungen haben. Details zum Kontext, in dem ein Bild aufgenommen wurde (z. B. Umgebungslicht, Temperatur und Kamerabewegung), können ebenfalls darauf hinweisen, dass das Bild anders interpretiert werden sollte.

Die Bildvorverarbeitung erfordert viel Arbeit, um Bilder leichter verständlich und analysierbar zu machen. Beispielsweise können Bilder normalisiert werden, was bedeutet, dass Eigenschaften wie Größe, Farbe, Auflösung und Ausrichtung so angepasst werden, dass sie über alle Bilder hinweg konsistent sind. Während der Vorverarbeitung können auch andere Eigenschaften angepasst werden, um Bildverarbeitungsalgorithmen bei der Erkennung domänenspezifischer Merkmale zu unterstützen. Beispielsweise könnte der Kontrast erhöht werden, um einige Objekte oder Merkmale besser sichtbar zu machen.

Es können kundenspezifische Anpassungen vorgenommen werden, um Unterschiede bei den Sensoren, Sensorschäden und damit verbundene Wartungsarbeiten auszugleichen. Schließlich können einige Anpassungen vorgenommen werden, um die Verarbeitungseffizienz und die Kosten zu optimieren und dabei spezifische Details zur Analyse der Bilder zu berücksichtigen.

3 Bildverarbeitung und -analyse: Merkmalsextraktion, Mustererkennung und Klassifizierung

Aktuelle Computer-Vision-Systeme sind hierarchisch aufgebaut und betrachten Teile jedes Bildes unabhängig voneinander. Jede Ebene in einer Hierarchie ist typischerweise darauf spezialisiert, eine von drei Aufgaben auszuführen:

- Merkmalsextraktion:Eine Merkmalsextraktionsschicht findet interessante Bildkomponenten. Es könnte beispielsweise erkennen, wo gerade Linien im Bild zu finden sind.

- Mustererkennung:Eine Mustererkennungsschicht untersucht, wie verschiedene Merkmale zu Mustern kombiniert werden. Es könnte beispielsweise identifizieren, welche Linienkombinationen im Bild Polygone bilden.

- Klassifizierung:Nach genügend Wiederholungen der Merkmalsextraktion und Mustererkennung hat das System möglicherweise genug über ein bestimmtes Bild gelernt, um eine Klassifizierungsfrage zu beantworten, z. B. „Sind auf diesem Bild Autos zu sehen?“ Eine Klassifizierungsschicht beantwortet solche Fragen.

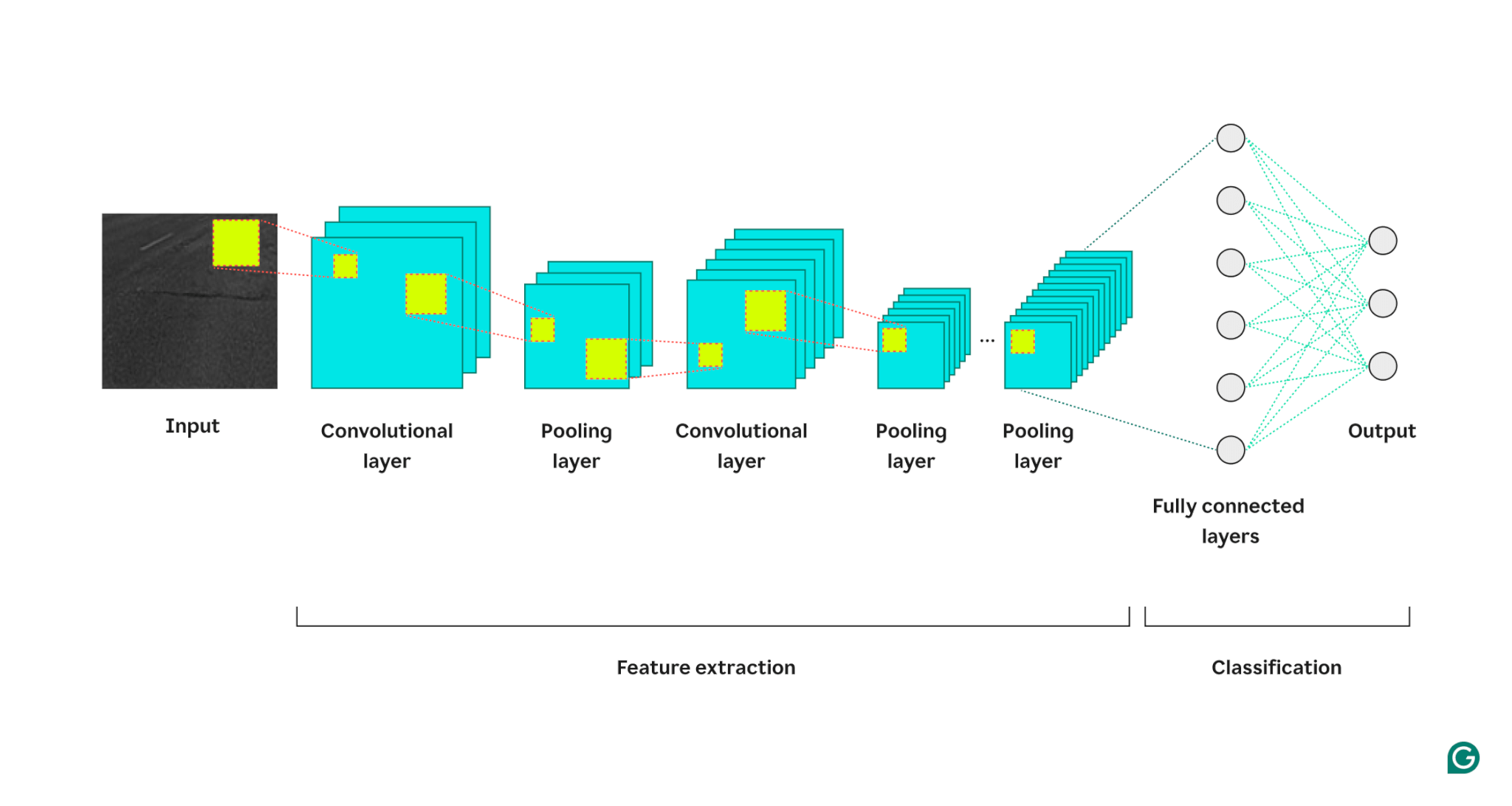

Das folgende Diagramm zeigt, wie dies in einer mit CNNs erstellten Computer-Vision-Systemarchitektur implementiert wird. Die vom System analysierte Eingabe (normalerweise ein Bild oder Video) befindet sich ganz links im Diagramm. Ein als tiefes neuronales Netzwerk implementiertes CNN wechselt Faltungsschichten, die sich durch Merkmalsextraktion auszeichnen, mit Pooling-Schichten, die sich durch Mustererkennung auszeichnen. Bilddetails werden von links nach rechts verarbeitet und es kann viel mehr Wiederholungen der beiden Ebenen geben als die unten gezeigten.

Sobald eine ausreichend tiefgreifende Analyse abgeschlossen ist, berücksichtigt eine vollständig verbundene Schicht von Neuronen alle Datenmuster und Merkmale in ihrer Gesamtheit und löst ein Klassifizierungsproblem (z. B. „Ist auf dem Foto ein Auto?“).

Anwendungen von Computer Vision

Computer Vision ist allgegenwärtig. Da die Systeme leistungsfähiger und einfacher anzuwenden sind, ist die Zahl der Anwendungen explosionsartig gestiegen. Hier sind einige der bekannteren Anwendungen.

Gesichtserkennung

Eine der allgegenwärtigsten und fortschrittlichsten Anwendungen des maschinellen Sehens ist die Erkennung und Erkennung von Gesichtern. Smartphones, Sicherheitssysteme und Zugangskontrollgeräte nutzen eine Kombination aus Sensoren, Kameras und trainierten neuronalen Netzen, um zu erkennen, ob Bilder Gesichter enthalten, und alle gefundenen Gesichter umzuwandeln, damit sie analysiert werden können.

Ein Gesichtserkennungssystem sucht regelmäßig nach Gesichtern in der Nähe. Daten von billigen und schnellen Sensoren, wie einer Infrarotlichtquelle und einer Kamera mit niedriger Auflösung, aber hohem Kontrast, werden durch ein ML-Modell geleitet, das die Anwesenheit von Gesichtern erkennt.

Wenn potenzielle Gesichter erkannt werden, kann eine langsamere, teurere Kamera mit höherer Auflösung auf sie gerichtet werden und dann eine kurze Aufnahme machen. Ein visuelles Verarbeitungssystem kann die Aufnahme dann in 3D-Rekonstruktionen umwandeln, um zu überprüfen, ob ein Gesicht vorhanden ist. Ein Gesichtsklassifikator kann dann entscheiden, ob die Personen auf dem Bild zu einer Gruppe gehören, die ein Telefon entsperren oder Zutritt zu einem Gebäude erhalten darf.

Autonome Fahrzeuge

Es ist schwierig, ein System aufzubauen, das ein Fahrzeug steuern, durch die Welt navigieren und in Echtzeit auf Veränderungen in seiner Umgebung reagieren kann. Computer-Vision-Systeme sind nur eine Kerntechnologie, die autonome Fahrzeuge ermöglicht.

Diese Bildverarbeitungssysteme lernen, Straßen, Verkehrszeichen, Fahrzeuge, Hindernisse, Fußgänger und die meisten anderen Dinge zu erkennen, denen sie während der Fahrt begegnen könnten. Bevor sie ihre Wirkung entfalten können, müssen sie große Datenmengen analysieren, die unter den unterschiedlichsten Fahrbedingungen gewonnen wurden.

Um unter realen Bedingungen nützlich zu sein, müssen Computer-Vision-Systeme für autonome Fahrzeuge sehr schnell (damit das autonome Fahrzeug maximale Zeit hat, auf sich ändernde Bedingungen zu reagieren), genau (da ein Fehler Leben gefährden kann) und leistungsstark (da das Problem besteht) sein ist komplex – das System muss Objekte bei allen Wetter- und Lichtverhältnissen identifizieren). Autonome Fahrzeugunternehmen investieren stark in das Ökosystem. Die verfügbaren Datenmengen wachsen exponentiell und die Techniken zu ihrer Verarbeitung verbessern sich rasant.

Erweiterte Realität

Intelligente Brillen und aktuelle Telefonkameras basieren auf Computer-Vision-Systemen, um ihren Benutzern Augmented-Reality-Erlebnisse zu bieten. Gut trainierte Systeme, ähnlich denen, die für autonome Fahrzeuge verwendet werden, identifizieren Objekte im Bild einer Kamera oder einer Smart-Brille und deren Position relativ zueinander im 3D-Raum.

Fortgeschrittene Bilderzeugungssysteme nutzen diese Informationen dann, um das, was die Kamera oder die Brille einem Benutzer zeigt, auf verschiedene Weise zu ergänzen. Sie können beispielsweise die Illusion erzeugen, dass Daten auf Oberflächen projiziert werden, oder zeigen, wie Objekte wie Möbel in den 3D-Raum passen könnten.

Vorteile von Computer Vision

Computer-Vision-Systeme können dazu beitragen, das menschliche Sehvermögen zu verbessern, Sicherheitssysteme zu verbessern und Daten in großem Maßstab zu analysieren. Zu den Hauptvorteilen ihrer Verwendung gehören die folgenden:

Geschwindigkeit und Umfang der Objekterkennung

Hochmoderne Computer-Vision-Systeme können Objekte viel schneller und in viel größerer Lautstärke identifizieren als Menschen. Ein Fließband beispielsweise wird schneller vorankommen, wenn ein automatisiertes Computer-Vision-System seinen Vorgesetzten unterstützt. Selbstfahrende Fahrzeuge können in einem Fahrerassistenzmodus betrieben werden, der dem Fahrer hilft, auf Informationen aus seiner Umgebung aufmerksam zu werden, die er nicht schnell wahrnimmt. Sie können auch die volle Kontrolle übernehmen und schnellere und sicherere Entscheidungen treffen als ein Mensch ohne Hilfe.

Genauigkeit

Gut trainierte Computer-Vision-Systeme erledigen die Aufgaben, für die sie trainiert werden, genauer als Menschen. Sie können beispielsweise Defekte an Objekten genauer identifizieren oder Krebsgeschwüre in medizinischen Bildern früher erkennen.

Großes Datenverarbeitungsvolumen

Bildverarbeitungssysteme können Anomalien und Bedrohungen in großen Mengen an Bildern und Video-Feeds viel schneller und genauer erkennen als Menschen. Ihre Fähigkeit, Informationen zu verarbeiten, korreliert mit der verfügbaren Rechenleistung und ist unbegrenzt skalierbar.

Nachteile von Computer Vision

Hochleistungsfähige Computer-Vision-Systeme sind schwierig herzustellen. Zu den Herausforderungen und Nachteilen zählen unter anderem die folgenden:

Überanpassung

Aktuelle Computer-Vision-Systeme basieren auf Deep-Learning-Algorithmen und -Netzwerken. Sie sind während des Trainings auf den Zugriff auf große Mengen kommentierter Daten angewiesen. Derzeit sind visuelle Trainingsdaten nicht in den umfangreichen Mengen verfügbar, die in anderen Anwendungen zu finden sind, und ihre Generierung ist anspruchsvoll und kostspielig. Infolgedessen sind viele Computer-Vision-Systeme auf unzureichende Daten trainiert und überpassen sich – sie benötigen Hilfe bei der Verallgemeinerung auf neue und unbekannte Situationen.

Datenschutz ist im großen Maßstab schwer zu gewährleisten

Computer-Vision-Systeme können große Mengen privater oder geschützter Daten beobachten und daraus lernen. Sobald sie im Feld sind, können sie auch beliebige Daten in ihrer Umgebung beobachten. Es ist schwierig zu garantieren, dass Trainingsdaten frei von privaten Informationen sind, und noch schwieriger ist es, zu verhindern, dass ein System vor Ort private Informationen in sein Training einbezieht.

Rechnerisch komplex

Systeme, die Computer Vision verwenden, werden in der Regel für einige der schwierigsten Probleme im KI-Bereich eingesetzt. Infolgedessen sind sie teuer und komplex und es kann schwierig sein, sie richtig zu bauen und zusammenzubauen.

Abschluss

Viele der interessantesten und herausforderndsten Probleme in ML und KI betreffen den Einsatz und die Anwendung von Computer-Vision-Systemen. Sie sind allgegenwärtig nützlich, unter anderem in Sicherheitssystemen, selbstfahrenden Fahrzeugen, medizinischen Bildanalysen und anderswo. Allerdings sind Computer-Vision-Systeme teuer und schwierig zu bauen.

Sie sind auf eine zeitaufwändige Datenerfassung in großem Maßstab angewiesen, erfordern individuelle oder teure Ressourcen, bevor sie effektiv genutzt werden können, und werfen Bedenken hinsichtlich des Datenschutzes auf. In diesem Schlüsselbereich des maschinellen Lernens wird derzeit intensiv geforscht und schreitet schnell voran.