Under the Hood at Grammarly: detección de escritura desorganizada con IA

Publicado: 2018-07-10Cada vez que escribe algo más largo que una oración, debe tomar decisiones sobre cómo organizar y presentar sus pensamientos. La buena escritura es fácil de entender porque cada oración se basa en las anteriores. Cuando el tema cambia, los buenos escritores usan oraciones de transición y saltos de párrafo como señales para decirles a los lectores qué esperar a continuación.

Los lingüistas llaman a este aspecto de la coherencia del discurso escrito, y es el tema de una nueva investigación interesante del equipo de Grammarly Research que aparecerá en la conferencia SIGDIAL en Melbourne, Australia, esta semana.

¿Qué es la coherencia del discurso y por qué se preocupa por ella?

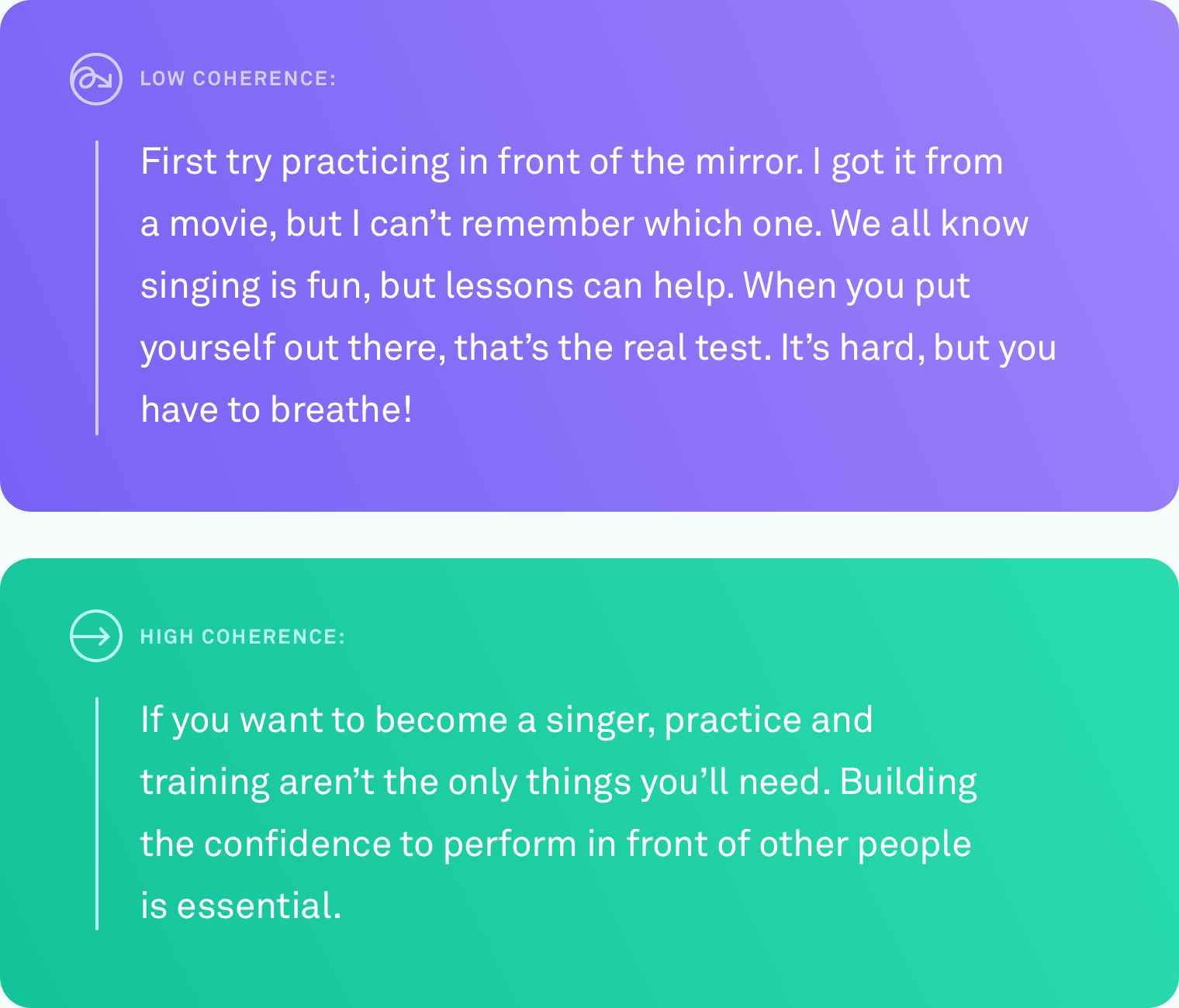

Cuando decimos que un texto tiene un alto nivel de coherencia discursiva, nos referimos a que todas las oraciones están unidas lógicamente. El escritor no se desvía del tema. Diferentes puntos están conectados por transiciones. El texto es fácil de seguir de principio a fin.

Este tipo de organización no siempre es algo natural. Pocos de nosotros pensamos en progresiones de ideas perfectamente lineales. Un sistema que pueda decirle automáticamente cuándo ha escrito algo que otras personas tendrán dificultades para seguir y, eventualmente, sugerir cómo solucionarlo, sería de gran ayuda para comunicar lo que quiere decir.

que se ha hecho

Enseñar a una computadora a juzgar con precisión el nivel de coherencia del texto es un desafío. Hasta la fecha, el método más común para evaluar qué tan bien califica una computadora la coherencia del discurso se basa en una tarea de ordenamiento de oraciones. Con este método, los investigadores toman un texto existente y bien editado, como un artículo de noticias, y reordenan aleatoriamente todas las oraciones. La suposición es que la permutación aleatoria puede verse como incoherente y el orden original puede verse como coherente. La tarea es construir un algoritmo informático que pueda distinguir entre la versión incoherente y el original. En estas condiciones, algunos sistemas han alcanzado una precisión de hasta el 90 por ciento. Muy impresionante.

Pero hay un gran defecto potencial con este método. Tal vez ya lo hayas visto. Reordenar oraciones al azar puede producir un texto de baja coherencia, pero no produce un texto que se parezca a algo que un ser humano escribiría de forma natural.

En Grammarly, nos enfocamos en resolver problemas del mundo real, por lo que sabíamos que cualquier trabajo que hiciéramos en esta área debería compararse con la escritura real, no con escenarios artificiales. Sorprendentemente, ha habido muy pocos trabajos que prueben los métodos de evaluación del discurso en texto real escrito por personas en circunstancias normales. Es hora de cambiar eso.

Investigación del mundo real, escritores del mundo real

El primer problema que tuvimos que resolver fue el mismo al que se han enfrentado todos los demás investigadores que trabajan en la coherencia del discurso: la falta de datos del mundo real. No había un corpus existente de texto ordinario escrito de forma natural en el que pudiéramos probar nuestros algoritmos.

Creamos un corpus recopilando texto de varias fuentes públicas: respuestas de Yahoo, reseñas de Yelp y correos electrónicos gubernamentales y corporativos disponibles públicamente. Elegimos estas fuentes específicas porque representan el tipo de cosas que las personas escriben en un día típico: publicaciones en foros, reseñas y correos electrónicos.

Para convertir todo este texto en un corpus del que los algoritmos informáticos puedan aprender, también necesitábamos calificar los niveles de coherencia de cada texto. Este proceso se llama anotación. No importa cuán bueno sea su algoritmo, una anotación descuidada sesgará drásticamente sus resultados. En nuestro documento, brindamos detalles sobre los muchos enfoques de anotación que probamos, incluidos algunos que involucraron crowdsourcing. Finalmente, decidimos que los anotadores expertos calificaran el nivel de coherencia de cada fragmento de texto en una escala de tres puntos (coherencia baja, media o alta). Cada fragmento de texto fue juzgado por tres anotadores.

Poniendo a prueba los algoritmos

Una vez que tuvimos el corpus, llegó el momento de probar con qué precisión varios sistemas informáticos podían identificar el nivel de coherencia de un texto determinado. Probamos tres tipos de sistemas:

En la primera categoría están los modelos basados en entidades. Estos sistemas rastrean dónde y con qué frecuencia se mencionan las mismas entidades en un texto. Por ejemplo, si el sistema encuentra la palabra “transporte” en varias oraciones, lo toma como una señal de que esas oraciones están lógicamente relacionadas entre sí.

En la segunda categoría, probamos un modelo basado en un gráfico de coherencia léxica. Esta es una forma de representar oraciones como nodos en un gráfico y de conectar oraciones que contienen pares de palabras similares. Por ejemplo, este tipo de modelo conectaría una oración que contenga "automóvil" y una oración que contenga "camión" porque ambas oraciones probablemente se refieran a vehículos o transporte.

En la tercera categoría se encuentran los modelos de redes neuronales o de aprendizaje profundo. Probamos varios de estos, incluidos dos modelos nuevos creados por el equipo de Grammarly. Estos son sistemas basados en IA que aprenden una representación de cada oración que captura su significado, y pueden aprender el significado general de un documento al combinar estas representaciones de oraciones. Pueden buscar patrones que no estén restringidos a ocurrencias de entidades o pares de palabras similares.

La tarea de ordenar oraciones

Usamos los textos de alta coherencia de nuestro nuevo corpus para crear una tarea de ordenamiento de oraciones para los tres tipos de modelos. Descubrimos que los modelos que funcionaron bien en otros conjuntos de datos de ordenación de oraciones también funcionaron bien en nuestro conjunto de datos, con rendimientos de hasta un 89 por ciento de precisión. Los modelos basados en entidades y los gráficos de coherencia léxica mostraron una precisión decente (generalmente de 60 a 70 por ciento de precisión), pero fueron los modelos neuronales los que superaron a los otros modelos en al menos diez puntos porcentuales en tres de los cuatro dominios.

La prueba de escritura real

Lo que realmente queríamos saber era si alguno de estos modelos podría funcionar con el mismo nivel de precisión en texto real escrito de forma natural. Convertimos las etiquetas de los anotadores en valores numéricos (bajo=1, medio=2, alto=3) y promediamos los números para obtener una puntuación de coherencia para cada parte del texto.

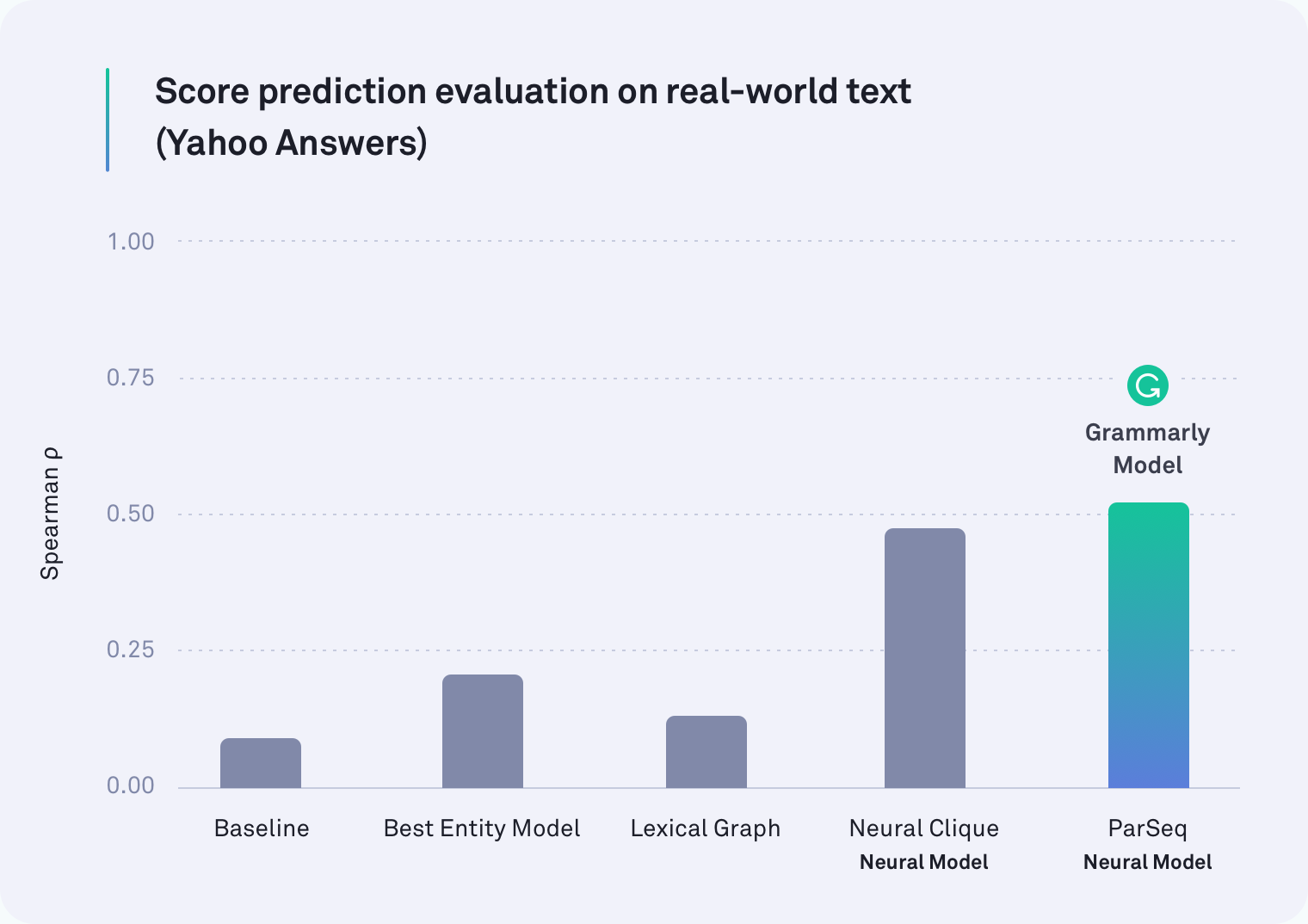

En todos los dominios, al menos uno de los sistemas basados en redes neuronales superó a todos los demás. De hecho, uno de los modelos de Grammarly que tiene en cuenta los saltos de párrafo fue el de mayor rendimiento en texto de Yahoo Respuestas, como se muestra en la siguiente tabla. El modelo Neural Clique, que fue desarrollado por investigadores de Stanford, también tuvo un gran desempeño.

Pero nuestra hipótesis original era correcta: todos los modelos se desempeñaron peor en la tarea del mundo real que en la tarea de ordenar oraciones; algunos fueron mucho peores. Por ejemplo, el método del gráfico léxico tuvo una precisión del 78 % para los correos electrónicos corporativos en el escenario de reordenación artificial de oraciones, pero solo logró un 45 % en esta evaluación más realista.

Lo que encontramos

Resulta que el trabajo previo sobre la coherencia del discurso ha estado probando algo incorrecto. La tarea de orden de oraciones definitivamente no es un buen indicador para medir la coherencia del discurso. Nuestros resultados son claros: los sistemas que funcionan bien en el escenario artificial funcionan mucho peor en el texto del mundo real.

Es importante tener en cuenta que este hallazgo no es un revés. Lejos de eso, de hecho. Parte del crecimiento de cualquier campo es evaluar cómo estás evaluando, deteniéndote de vez en cuando para ver lo que realmente has estado midiendo. Gracias a este trabajo, los investigadores que trabajan en la coherencia del discurso ahora tienen dos piezas importantes de información. Una es la idea de que la tarea de ordenar oraciones ya no debería ser la forma en que medimos la precisión. El segundo es un corpus anotado disponible públicamente de texto del mundo real y nuevos puntos de referencia (nuestros modelos neuronales) para usar en futuras investigaciones.

Viendo hacia adelante

Hay más trabajo por hacer y muchas aplicaciones emocionantes para un sistema que puede juzgar de manera confiable la coherencia del discurso en un texto. Un día, un sistema como este no solo podría decirle qué tan coherente es su mensaje general, sino también señalar los pasajes específicos que pueden ser difíciles de seguir. Algún día esperamos ayudarlo a hacer que esos pasajes sean más fáciles de entender para que lo que está tratando de decir sea claro para su destinatario.

Después de todo, el camino de Grammarly para convertirse en un asistente de comunicación integral no se trata solo de asegurarse de que su escritura sea gramatical y estilísticamente precisa, sino de asegurarse de que se le entienda tal como se esperaba.

—-

Joel Tetreault es director de investigación en Grammarly. Alice Lai es estudiante de doctorado en la Universidad de Illinois en Urbana-Champaign y fue pasante de investigación en Grammarly. Esta investigación se presentará en la conferencia anual SIGDIAL 2018 en Melbourne, Australia, del 12 al 14 de julio de 2018. El documento de investigación adjunto, titulado "Coherencia del discurso en la naturaleza: un conjunto de datos, evaluación y métodos" se publicará en las Actas de la XIX Reunión Anual del Grupo de Interés Especial sobre Discurso y Diálogo. El conjunto de datos descrito en esta publicación de blog se llama Grammarly Corpus of Discourse Coherence y se puede descargar gratis con fines de investigación aquí.