Sous le capot chez Grammarly : détecter l'écriture désorganisée avec l'IA

Publié: 2018-07-10Chaque fois que vous écrivez quelque chose de plus long qu'une phrase, vous devez prendre des décisions sur la façon d'organiser et de présenter vos pensées. Une bonne écriture est facile à comprendre car chaque phrase s'appuie sur celles qui la précèdent. Lorsque le sujet change, les rédacteurs forts utilisent des phrases de transition et des sauts de paragraphe comme panneaux indicateurs pour dire aux lecteurs à quoi s'attendre ensuite.

Les linguistes appellent cet aspect de l'écriture la cohérence du discours, et c'est le sujet d'une nouvelle recherche intéressante de l'équipe Grammarly Research qui apparaîtra à la conférence SIGDIAL à Melbourne, en Australie, cette semaine.

Qu'est-ce que la cohérence du discours et pourquoi s'en soucier ?

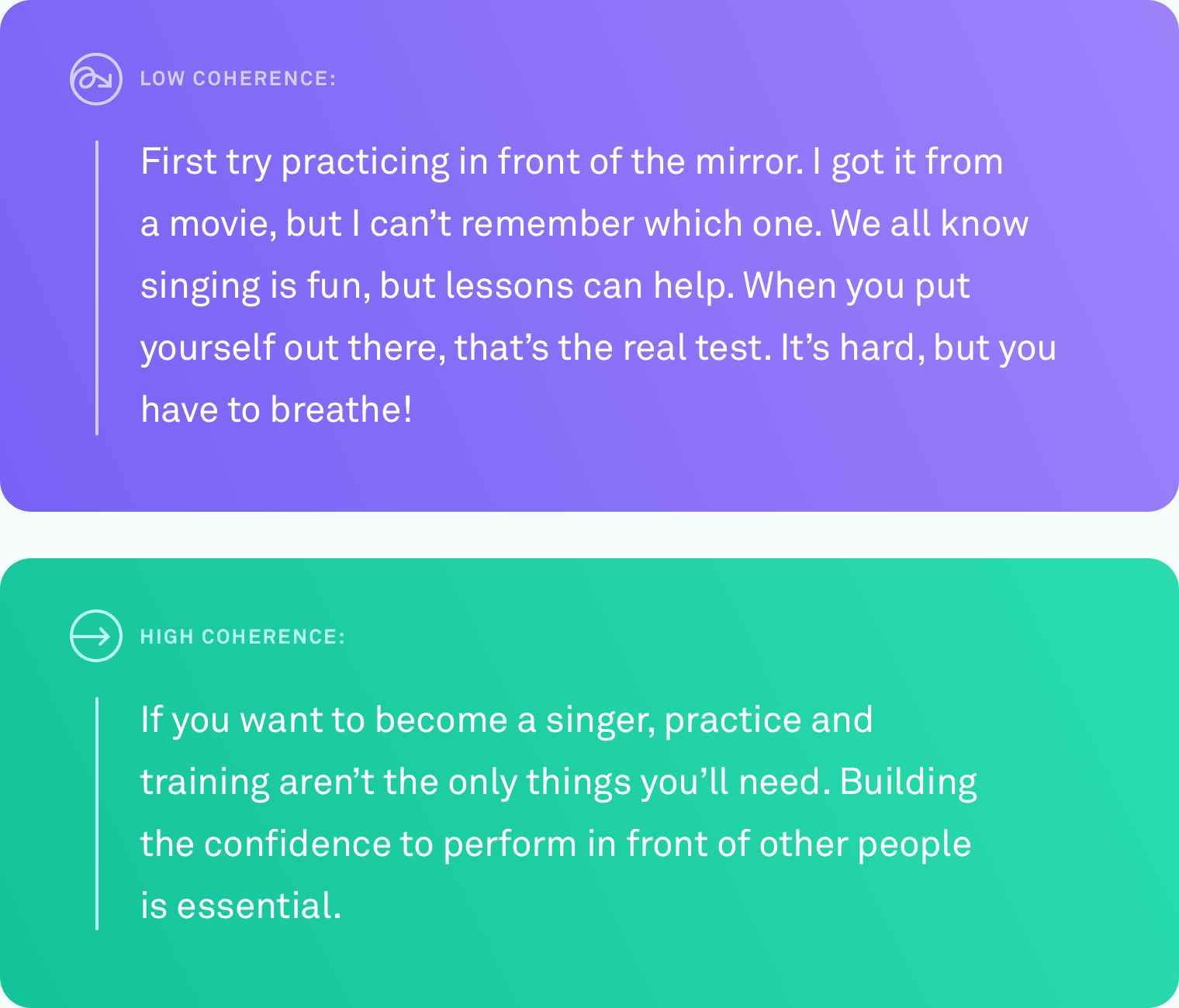

Quand on dit qu'un texte a un haut niveau de cohérence du discours, on veut dire que toutes les phrases sont logiquement liées entre elles. L'auteur ne s'écarte pas du sujet. Différents points sont reliés par des transitions. Le texte est facile à suivre du début à la fin.

Ce type d'organisation ne vient pas toujours naturellement. Peu d'entre nous pensent en progressions d'idées parfaitement linéaires. Un système qui pourrait automatiquement vous dire quand vous avez écrit quelque chose que d'autres personnes auront du mal à suivre - et, éventuellement, suggérer comment résoudre ce problème - serait extrêmement utile pour communiquer ce que vous voulez dire.

Ce qui a été fait

Apprendre à un ordinateur à évaluer avec précision le niveau de cohérence d'un texte est un défi. À ce jour, la méthode la plus courante pour évaluer dans quelle mesure un ordinateur évalue la cohérence du discours est basée sur une tâche d'ordonnancement des phrases. Avec cette méthode, les chercheurs prennent un texte existant et bien édité, tel qu'un article de presse, et réorganisent au hasard toutes les phrases. L'hypothèse est que la permutation aléatoire peut être considérée comme incohérente et que l'ordre d'origine peut être considéré comme cohérent. La tâche consiste à construire un algorithme informatique capable de faire la distinction entre la version incohérente et l'original. Dans ces conditions, certains systèmes ont atteint jusqu'à 90 % de précision. Assez impressionnant.

Mais il y a un gros défaut potentiel avec cette méthode. Peut-être l'avez-vous déjà repéré. La réorganisation aléatoire des phrases peut produire un texte à faible cohérence, mais cela ne produit pas de texte qui ressemble à tout ce qu'un humain écrirait naturellement.

Chez Grammarly, nous nous concentrons sur la résolution de problèmes du monde réel, nous savions donc que tout travail que nous faisions dans ce domaine devrait être comparé à une écriture réelle, et non à des scénarios artificiels. Étonnamment, très peu de travaux testent les méthodes d'évaluation du discours sur des textes réels écrits par des personnes dans des circonstances ordinaires. Il est temps de changer cela.

Recherche du monde réel, écrivains du monde réel

Le premier problème que nous avons dû résoudre était le même que tous les autres chercheurs travaillant sur la cohérence du discours ont rencontré : un manque de données du monde réel. Il n'y avait pas de corpus existant de texte ordinaire écrit naturellement sur lequel tester nos algorithmes.

Nous avons créé un corpus en collectant des textes provenant de plusieurs sources publiques : Yahoo Answers, Yelp Reviews et des e-mails gouvernementaux et d'entreprise accessibles au public. Nous avons choisi ces sources spécifiques parce qu'elles représentent le genre de choses que les gens écrivent au cours d'une journée type : messages sur les forums, avis et e-mails.

Pour transformer tout ce texte en un corpus dont les algorithmes informatiques peuvent tirer des enseignements, nous devions également évaluer les niveaux de cohérence de chaque texte. Ce processus est appelé annotation. Quelle que soit la qualité de votre algorithme, une annotation bâclée faussera considérablement vos résultats. Dans notre article, nous fournissons des détails sur les nombreuses approches d'annotation que nous avons testées, y compris certaines qui impliquaient le crowdsourcing. Nous avons finalement décidé de demander à des annotateurs experts d'évaluer le niveau de cohérence de chaque texte sur une échelle à trois points (cohérence faible, moyenne ou élevée). Chaque morceau de texte a été jugé par trois annotateurs.

Mettre les algorithmes à l'épreuve

Une fois que nous avions le corpus, il était temps de tester avec quelle précision divers systèmes informatiques pouvaient identifier le niveau de cohérence d'un texte donné. Nous avons testé trois types de systèmes :

Dans la première catégorie se trouvent les modèles basés sur les entités. Ces systèmes suivent où et à quelle fréquence les mêmes entités sont mentionnées dans un texte. Par exemple, si le système trouve le mot « transport » dans plusieurs phrases, il le considère comme un signe que ces phrases sont logiquement liées les unes aux autres.

Dans la deuxième catégorie, nous avons testé un modèle basé sur un graphe de cohérence lexicale. C'est une façon de représenter des phrases sous forme de nœuds dans un graphique et de relier des phrases qui contiennent des paires de mots similaires. Par exemple, ce type de modèle relierait une phrase contenant « voiture » et une phrase contenant « camion », car les deux phrases concernent probablement des véhicules ou des moyens de transport.

Dans la troisième catégorie se trouvent les modèles de réseaux de neurones, ou d'apprentissage en profondeur. Nous en avons testé plusieurs, dont deux tout nouveaux modèles construits par l'équipe Grammarly. Ce sont des systèmes basés sur l'IA qui apprennent une représentation de chaque phrase qui capture son sens, et ils peuvent apprendre le sens général d'un document en combinant ces représentations de phrases. Ils peuvent rechercher des modèles qui ne se limitent pas aux occurrences d'entités ou aux paires de mots similaires.

La tâche de classement des phrases

Nous avons utilisé les textes à haute cohérence de notre nouveau corpus pour créer une tâche d'ordonnancement des phrases pour les trois types de modèles. Nous avons constaté que les modèles qui fonctionnaient bien sur d'autres ensembles de données d'ordonnancement des phrases fonctionnaient également bien sur notre ensemble de données, avec des performances atteignant une précision de 89 %. Les modèles basés sur les entités et les graphiques de cohérence lexicale ont montré une précision décente (généralement une précision de 60 à 70 %), mais ce sont les modèles neuronaux qui ont surpassé les autres modèles d'au moins dix points de pourcentage sur trois des quatre domaines.

Le vrai test d'écriture

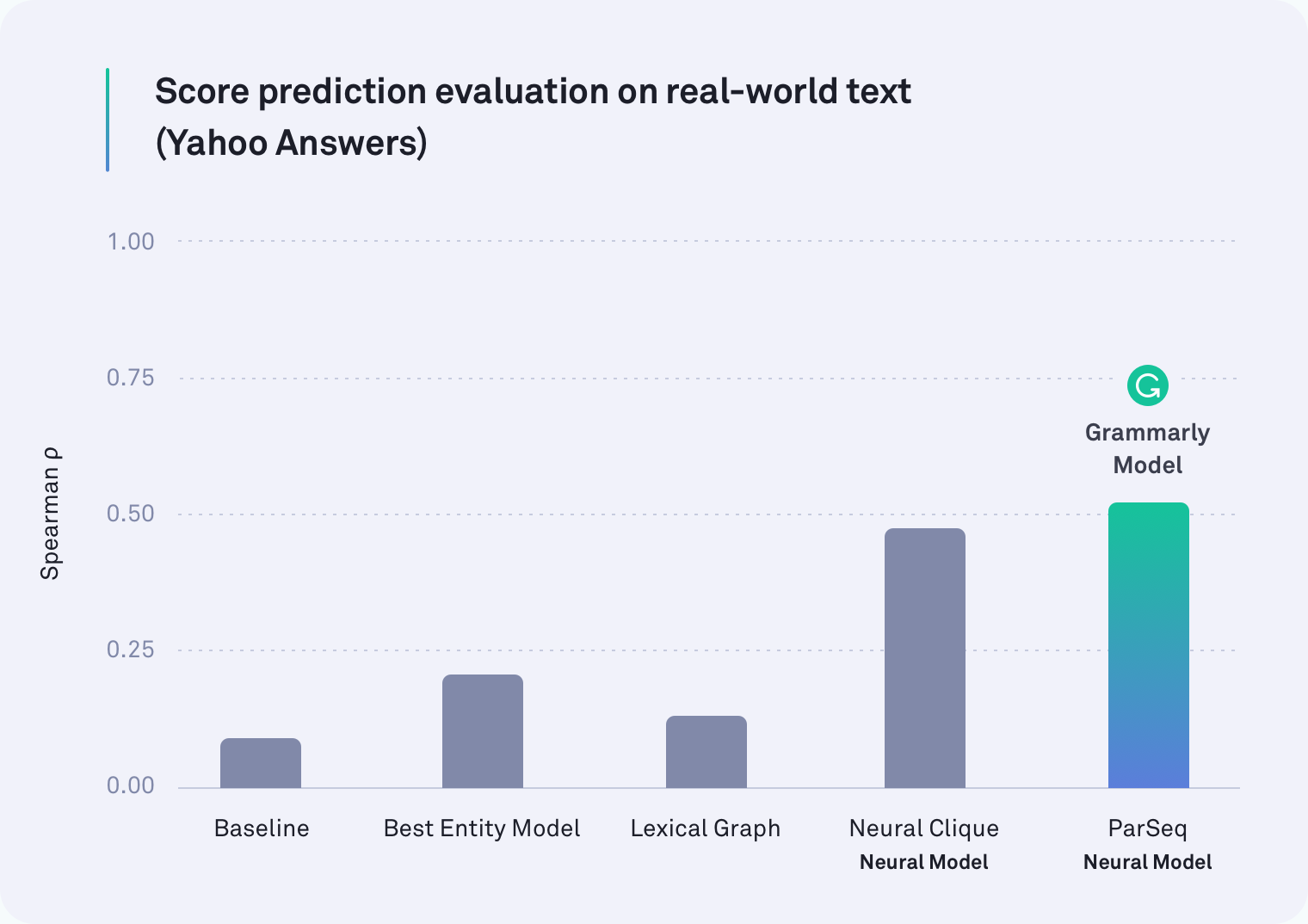

Ce que nous voulions vraiment savoir, c'était si l'un de ces modèles pouvait fonctionner au même niveau de précision sur du texte réel, écrit naturellement. Nous avons converti les étiquettes des annotateurs en valeurs numériques (faible = 1, moyen = 2, élevé = 3) et avons moyenné les nombres ensemble pour obtenir un score de cohérence pour chaque morceau de texte.

Dans chaque domaine, au moins un des systèmes basés sur un réseau de neurones a surpassé tous les autres. En fait, l'un des modèles de Grammarly qui prend en compte les sauts de paragraphe était le plus performant sur le texte de Yahoo Answers, comme indiqué dans le tableau ci-dessous. Le modèle Neural Clique, qui a été développé par des chercheurs de Stanford, a également été très performant.

Mais notre hypothèse de départ était correcte : tous les modèles ont obtenu de moins bons résultats sur la tâche du monde réel que sur la tâche d'ordre des phrases - certains étaient bien pires. Par exemple, la méthode du graphe lexical était précise à 78 % pour les e-mails d'entreprise dans le scénario de réorganisation artificielle des phrases, mais elle n'a réussi à atteindre que 45 % dans cette évaluation plus réaliste.

Ce que nous avons trouvé

Il s'avère que les travaux antérieurs sur la cohérence du discours ont testé la mauvaise chose. La tâche d'ordre des phrases n'est certainement pas un bon proxy pour mesurer la cohérence du discours. Nos résultats sont clairs : les systèmes qui fonctionnent bien dans le scénario artificiel s'en sortent bien moins bien avec le texte du monde réel.

Il est important de noter que cette découverte n'est pas un revers. Loin de ça, en fait. Une partie de la croissance de n'importe quel domaine consiste à évaluer comment vous évaluez - en vous arrêtant de temps en temps pour jeter un coup d'œil à ce que vous avez vraiment mesuré. Grâce à ces travaux, les chercheurs travaillant sur la cohérence du discours disposent désormais de deux informations importantes. L'un est l'idée que la tâche d'ordonnancement des phrases ne devrait plus être la façon dont nous mesurons l'exactitude. Le second est un corpus annoté accessible au public de texte du monde réel et de nouveaux repères (nos modèles neuronaux) à utiliser dans les recherches futures.

Avoir hâte de

Il reste encore du travail à faire et de nombreuses applications passionnantes pour un système capable de juger de manière fiable la cohérence du discours dans un texte. Un jour, un système comme celui-ci pourrait non seulement vous dire à quel point votre message global est cohérent, mais aussi souligner les passages spécifiques qui pourraient être difficiles à suivre. Un jour, nous espérons vous aider à rendre ces passages plus faciles à comprendre afin que ce que vous essayez de dire soit clair pour votre destinataire.

Après tout, le chemin de Grammarly pour devenir un assistant de communication complet ne consiste pas seulement à s'assurer que votre écriture est grammaticalement et stylistiquement exacte, il s'agit de s'assurer que vous êtes compris comme prévu.

—-

Joel Tetreault est directeur de recherche chez Grammarly. Alice Lai est doctorante à l'Université de l'Illinois à Urbana-Champaign et a été stagiaire de recherche à Grammarly. Cette recherche sera présentée à la conférence annuelle SIGDIAL 2018 à Melbourne, Australie, du 12 au 14 juillet 2018. Le document de recherche qui l'accompagne, intitulé « Discourse Coherence in the Wild : A Dataset, Evaluation and Methods » sera publié dans les Actes de la 19e réunion annuelle du Groupe d'intérêt spécial sur le discours et le dialogue. L'ensemble de données décrit dans cet article de blog s'appelle le corpus grammatical de cohérence du discours et peut être téléchargé gratuitement à des fins de recherche ici.