Score F1 dans l'apprentissage automatique: comment calculer, appliquer et l'utiliser efficacement

Publié: 2025-02-10Le score F1 est une métrique puissante pour évaluer les modèles d'apprentissage automatique (ML) conçus pour effectuer une classification binaire ou multiclasse. Cet article expliquera ce qu'est le score F1, pourquoi il est important, comment il est calculé et ses applications, avantages et limitations.

Table des matières

- Qu'est-ce qu'un score F1?

- Comment calculer un score F1

- Score F1 par rapport à la précision

- Applications du score F1

- Avantages du score F1

- Limites du score F1

Qu'est-ce qu'un score F1?

Les praticiens de la ML sont confrontés à un défi commun lors de la construction de modèles de classification: former le modèle pour attraper tous les cas tout en évitant les fausses alarmes. Ceci est particulièrement important dans les applications critiques telles que la détection de fraude financière et le diagnostic médical, où les fausses alarmes et les classifications importantes manquantes ont de graves conséquences. La réalisation du bon équilibre est particulièrement importante lorsque vous traitez avec des ensembles de données déséquilibrés, où une catégorie comme les transactions frauduleuses est beaucoup plus rare que l'autre catégorie (transactions légitimes).

Précision et rappel

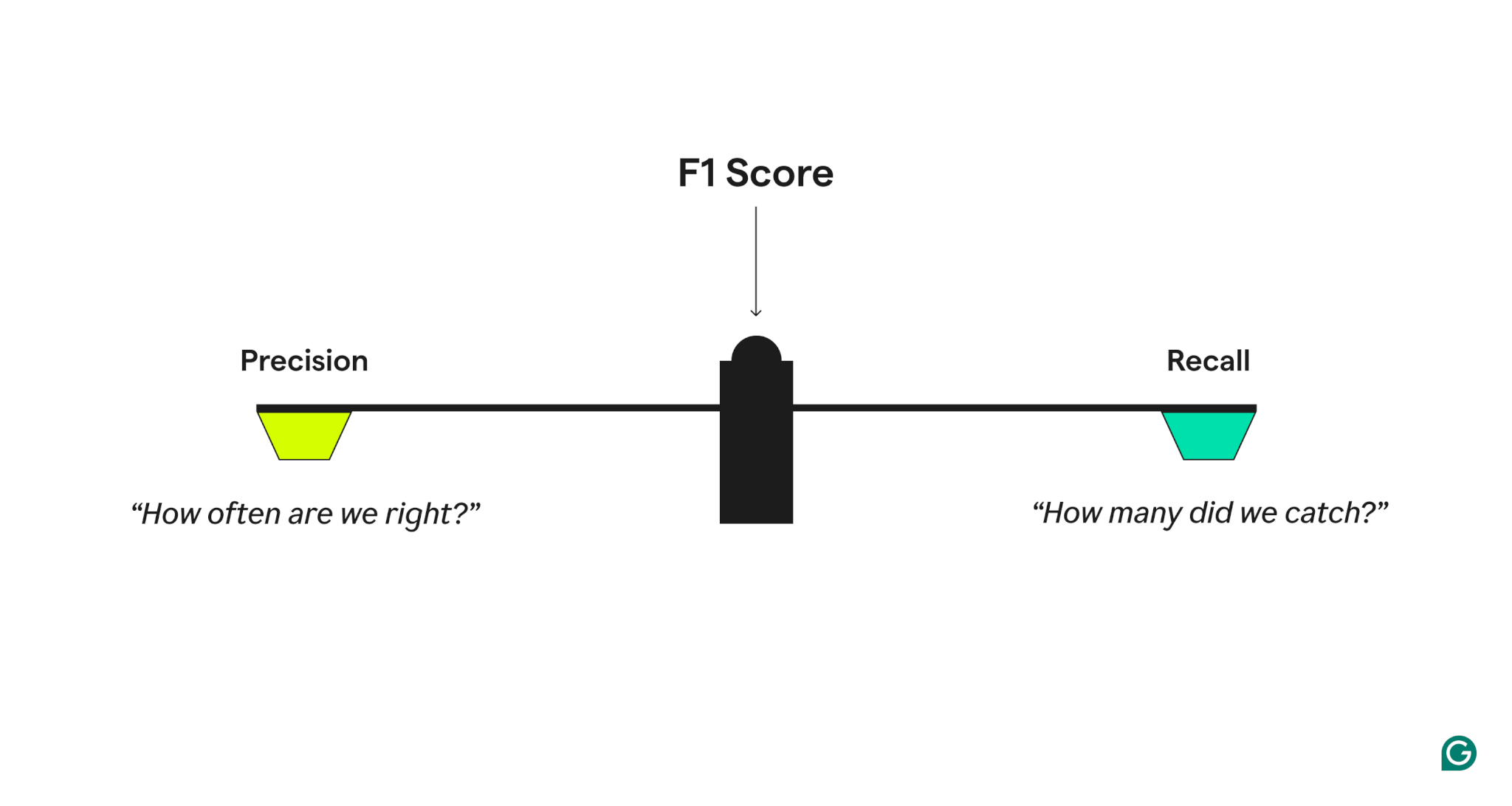

Pour mesurer la qualité des performances du modèle, le score F1 combine deux mesures connexes:

- Précision, qui répond: «Lorsque le modèle prédit un cas positif, à quelle fréquence est-il correct?»

- Rappelez-vous, qui répond, «de tous les cas positifs réels, combien le modèle a-t-il identifié correctement?»

Un modèle avec une haute précision mais un faible rappel est trop prudent, manquant de nombreux vrais positifs, tandis que celui avec un rappel élevé mais une faible précision est trop agressif, générant de nombreux faux positifs. Le score F1 établit un équilibre en prenant la moyenne harmonique de précision et de rappel, ce qui donne plus de poids aux valeurs plus faibles et garantit qu'un modèle fonctionne bien sur les deux métriques plutôt que d'excellent dans un seul.

Exemple de précision et de rappel

Pour mieux comprendre la précision et le rappel, considérez un système de détection de spam. Si le système a un taux élevé de signaler correctement les e-mails en tant que spam, cela signifie qu'il a une précision élevée. Par exemple, si le système signale 100 e-mails sous forme de spam et 90 d'entre eux sont en fait du spam, la précision est de 90%. Un rappel élevé, en revanche, signifie que le système attrape la plupart des e-mails de spam réels. Par exemple, s'il y a 200 e-mails de spam réels et que notre système en attrape 90, le rappel est de 45%.

Variants du score F1

Dans les systèmes ou scénarios de classification multiclasse avec des besoins spécifiques, le score F1 peut être calculé de différentes manières, selon les facteurs importants:

- Macro-F1:calcule le score F1 séparément pour chaque classe et prend la moyenne

- Micro-F1:calcule le rappel et la précision sur toutes les prédictions

- Pondéré-F1: similaire au macro-F1, mais les classes sont pondérées en fonction de la fréquence

Au-delà du score F1: la famille F-Score

Le score F1 fait partie d'une plus grande famille de métriques appelée F-Scores. Ces scores offrent différentes façons de pondérer la précision et le rappel:

- F2:met davantage l'accent sur le rappel, ce qui est utile lorsque les faux négatifs sont coûteux

- F0.5:met davantage l'accent sur la précision, ce qui est utile lorsque les faux positifs sont coûteux

Comment calculer un score F1

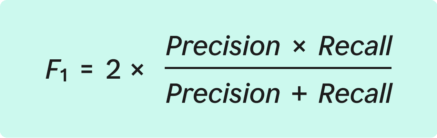

Le score F1 est défini mathématiquement comme la moyenne harmonique de précision et de rappel. Bien que cela puisse sembler complexe, le processus de calcul est simple lorsqu'il est décomposé en étapes claires.

La formule du score F1:

Avant de plonger dans les étapes pour calculer F1, il est important de comprendre les composantes clés de ce qu'on appelle unematrice de confusion, qui est utilisée pour organiser les résultats de la classification:

- True Positives (TP):le nombre de cas correctement identifiés comme positifs

- Faux positifs (FP):le nombre de cas mal identifiés comme positifs

- Faux négatifs (FN):le nombre de cas manqués (positifs réels qui n'ont pas été identifiés)

Le processus général consiste à entraîner le modèle, à tester les prédictions et à organiser les résultats, à calculer la précision et le rappel et le calcul du score F1.

Étape 1: entraîner un modèle de classification

Tout d'abord, un modèle doit être formé pour effectuer des classifications binaires ou multiples. Cela signifie que le modèle doit être en mesure de classer les cas comme appartenant à l'une des deux catégories. Les exemples incluent «spam / non spam» et «fraude / non fraude».

Étape 2: tester les prédictions et organiser les résultats

Ensuite, utilisez le modèle pour effectuer des classifications sur un ensemble de données séparé qui n'a pas été utilisé dans le cadre de la formation. Organisez les résultats dans la matrice de confusion. Cette matrice montre:

- TP: Combien de prédictions étaient réellement correctes

- FP: Combien de prédictions positives étaient incorrectes

- FN: Combien de cas positifs ont été manqués

La matrice de confusion donne un aperçu de la façon dont le modèle fonctionne.

Étape 3: Calculer la précision

En utilisant la matrice de confusion, la précision est calculée avec cette formule:

Par exemple, si un modèle de détection de spam a correctement identifié 90 e-mails de spam (TP) mais que les e-mails (FP) de 10 non-spam (FP) incorrectement signalés sont 0,90.

Étape 4: Calculer le rappel

Ensuite, calculez le rappel en utilisant la formule:

En utilisant l'exemple de détection de spam, s'il y avait 200 e-mails de spam totaux et que le modèle en a capturé 90 (TP) tout en manquant 110 (FN), le rappel est de 0,45.

Étape 5: Calculez le score F1

Avec les valeurs de précision et de rappel en main, le score F1 peut être calculé.

Le score F1 varie de 0 à 1. Lors de l'interprétation du score, considérez ces repères généraux:

- 0,9 ou plus:le modèle fonctionne très bien, mais doit être vérifié pour le sur-ajustement.

- 0,7 à 0,9:Bonnes performances pour la plupart des applications

- 0,5 à 0,7:Les performances sont OK, mais le modèle pourrait utiliser l'amélioration.

- 0,5 ou moins:le modèle fonctionne mal et nécessite une amélioration sérieuse.

En utilisant l'exemple de détection de spam pour les calculs de précision et de rappel, le score F1 serait de 0,60 ou 60%.

Dans ce cas, le score F1 indique que, même avec une haute précision, le rappel inférieur affecte les performances globales. Cela suggère qu'il y a place à améliorer la capture de plus de courriels de spam.

Score F1 par rapport à la précision

Alors que F1 etla précisionquantifient les performances du modèle, le score F1 fournit une mesure plus nuancée. La précision calcule simplement le pourcentage de prédictions correctes. Cependant, le simple fait de s'appuyer sur la précision pour mesurer les performances du modèle peut être problématique lorsque le nombre d'instances d'une catégorie dans un ensemble de données dépasse considérablement les autres catégories. Ce problème est appeléparadoxe de précision.

Pour comprendre ce problème, considérez l'exemple du système de détection de spam. Supposons qu'un système de messagerie reçoit 1 000 e-mails chaque jour, mais seulement 10 d'entre eux sont en fait du spam. Si la détection du spam classe simplement chaque e-mail comme non spam, il atteindra toujours une précision de 99%. En effet, 990 prédictions sur 1 000 étaient correctes, même si le modèle est en fait inutile en ce qui concerne la détection du spam. De toute évidence, la précision ne donne pas une image précise de la qualité du modèle.

Le score F1 évite ce problème en combinant les mesures de précision et de rappel. Par conséquent, F1 doit être utilisé au lieu de la précision dans les cas suivants:

- L'ensemble de données est déséquilibré.Ceci est courant dans des domaines comme le diagnostic de conditions médicales obscures ou la détection des spams, où une catégorie est relativement rare.

- FN et FP sont tous deux importants.Par exemple, les tests de dépistage médical cherchent à équilibrer la capture de problèmes réels en ne faisant pas de fausses alarmes.

- Le modèle doit trouver un équilibre entre être trop agressif et trop prudent.Par exemple, dans le filtrage du spam, un filtre trop prudent pourrait laisser passer trop de spam (rappel faible) mais faire rarement des erreurs (haute précision). D'un autre côté, un filtre trop agressif peut bloquer de vrais e-mails (faible précision) même s'il attrape tout le spam (rappel élevé).

Applications du score F1

Le score F1 a un large éventail d'applications dans diverses industries où une classification équilibrée est essentielle. Ces applications comprennent la détection de fraude financière, le diagnostic médical et la modération du contenu.

Détection de fraude financière

Les modèles conçus pour détecter la fraude financière sont une catégorie de systèmes bien adaptés à la mesure à l'aide du score F1. Les entreprises financières traitent souvent des millions ou des milliards de transactions par jour, les cas réels de fraude étant relativement rares. Pour cette raison, un système de détection de fraude doit prendre autant de transactions frauduleuses que possible tout en minimisant simultanément le nombre de fausses alarmes et les inconvénients qui en résultent les clients. La mesure du score F1 peut aider les institutions financières à déterminer dans quelle mesure leurs systèmes équilibrent les piliers jumeaux de la prévention de la fraude et une bonne expérience client.

Diagnostic médical

Dans le diagnostic médical et les tests, FN et FP ont tous deux de graves conséquences. Considérez l'exemple d'un modèle conçu pour détecter les formes rares de cancer. Le diagnostic de diagnostic à tort d'un patient en bonne santé pourrait entraîner un stress et un traitement inutiles, tandis que le manque de cancer a des conséquences désastreuses pour le patient. En d'autres termes, le modèle doit avoir à la fois une précision élevée et un rappel élevé, ce que le score F1 peut mesurer.

Modération du contenu

La modération du contenu est un défi commun dans les forums en ligne, les plateformes de médias sociaux et les marchés en ligne. Pour obtenir la sécurité des plateformes sans surcoupement, ces systèmes doivent équilibrer la précision et le rappel. Le score F1 peut aider les plateformes à déterminer dans quelle mesure leur système équilibre ces deux facteurs.

Avantages du score F1

En plus de fournir généralement une vision plus nuancée des performances du modèle que la précision, le score F1 offre plusieurs avantages clés lors de l'évaluation des performances du modèle de classification. Ces avantages incluent une formation et une optimisation plus rapides, des coûts de formation réduits et de la prise de sur-ajustement tôt.

Formation et optimisation du modèle plus rapide

Le score F1 peut aider à accélérer la formation des modèles en fournissant une métrique de référence claire qui peut être utilisée pour guider l'optimisation. Au lieu de régler le rappel et la précision séparément, ce qui implique généralement des compromis complexes, les praticiens de la ML peuvent se concentrer sur l'augmentation du score F1. Avec cette approche rationalisée, les paramètres optimaux du modèle peuvent être identifiés rapidement.

Réduction des coûts de formation

Le score F1 peut aider les praticiens ML à prendre des décisions éclairées sur le moment où un modèle est prêt pour le déploiement en fournissant une seule mesure unique de performance du modèle. Avec ces informations, les praticiens peuvent éviter les cycles de formation inutiles, les investissements dans les ressources informatiques et devoir acquérir ou créer des données de formation supplémentaires. Dans l'ensemble, cela peut entraîner des réductions de coûts substantielles lors des modèles de classification de formation.

Attraper un sur-ajustement tôt

Étant donné que le score F1 considère à la fois la précision et le rappel, il peut aider les praticiens de la ML à identifier lorsqu'un modèle est devenu trop spécialisé dans les données de formation. Ce problème, appelé sur-ajustement, est un problème courant avec les modèles de classification. Le score F1 donne aux praticiens un avertissement précoce qu'ils doivent ajuster la formation avant que le modèle n'atteigne un point où il n'est pas en mesure de généraliser sur les données du monde réel.

Limites du score F1

Malgré ses nombreux avantages, le score F1 a plusieurs limitations importantes que les praticiens devraient considérer. Ces limitations incluent un manque de sensibilité aux vrais négatifs, n'étant pas adaptés à certains ensembles de données, et être plus difficiles à interpréter pour les problèmes multiclasse.

Manque de sensibilité aux vrais négatifs

Le score F1 ne tient pas compte des vrais négatifs, ce qui signifie qu'il n'est pas bien adapté aux applications où la mesure est importante. Par exemple, considérez un système conçu pour identifier les conditions de conduite sûres. Dans ce cas, l'identification correcte lorsque les conditions sont vraiment sûres (véritables négatifs) est tout aussi important que d'identifier les conditions dangereuses. Parce qu'il ne suit pas FN, le score F1 ne capterait pas avec précision cet aspect des performances globales du modèle.

Non adapté pour certains ensembles de données

Le score F1 peut ne pas être adapté aux ensembles de données où l'impact de FP et FN est significativement différent. Considérez l'exemple d'un modèle de dépistage du cancer. Dans une telle situation, le manque de cas positif (FN) pourrait être mortel, tandis que la recherche à tort d'un cas positif (FP) ne conduit qu'à des tests supplémentaires. Ainsi, l'utilisation d'une métrique qui peut être pondérée pour tenir compte de ce coût est un meilleur choix que le score F1.

Plus difficile à interpréter pour les problèmes multicallasse

Alors que les variations telles que les scores Micro-F1 et Macro-F1 signifient que le score F1 peut être utilisé pour évaluer les systèmes de classification multiclasse, l'interprétation de ces mesures agrégées est souvent plus complexe que le score F1 binaire. Par exemple, le score Micro-F1 pourrait masquer de mauvaises performances dans la classification des classes moins fréquentes, tandis que le score Macro-F1 pourrait en surpoids les classes rares. Compte tenu de cela, les entreprises doivent déterminer si un traitement égal des classes ou des performances globales au niveau de l'instance est plus important lors du choix de la bonne variante F1 pour les modèles de classification multi-classes.