Qu’est-ce que la régression linéaire dans l’apprentissage automatique ?

Publié: 2024-09-06La régression linéaire est une technique fondamentale de l'analyse des données et de l'apprentissage automatique (ML). Ce guide vous aidera à comprendre la régression linéaire, comment elle est construite, ainsi que ses types, applications, avantages et inconvénients.

Table des matières

- Qu’est-ce que la régression linéaire ?

- Types de régression linéaire

- Régression linéaire vs régression logistique

- Comment fonctionne la régression linéaire ?

- Applications de la régression linéaire

- Avantages de la régression linéaire en ML

- Inconvénients de la régression linéaire en ML

Qu’est-ce que la régression linéaire ?

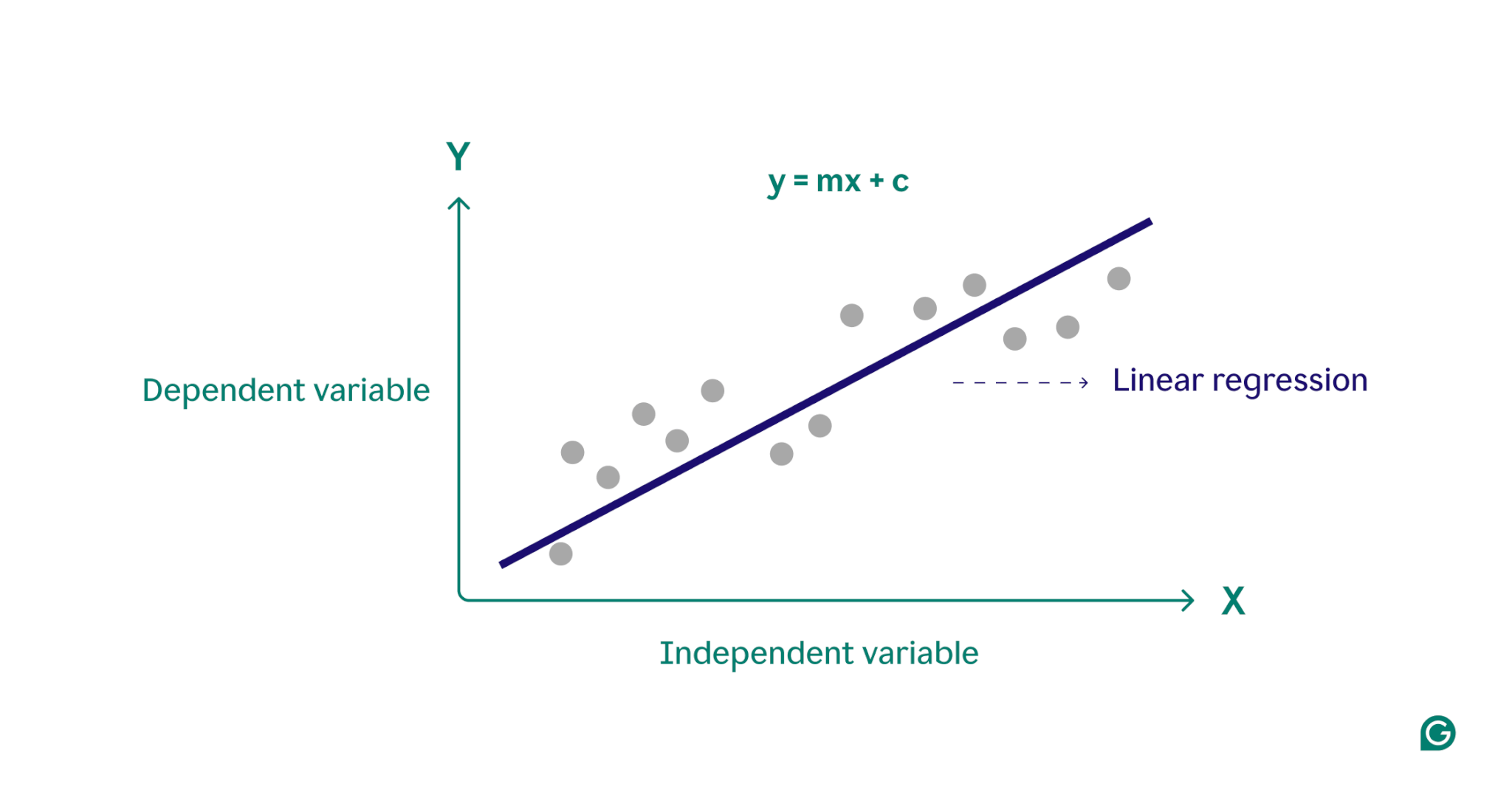

La régression linéaire est une méthode statistique utilisée en apprentissage automatique pour modéliser la relation entre une variable dépendante et une ou plusieurs variables indépendantes. Il modélise les relations en ajustant une équation linéaire aux données observées, servant souvent de point de départ à des algorithmes plus complexes et est largement utilisé dans l'analyse prédictive.

Essentiellement, la régression linéaire modélise la relation entre une variable dépendante (le résultat que vous souhaitez prédire) et une ou plusieurs variables indépendantes (les caractéristiques d'entrée que vous utilisez pour la prédiction) en trouvant la ligne droite la mieux ajustée à travers un ensemble de points de données. Cette ligne, appeléeligne de régression, représente la relation entre la variable dépendante (le résultat que nous voulons prédire) et la ou les variables indépendantes (les caractéristiques d'entrée que nous utilisons pour la prédiction). L’équation d’une droite de régression linéaire simple est définie comme :

y = mx + c

où y est la variable dépendante, x est la variable indépendante, m est la pente de la droite et c est l'ordonnée à l'origine. Cette équation fournit un modèle mathématique pour mapper les entrées aux sorties prédites, dans le but de minimiser les différences entre les valeurs prédites et observées, appelées résidus. En minimisant ces résidus, la régression linéaire produit un modèle qui représente le mieux les données.

Conceptuellement, la régression linéaire peut être visualisée comme le tracé d'une ligne droite passant par des points sur un graphique pour déterminer s'il existe une relation entre ces points de données. Le modèle de régression linéaire idéal pour un ensemble de points de données est la ligne qui se rapproche le mieux des valeurs de chaque point de l'ensemble de données.

Types de régression linéaire

Il existe deux principaux types de régression linéaire :la régression linéaire simpleetla régression linéaire multiple.

Régression linéaire simple

La régression linéaire simple modélise la relation entre une seule variable indépendante et une variable dépendante à l'aide d'une ligne droite. L’équation de la régression linéaire simple est la suivante :

y = mx + c

où y est la variable dépendante, x est la variable indépendante, m est la pente de la droite et c est l'ordonnée à l'origine.

Cette méthode est un moyen simple d’obtenir des informations claires lorsqu’il s’agit de scénarios à variable unique. Imaginez un médecin essayant de comprendre comment la taille du patient affecte son poids. En traçant chaque variable sur un graphique et en trouvant la ligne la mieux ajustée à l'aide d'une simple régression linéaire, le médecin pouvait prédire le poids d'un patient en fonction uniquement de sa taille.

Régression linéaire multiple

La régression linéaire multiple étend le concept de régression linéaire simple pour s'adapter à plus d'une variable, permettant ainsi d'analyser l'impact de plusieurs facteurs sur la variable dépendante. L'équation de la régression linéaire multiple est la suivante :

y = b 0 + b 1 x 1 + b 2 x 2 + … + b n x n

où y est la variable dépendante, x 1 , x 2 , …, x n sont les variables indépendantes, et b 1 , b 2 , …, b n sont les coefficients décrivant la relation entre chaque variable indépendante et la variable dépendante.

À titre d’exemple, considérons un agent immobilier qui souhaite estimer les prix des logements. L’agent pourrait utiliser une simple régression linéaire basée sur une seule variable, comme la taille de la maison ou le code postal, mais ce modèle serait trop simpliste, car les prix des logements sont souvent déterminés par une interaction complexe de plusieurs facteurs. Une régression linéaire multiple, intégrant des variables telles que la taille de la maison, le quartier et le nombre de chambres, fournira probablement un modèle de prédiction plus précis.

Régression linéaire vs régression logistique

La régression linéaire est souvent confondue avec la régression logistique. Alors que la régression linéaire prédit les résultats sur des variablescontinues, la régression logistique est utilisée lorsque la variable dépendante estcatégorielle, souvent binaire (oui ou non). Les variables catégorielles définissent des groupes non numériques avec un nombre fini de catégories, comme la tranche d'âge ou le mode de paiement. Les variables continues, quant à elles, peuvent prendre n’importe quelle valeur numérique et sont mesurables. Des exemples de variables continues incluent le poids, le prix et la température quotidienne.

Contrairement à la fonction linéaire utilisée dans la régression linéaire, la régression logistique modélise la probabilité d'un résultat catégoriel à l'aide d'une courbe en forme de S appelée fonction logistique. Dans l'exemple de classification binaire, les points de données appartenant à la catégorie « oui » se trouvent d'un côté de la forme en S, tandis que les points de données de la catégorie « non » se trouvent de l'autre côté. En pratique, la régression logistique peut être utilisée pour déterminer si un e-mail est du spam ou non, ou prédire si un client achètera un produit ou non. Essentiellement, la régression linéaire est utilisée pour prédire des valeurs quantitatives, tandis que la régression logistique est utilisée pour les tâches de classification.

Comment fonctionne la régression linéaire ?

La régression linéaire fonctionne en trouvant la ligne la mieux ajustée à travers un ensemble de points de données. Ce processus implique :

1 Sélection du modèle :Dans la première étape, l'équation linéaire appropriée pour décrire la relation entre les variables dépendantes et indépendantes est sélectionnée.

2 Ajustement du modèle :Ensuite, une technique appelée moindres carrés ordinaires (OLS) est utilisée pour minimiser la somme des carrés des différences entre les valeurs observées et les valeurs prédites par le modèle. Cela se fait en ajustant la pente et l'interception de la ligne pour trouver le meilleur ajustement. Le but de cette méthode est de minimiser l’erreur, ou la différence, entre les valeurs prédites et réelles. Ce processus d'ajustement est un élément essentiel de l'apprentissage automatique supervisé, dans lequel le modèle apprend à partir des données d'entraînement.

3 Évaluation du modèle : dans la dernière étape, la qualité de l'ajustement est évaluée à l'aide de mesures telles que le R au carré, qui mesure la proportion de la variance de la variable dépendante qui est prévisible à partir des variables indépendantes. En d’autres termes, le R au carré mesure dans quelle mesure les données correspondent réellement au modèle de régression.

Ce processus génère un modèle d’apprentissage automatique qui peut ensuite être utilisé pour effectuer des prédictions basées sur de nouvelles données.

Applications de la régression linéaire en ML

En apprentissage automatique, la régression linéaire est un outil couramment utilisé pour prédire les résultats et comprendre les relations entre les variables dans divers domaines. Voici quelques exemples notables de ses applications :

Prévoir les dépenses de consommation

Les niveaux de revenu peuvent être utilisés dans un modèle de régression linéaire pour prédire les dépenses de consommation. Plus précisément, la régression linéaire multiple pourrait intégrer des facteurs tels que le revenu historique, l’âge et la situation professionnelle pour fournir une analyse complète. Cela peut aider les économistes à élaborer des politiques économiques fondées sur les données et aider les entreprises à mieux comprendre les modèles de comportement des consommateurs.

Analyser l'impact marketing

Les spécialistes du marketing peuvent utiliser la régression linéaire pour comprendre comment les dépenses publicitaires affectent les revenus des ventes. En appliquant un modèle de régression linéaire aux données historiques, les revenus de ventes futurs peuvent être prédits, permettant aux spécialistes du marketing d'optimiser leurs budgets et leurs stratégies publicitaires pour un impact maximal.

Prédire les cours des actions

Dans le monde de la finance, la régression linéaire est l’une des nombreuses méthodes utilisées pour prédire les cours des actions. À l’aide de données boursières historiques et de divers indicateurs économiques, les analystes et les investisseurs peuvent créer plusieurs modèles de régression linéaire qui les aident à prendre des décisions d’investissement plus judicieuses.

Prévision des conditions environnementales

En sciences de l’environnement, la régression linéaire peut être utilisée pour prévoir les conditions environnementales. Par exemple, divers facteurs tels que le volume de trafic, les conditions météorologiques et la densité de population peuvent aider à prédire les niveaux de polluants. Ces modèles d'apprentissage automatique peuvent ensuite être utilisés par les décideurs politiques, les scientifiques et d'autres parties prenantes pour comprendre et atténuer les impacts de diverses actions sur l'environnement.

Avantages de la régression linéaire en ML

La régression linéaire offre plusieurs avantages qui en font une technique clé en apprentissage automatique.

Simple à utiliser et à mettre en œuvre

Comparée à la plupart des outils et modèles mathématiques, la régression linéaire est facile à comprendre et à appliquer. Il s’agit d’un point de départ particulièrement intéressant pour les nouveaux praticiens de l’apprentissage automatique, car il fournit des informations et une expérience précieuses comme base pour des algorithmes plus avancés.

Efficacité informatique

Les modèles d’apprentissage automatique peuvent être gourmands en ressources. La régression linéaire nécessite une puissance de calcul relativement faible par rapport à de nombreux algorithmes et peut néanmoins fournir des informations prédictives significatives.

Des résultats interprétables

Les modèles statistiques avancés, bien que puissants, sont souvent difficiles à interpréter. Avec un modèle simple comme la régression linéaire, la relation entre les variables est facile à comprendre et l'impact de chaque variable est clairement indiqué par son coefficient.

Fondation pour les techniques avancées

Comprendre et mettre en œuvre la régression linéaire offre une base solide pour explorer des méthodes d'apprentissage automatique plus avancées. Par exemple, la régression polynomiale s'appuie sur la régression linéaire pour décrire des relations non linéaires plus complexes entre les variables.

Inconvénients de la régression linéaire en ML

Bien que la régression linéaire soit un outil précieux en apprentissage automatique, elle présente plusieurs limites notables. Comprendre ces inconvénients est essentiel pour sélectionner l’outil d’apprentissage automatique approprié.

En supposant une relation linéaire

Le modèle de régression linéaire suppose que la relation entre les variables dépendantes et indépendantes est linéaire. Dans des scénarios complexes du monde réel, cela n’est pas toujours le cas. Par exemple, la taille d'une personne au cours de sa vie n'est pas linéaire, la croissance rapide survenue pendant l'enfance ralentissant et s'arrêtant à l'âge adulte. Ainsi, la prévision de la hauteur à l’aide d’une régression linéaire pourrait conduire à des prédictions inexactes.

Sensibilité aux valeurs aberrantes

Les valeurs aberrantes sont des points de données qui s'écartent considérablement de la majorité des observations d'un ensemble de données. S’ils ne sont pas traités correctement, ces valeurs extrêmes peuvent fausser les résultats, conduisant à des conclusions inexactes. En apprentissage automatique, cette sensibilité signifie que les valeurs aberrantes peuvent affecter de manière disproportionnée la précision prédictive et la fiabilité du modèle.

Multicolinéarité

Dans les modèles de régression linéaire multiple, des variables indépendantes hautement corrélées peuvent fausser les résultats, phénomène connu sous le nom demulticolinéarité. Par exemple, le nombre de chambres dans une maison et sa taille peuvent être fortement corrélés puisque les maisons plus grandes ont tendance à avoir plus de chambres. Cela peut rendre difficile la détermination de l’impact individuel de variables individuelles sur les prix de l’immobilier, conduisant à des résultats peu fiables.

En supposant une propagation d'erreur constante

La régression linéaire suppose que les différences entre les valeurs observées et prédites (la propagation des erreurs) sont les mêmes pour toutes les variables indépendantes. Si ce n’est pas vrai, les prédictions générées par le modèle risquent de ne pas être fiables. Dans le cadre de l’apprentissage automatique supervisé, le fait de ne pas remédier à la propagation des erreurs peut amener le modèle à générer des estimations biaisées et inefficaces, réduisant ainsi son efficacité globale.