Grammarlyのフードの下で:AIで文体を変革する

公開: 2018-05-31あなたが書いている誰かに良い印象を与える必要があるとき、あなたが考える必要があるのはあなたが言うことだけではありません。 あなたがそれをどのように言うかは、しばしば同じくらい重要です。 適切なレベルの形式を選択することは、特定の課題になる可能性があります。これはコンテキストに大きく依存し、受信者があなたのトーンをどのように解釈するかを推測する必要があります。

カバーレターを書いていると想像してみてください。 執筆がカジュアルすぎる(または、さらに悪いことに、フォーマルすぎる)場合を検出できるツールがあれば、ゲームチェンジャーはどれくらいになるでしょうか。 突然、あなたが言おうとしていることをどのように言うかについてのあなたの決定は、はるかに曖昧になります。 受信者がメッセージをどのように認識するかについて推測に頼っているだけではありません。個人的に持っていない大量のデータを利用するアルゴリズムがあります。 さらに一歩進んで、このツールが何かがオフになっているときに通知するだけでなく、受信者がより良いと思う代替の言い回しを実際に提供できるとしたらどうでしょうか。

コンピューターにあるスタイルから別のスタイルに文章を自動的に変換させるプロセスは、スタイル転送と呼ばれ、同僚のSudhaRaoと一緒に書いた次の論文の主題です。 正しい方法でコミュニケーションすることがいかに重要であるかを知っているので、ここGrammarlyで私たちが特に関心を持っている分野です。

Grammarlyの研究エンジニアが、執筆の提案を提供するシステムをどのように構築しているか疑問に思ったことがある場合は、このまま読み進めてください。

形式に関する非公式の背景

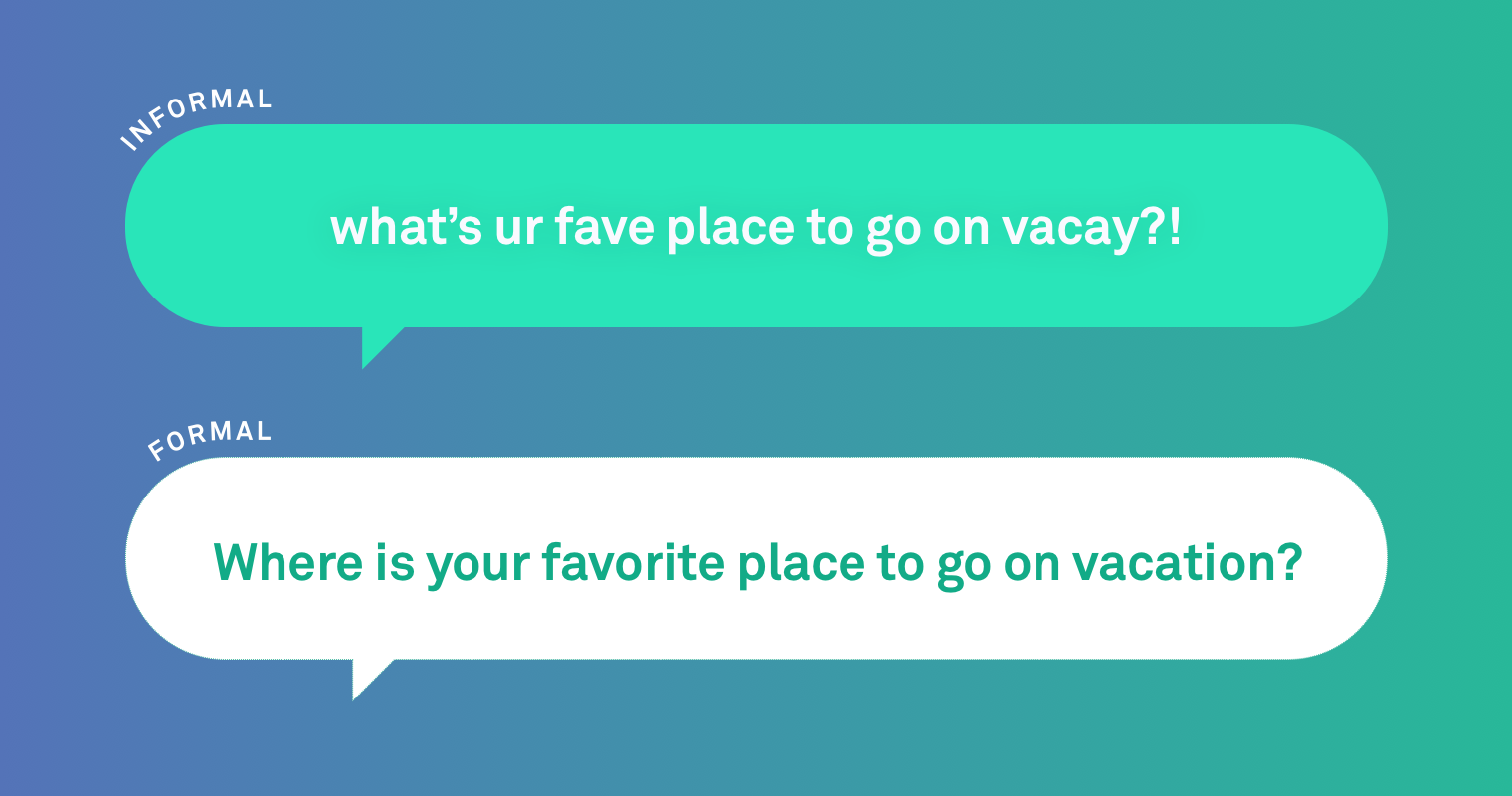

アルゴリズムの詳細に飛び込む前に、非公式言語と形式言語の例を見てみましょう。

非公式:ストーリーの両面を見る必要があります

正式:ストーリーの両面を見る必要があります。

これらの文の間には明らかな違いがいくつかあります。 スラング(「お奨め」)の使用と最初の文の終わりの句読点の欠如は、非公式を示します。 この種の文章には時間と場所があります。たとえば、友達同士のテキストメッセージ交換などです。

人間が非公式の文をより正式なスタイルで書き直す方法を調べたところ、最も頻繁に行われた変更には、大文字と小文字の区別、句読点、口語表現が含まれていることがわかりました。 また、人間は、形式を改善するために、文をより大幅に書き直さなければならない場合があることにも気づきました。

非公式:いつ会議に参加しますか?

正式:会議にいつ出席するか教えてください。

しかし、上記のような編集を行うようにコンピューターにどのように教えるのでしょうか。 問題に取り組むにはいくつかの方法があります。

私たちが使用しているのは、コンピューターに文体間の翻訳を教えることは、言語を翻訳することを教えることに似ていることを認めています。 このアプローチは機械翻訳と呼ばれ、コンピューターが1つの言語(フランス語など)から別の言語(ドイツ語)に自動的に翻訳します。 したがって、スタイル転送の問題に取り組むときは、翻訳モデル、またはこの場合は複数のモデルから始めるのが理にかなっています。

翻訳モデルとは何ですか?

AIにおける最近のブレークスルーの1つは、機械翻訳モデルを構築するためのディープラーニングまたはニューラルネットワークの手法の使用です。

ニューラル機械翻訳(NMT)モデルは、文の根本的な意味の表現を学習できます。 これは、モデルが複雑な文型を学習するのに役立ち、翻訳が流暢になり、その意味が元の文に忠実になります。

ルールベースまたはフレーズベースのモデル(PBMT)などの機械翻訳への古いアプローチでは、文を単語やフレーズなどの小さな単位に分割し、それらを個別に翻訳します。 これにより、翻訳で文法エラーや無意味な結果が生じる可能性があります。 ただし、これらのモデルは微調整が簡単で、より保守的である傾向があります。これは利点となる可能性があります。 たとえば、スラングを標準の単語に変更するルールを簡単に組み込むことができます。

機械翻訳へのいくつかの異なるアプローチを調べて、スタイル転送に最適なものを確認しました。

モデルの構築

NMTとPBMTには課題がたくさんありますが、その中でも特に、モデルをトレーニングするための適切なデータセットを見つけることが重要です。 この場合、数十万の非公式および公式の文のペアのデータセットが必要になると推定しました。 理想的には、数百万の文のペアを使用してモデルをトレーニングしますが、スタイル転送は自然言語処理の分野ではかなり新しい分野であるため、使用できる既存のデータセットは実際にはありませんでした。 そこで、作成しました。

私たちは非公式の文章を集めることから始めました。 Yahoo!に公開されている質問と回答から文章を入手しました。 答え。 このセットから10万を超える非公式の文を自動的に選択し、チームに、事前定義された基準を使用して、それぞれを形式言語で書き直してもらいました。 (このプロセスの詳細については、私たちの論文をチェックしてください。)

データセットを取得したら、モデルのトレーニングを開始できます。 モデルをトレーニングするということは、多くの「ソース」センテンス(この場合は非公式のセンテンス)と多くの「ターゲット」センテンスをモデルに与えることを意味します。これらは正式な書き直しです。 次に、モデルのアルゴリズムはパターンを探して、ソースからターゲットに到達する方法を見つけます。 データが多ければ多いほど、学習は向上します。

私たちの場合、モデルには10万の非公式のソース文があり、それらから学ぶための正式な書き直しがあります。 また、トレーニングデータセットのサイズを大きくするために、人工的な正式なデータを作成するさまざまな方法を試しました。これは、NMTおよびPBMTモデルを適切に実行するには、多くの場合、より多くのデータが必要になるためです。

ただし、モデルがそのタスクをどの程度達成しているかを評価する方法も必要です。 文の意味は変わりましたか? 新しい文は文法的に正しいですか? それは実際にはもっと正式ですか? そこには分類子があります—トーンと文体について文を自動的に評価できるプログラム—そして私たちは学界で最も一般的に使用されているもののいくつかをテストしました。 ただし、どれも非常に正確ではありません。 そのため、テストしたさまざまなモデルの出力を人間に比較させ、形式、正確さ、流暢さでランク付けすることになりました。

私たちは、元の非公式の文章、いくつかの異なるモデルからの出力、および人間による書き直しをチームに示しました。 誰が、または何が各文を生成したかは伝えませんでした。 次に、彼らは書き直しをランク付けし、同点を認めました。 理想的には、最良のモデルは人間の書き直しと結びついているか、それよりも優れているでしょう。 全部で、チームは500の非公式の文章の書き直しを記録しました。

私たちが見つけたもの

とにかく、数十のモデルをテストしましたが、ルールベース、フレーズベース(PBMT)、ニューラルネットワークベース(NMT)、およびさまざまなアプローチを組み合わせたいくつかの上位モデルに焦点を当てます。

人間による書き換えは全体的に最高のスコアを記録しましたが、PBMTモデルとNMTモデルはそれほど遅れていませんでした。 実際、人間がモデルの出力を人間の出力よりも好む場合がいくつかありました。 これらの2つのモデルは、より大規模な書き直しを行いましたが、元の文の意味を変更する傾向がありました。

一方、ルールベースのモデルでは、小さな変更が加えられました。 これは、彼らが意味を保存することに優れていたが、彼らが作成した文はあまり形式的ではなかったことを意味しました。 すべてのモデルは、長い文よりも短い文を処理する方が簡単でした。

以下は、人間とモデルを書き直した非公式の文の例です。 この特定のケースでは、形式、意味、および自然な響きの言い回しの間で最良のバランスをとったのは、最後のモデル(PBMT翻訳を使用したNMT)でした。

元の非公式:私は学校で彼に会うことはほとんどありません。通常、兄弟のバスケットボールの試合で彼に会います。

人間の書き直し:私は学校で彼に会うことはほとんどありません。 私はいつも彼が私の兄弟とバスケットボールをしているのを見ます。

ルールベースのモデル:私は学校で彼に会うことはほとんどありません。通常、兄弟のバスケットボールの試合で彼に会います。

PBMTモデル:学校でも彼を見かけることはほとんどありませんが、兄弟のバスケットボールの試合です。

NMTモデル:学校で彼に会うことはめったにありません。兄のバスケットボールの試合でも彼に会います。

NMT(追加のPBMT生成データでトレーニング済み):学校で彼に会うことはめったにありません。通常、兄弟のバスケットボールの試合で彼に会います。

スタイル転送は、自然言語処理のエキサイティングな新しい領域であり、広範なアプリケーションの可能性があります。 私が最初に仮定したそのツール—あなたが言う必要があることを言う方法を理解するのを助けるもの? やるべきことはまだたくさんありますが、そのツールは可能であり、求職者、語学学習者、そして執筆を通じて誰かに良い印象を与える必要がある人にとっては非常に貴重です。 私たちのデータを公開することで、私たちとこの分野の他の人々がお互いにベンチマークを行い、この分野の研究を前進させる方法があることを願っています。

Grammarlyに関しては、この作業は、メッセージを意図したとおりに理解するのに役立つ包括的なコミュニケーションアシスタントを作成するという私たちのビジョンに向けたさらに別のステップです。

Joel Tetreaultは、Grammarlyのリサーチディレクターです。 Sudha Raoは、メリーランド大学の博士課程の学生であり、Grammarlyの研究インターンでした。 JoelとSudhaは、2018年6月1日から6日まで、計算言語学協会の北米支部の第16回年次会議でこの研究を発表します。 、「GYAFCデータセットを紹介しますか:形式的スタイル転送のためのコーパス、ベンチマーク、およびメトリック」は、NAACLの議事録に掲載されます。