Pod maską w Grammarly: wykrywanie dezorganizacji pisania za pomocą sztucznej inteligencji

Opublikowany: 2018-07-10Ilekroć piszesz coś dłuższego niż zdanie, musisz podjąć decyzję, jak zorganizować i przedstawić swoje myśli. Dobre pisanie jest łatwe do zrozumienia, ponieważ każde zdanie opiera się na poprzednich. Kiedy temat się zmienia, silni pisarze używają zdań przejściowych i łamania akapitów jako drogowskazów, aby powiedzieć czytelnikom, czego mogą się spodziewać w następnej kolejności.

Językoznawcy nazywają ten aspekt spójnością pisania dyskursu i jest on przedmiotem kilku fajnych nowych badań zespołu Grammarly Research, które pojawią się w tym tygodniu na konferencji SIGDIAL w Melbourne w Australii.

Czym jest spójność dyskursu i po co się nią zajmować?

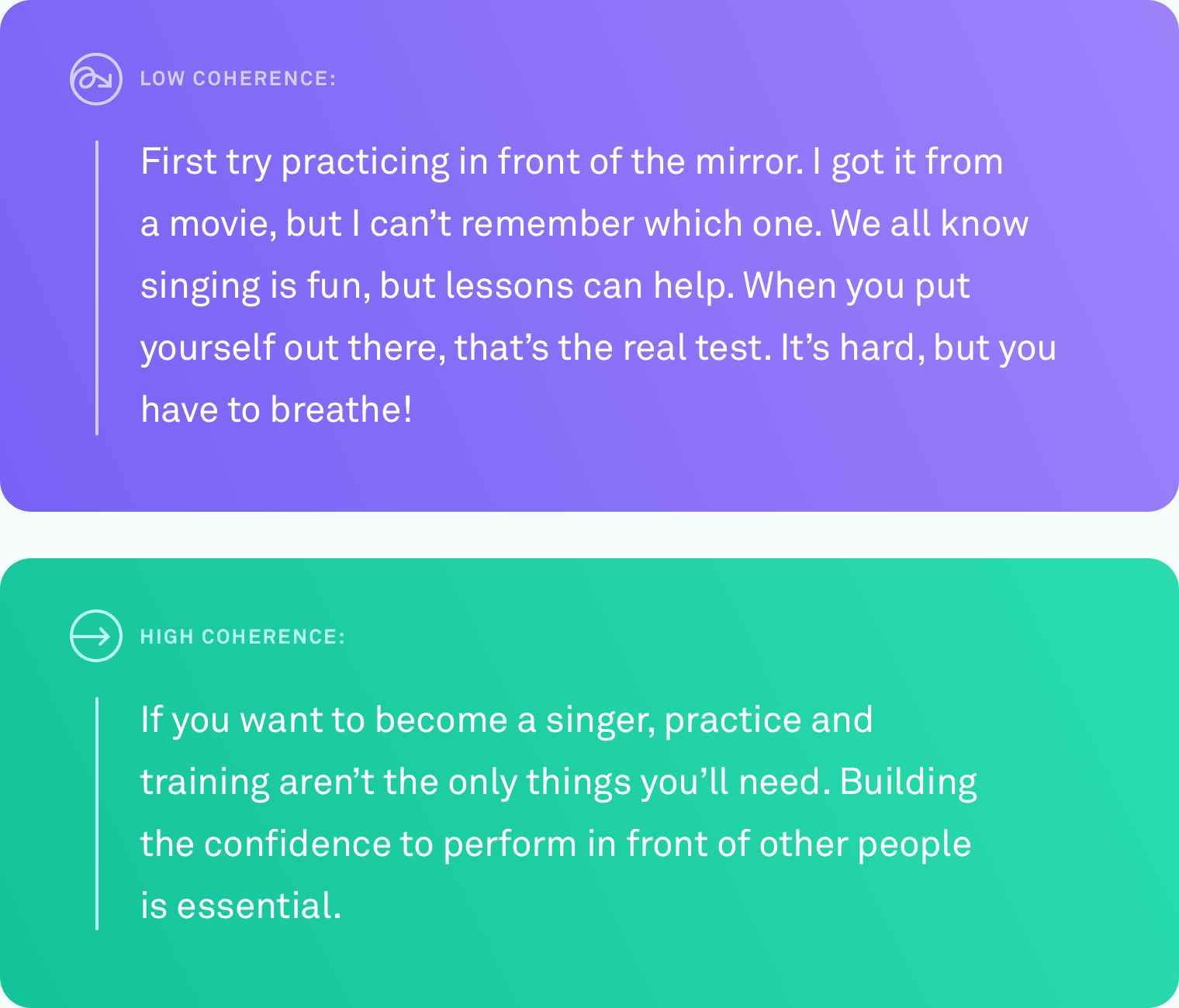

Kiedy mówimy, że tekst ma wysoki poziom spójności dyskursu, mamy na myśli, że wszystkie zdania są ze sobą powiązane logicznie. Pisarz nie schodzi z tematu. Różne punkty są połączone przejściami. Tekst jest łatwy do zrozumienia od początku do końca.

Ten rodzaj organizacji nie zawsze przychodzi naturalnie. Niewielu z nas myśli w idealnie liniowych ciągach pomysłów. System, który automatycznie powie ci, kiedy napiszesz coś, co inni ludzie będą mieli trudności z naśladowaniem – iw końcu zasugeruje, jak to naprawić – byłby niezwykle pomocny w komunikowaniu tego, co masz na myśli.

Co zostało zrobione

Nauczenie komputera dokładnego oceniania poziomu spójności tekstu jest wyzwaniem. Do tej pory najczęstszą metodą oceny, jak dobrze komputer ocenia spójność dyskursu, jest zadanie porządkowania zdań. Dzięki tej metodzie badacze biorą istniejący, dobrze zredagowany fragment tekstu, taki jak artykuł z wiadomościami, i losowo zmieniają kolejność wszystkich zdań. Zakłada się, że losową permutację można postrzegać jako niespójną, a pierwotną kolejność można postrzegać jako spójną. Zadaniem jest zbudowanie algorytmu komputerowego, który potrafi odróżnić wersję niespójną od oryginału. W tych warunkach niektóre systemy osiągnęły nawet 90 procent dokładności. Naprawdę imponujące.

Ale ta metoda ma duży potencjalny błąd. Może już to zauważyłeś. Losowa zmiana kolejności zdań może dawać tekst o niskiej spójności, ale nie tworzy tekstu, który wygląda jak wszystko, co napisałby człowiek.

W Grammarly skupiamy się na rozwiązywaniu rzeczywistych problemów, więc wiedzieliśmy, że każda praca, którą wykonaliśmy w tej dziedzinie, będzie musiała być porównana z prawdziwym pisaniem, a nie sztucznymi scenariuszami. Zaskakujące jest to, że wykonano bardzo niewiele prac testujących metody oceny dyskursu na prawdziwym tekście pisanym przez ludzi w zwykłych okolicznościach. Czas to zmienić.

Badania w świecie rzeczywistym, pisarze w świecie rzeczywistym

Pierwszym problemem, który musieliśmy rozwiązać, był ten sam, z którym borykał się każdy inny badacz zajmujący się spójnością dyskursu: brak danych ze świata rzeczywistego. Nie istniał żaden korpus zwykłego, naturalnie napisanego tekstu, na którym moglibyśmy przetestować nasze algorytmy.

Stworzyliśmy korpus, zbierając tekst z kilku źródeł publicznych: Yahoo Answers, Yelp Reviews oraz publicznie dostępnymi e-mailami rządowymi i firmowymi. Wybraliśmy te konkretne źródła, ponieważ reprezentują one rodzaje rzeczy, które ludzie piszą w typowy dzień — posty na forum, recenzje i e-maile.

Aby przekształcić cały ten tekst w korpus, z którego algorytmy komputerowe mogą się uczyć, musieliśmy również ocenić poziomy spójności każdego tekstu. Ten proces nazywa się adnotacją. Bez względu na to, jak dobry jest Twój algorytm, niechlujna adnotacja drastycznie zniekształci Twoje wyniki. W naszym artykule przedstawiamy szczegółowe informacje na temat wielu testowanych przez nas podejść do adnotacji, w tym takich, które obejmowały crowdsourcing. Ostatecznie zdecydowaliśmy, że eksperci z adnotacjami ocenią poziom spójności każdego fragmentu tekstu w trzystopniowej skali (niska, średnia lub wysoka spójność). Każdy fragment tekstu był oceniany przez trzech adnotatorów.

Testowanie algorytmów

Kiedy już mieliśmy korpus, nadszedł czas, aby sprawdzić, jak dokładnie różne systemy komputerowe potrafią określić poziom spójności danego fragmentu tekstu. Przetestowaliśmy trzy rodzaje systemów:

W pierwszej kategorii znajdują się modele podmiotowe. Systemy te śledzą, gdzie i jak często te same podmioty są wymienione w tekście. Na przykład, jeśli system znajdzie słowo „transport” w kilku zdaniach, uzna to za znak, że te zdania są ze sobą logicznie powiązane.

W drugiej kategorii przetestowaliśmy model oparty na wykresie koherencji leksykalnej. Jest to sposób przedstawiania zdań jako węzłów w grafie i łączenia zdań zawierających pary podobnych słów. Na przykład ten typ modelu połączy zdanie zawierające „samochód” i zdanie zawierające „ciężarówka”, ponieważ oba zdania prawdopodobnie dotyczą pojazdów lub transportu.

W trzeciej kategorii znajdują się modele sieci neuronowych, czyli głębokiego uczenia. Przetestowaliśmy kilka z nich, w tym dwa zupełnie nowe modele zbudowane przez zespół Grammarly. Są to systemy oparte na sztucznej inteligencji, które uczą się reprezentacji każdego zdania, która oddaje jego znaczenie, i mogą nauczyć się ogólnego znaczenia dokumentu, łącząc te reprezentacje zdań. Mogą szukać wzorców, które nie są ograniczone do wystąpień jednostek lub podobnych par słów.

Zadanie porządkowania zdań

Wykorzystaliśmy teksty o wysokiej spójności z naszego nowego korpusu, aby stworzyć zadanie porządkowania zdań dla wszystkich trzech typów modeli. Odkryliśmy, że modele, które działały dobrze w innych zestawach danych dotyczących porządkowania zdań, działały również dobrze w naszym zestawie danych, z dokładnością sięgającą 89 procent. Modele oparte na jednostkach i wykresy koherencji leksykalnej wykazały przyzwoitą dokładność (ogólnie dokładność od 60 do 70 procent), ale to modele neuronowe przewyższały inne modele o co najmniej dziesięć punktów procentowych w trzech z czterech domen.

Prawdziwy test pisania

Tak naprawdę chcieliśmy wiedzieć, czy którykolwiek z tych modeli może działać z takim samym poziomem dokładności na prawdziwym, naturalnie napisanym tekście. Przekonwertowaliśmy etykiety adnotatorów na wartości liczbowe (low=1, medium=2, high=3) i uśredniliśmy liczby, aby uzyskać wynik spójności dla każdego fragmentu tekstu.

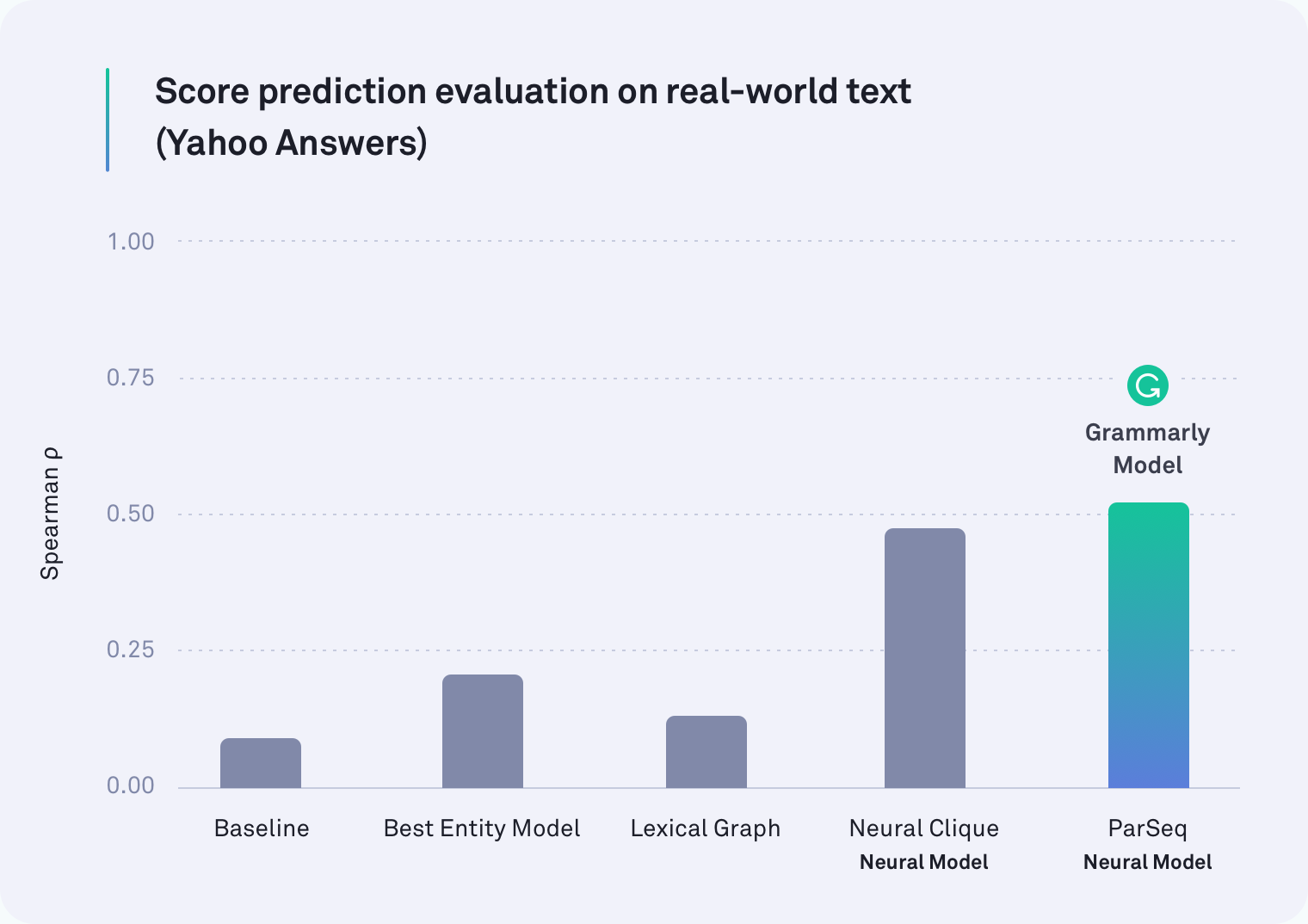

W każdej domenie co najmniej jeden z systemów opartych na sieciach neuronowych przewyższał wszystkie pozostałe. W rzeczywistości jeden z modeli Grammarly, który uwzględnia łamanie akapitów, był najlepszy w przypadku tekstu z Yahoo Answers, jak pokazano w poniższej tabeli. Model Neural Clique, który został opracowany przez naukowców ze Stanford, również był skuteczny.

Ale nasza pierwotna hipoteza była poprawna: wszystkie modele radziły sobie gorzej w zadaniu w świecie rzeczywistym niż w zadaniu kolejności zdań — niektóre były znacznie gorsze. Na przykład metoda wykresów leksykalnych była dokładna w 78 procentach dla firmowych wiadomości e-mail w scenariuszu ze sztuczną zmianą kolejności zdań, ale w tej bardziej realistycznej ocenie zdołała osiągnąć tylko 45 procent.

Co znaleźliśmy

Okazuje się, że poprzednie prace nad spójnością dyskursu testowały niewłaściwą rzecz. Zadanie kolejności zdań zdecydowanie nie jest dobrym przybliżeniem do pomiaru spójności dyskursu. Nasze wyniki są jasne: systemy, które dobrze radzą sobie w sztucznym scenariuszu, znacznie gorzej radzą sobie z tekstem w świecie rzeczywistym.

Należy zauważyć, że to odkrycie nie jest przeszkodą. Wręcz przeciwnie, w rzeczywistości. Częścią uprawy jakiejkolwiek dziedziny jest ocena tego, jak oceniasz — zatrzymuj się co jakiś czas, aby przyjrzeć się temu, co naprawdę mierzyłeś. Dzięki tej pracy badacze zajmujący się spójnością dyskursu mają teraz dwie ważne informacje. Jednym z nich jest przekonanie, że zadanie porządkowania zdań nie powinno już być sposobem, w jaki mierzymy dokładność. Drugi to publicznie dostępny, opatrzony adnotacjami korpus rzeczywistego tekstu i nowe wzorce (nasze modele neuronowe) do wykorzystania w przyszłych badaniach.

Oczekiwanie na coś

Jest jeszcze więcej pracy do wykonania i wiele ekscytujących zastosowań systemu, który może wiarygodnie oceniać spójność dyskursu w fragmencie tekstu. Pewnego dnia taki system może nie tylko powiedzieć, jak spójny jest twój ogólny przekaz, ale także wskazać konkretne fragmenty, które mogą być trudne do naśladowania. Mamy nadzieję, że pewnego dnia pomożemy ci uczynić te fragmenty łatwiejszymi do zrozumienia, aby to, co próbujesz powiedzieć, było jasne dla odbiorcy.

W końcu droga Grammarly do zostania wszechstronnym asystentem komunikacji nie polega tylko na upewnieniu się, że Twoje pisanie jest gramatycznie i stylistycznie poprawne — chodzi o to, aby upewnić się, że jesteś zrozumiany tak, jak zamierzasz.

—-

Joel Tetreault jest dyrektorem ds. badań w Grammarly. Alice Lai jest doktorantką na Uniwersytecie Illinois w Urbana-Champaign i była stażystką naukową w Grammarly. Badanie to zostanie zaprezentowane na dorocznej konferencji SIGDIAL 2018 w Melbourne, Australia, w dniach 12-14 lipca 2018 r. Towarzyszący mu artykuł badawczy zatytułowany „Discourse Coherence in the Wild: A Dataset, Evaluation and Methods” zostanie opublikowany w Proceedings of 19. doroczne spotkanie Specjalnej Grupy ds. Dyskursu i Dialogu. Zestaw danych opisany w tym poście na blogu nosi nazwę Grammarly Corpus of Discourse Coherence i można go bezpłatnie pobrać w celach badawczych tutaj.