Sob o capô na Grammarly: detectando escrita desorganizada com IA

Publicados: 2018-07-10Sempre que você escreve algo maior do que uma frase, você precisa tomar decisões sobre como organizar e apresentar seus pensamentos. Uma boa escrita é fácil de entender porque cada frase se baseia nas que vieram antes dela. Quando o tópico muda, escritores fortes usam frases de transição e quebras de parágrafo como sinalizadores para dizer aos leitores o que esperar a seguir.

Os linguistas chamam esse aspecto da escrita de coerência do discurso, e é o assunto de algumas novas pesquisas interessantes da equipe Grammarly Research que aparecerá na conferência SIGDIAL em Melbourne, Austrália, esta semana.

O que é coerência discursiva e por que se preocupar com isso?

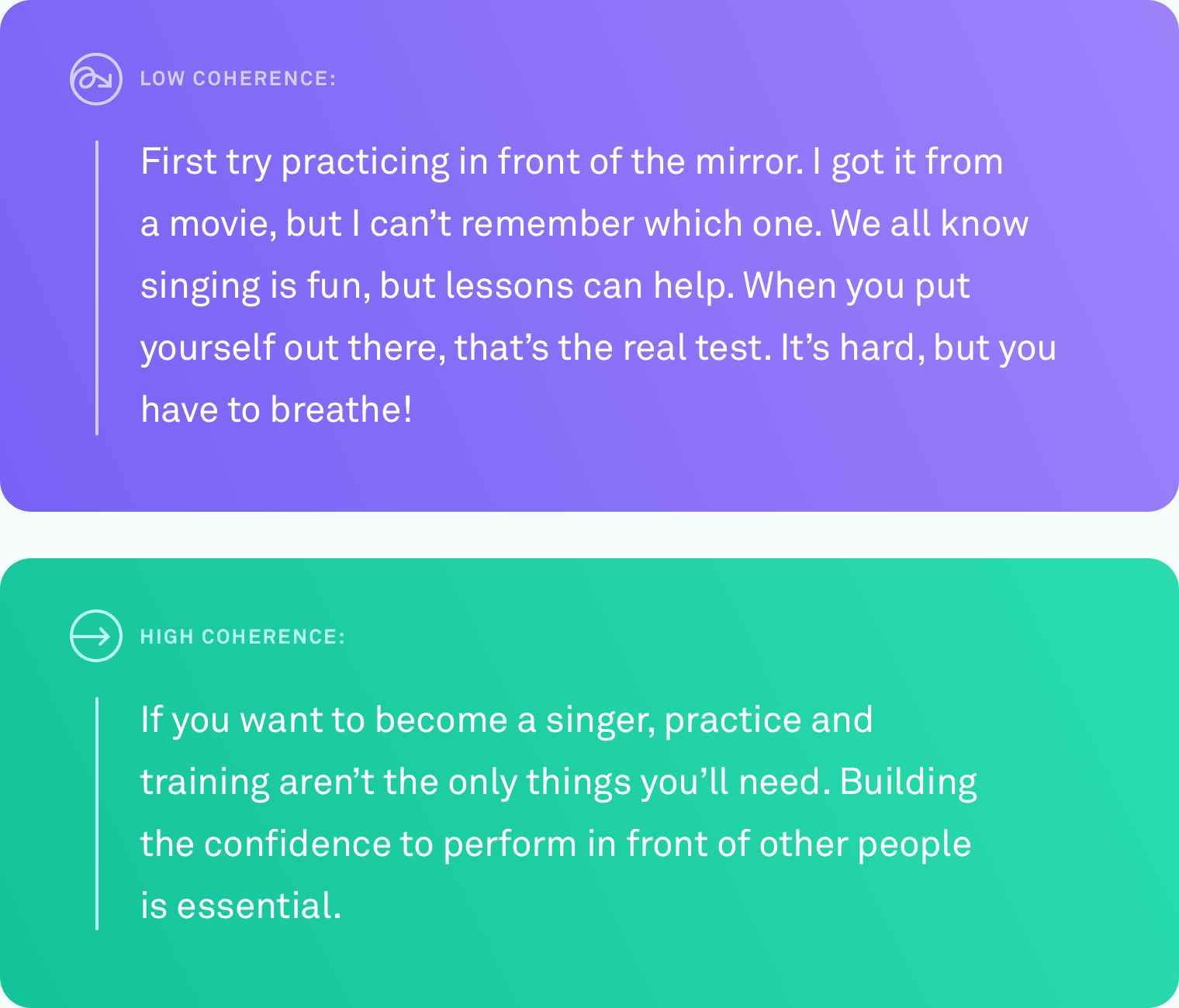

Quando dizemos que um texto tem um alto nível de coerência discursiva, queremos dizer que todas as frases estão interligadas logicamente. O escritor não se desvia do assunto. Diferentes pontos são conectados por transições. O texto é fácil de acompanhar do início ao fim.

Esse tipo de organização nem sempre vem naturalmente. Poucos de nós pensam em progressões perfeitamente lineares de ideias. Um sistema que pudesse lhe dizer automaticamente quando você escreveu algo que outras pessoas terão dificuldade em seguir – e, eventualmente, sugerir como consertar isso – seria extremamente útil para comunicar o que você quer dizer.

O que foi feito

Ensinar um computador a julgar com precisão o nível de coerência do texto é um desafio. Até o momento, o método mais comum de avaliar quão bem um computador avalia a coerência do discurso é baseado em uma tarefa de ordenação de sentenças. Com esse método, os pesquisadores pegam um texto existente e bem editado, como um artigo de notícias, e reordenam aleatoriamente todas as frases. A suposição é que a permutação aleatória pode ser vista como incoerente e a ordenação original pode ser vista como coerente. A tarefa é construir um algoritmo de computador que possa distinguir entre a versão incoerente e a original. Sob essas condições, alguns sistemas atingiram até 90% de precisão. Bastante impressionante.

Mas há uma grande falha potencial com este método. Talvez você já tenha percebido. A reordenação aleatória de frases pode produzir um texto de baixa coerência, mas não produz um texto que se pareça com algo que um humano escreveria naturalmente.

Na Grammarly, estamos focados em resolver problemas do mundo real, então sabíamos que qualquer trabalho que fizéssemos nessa área precisaria ser comparado com a escrita real, não com cenários artificiais. Surpreendentemente, tem havido muito pouco trabalho que testa métodos de avaliação de discurso em texto real escrito por pessoas em circunstâncias comuns. É hora de mudar isso.

Pesquisa do mundo real, escritores do mundo real

O primeiro problema que tivemos que resolver foi o mesmo que todos os outros pesquisadores que trabalham com coerência discursiva enfrentaram: a falta de dados do mundo real. Não havia nenhum corpus de texto comum, escrito naturalmente, em que pudéssemos testar nossos algoritmos.

Criamos um corpus coletando texto de várias fontes públicas: Yahoo Answers, Yelp Reviews e e-mails governamentais e corporativos disponíveis publicamente. Escolhemos essas fontes específicas porque representam os tipos de coisas que as pessoas escrevem em um dia típico – postagens em fóruns, resenhas e e-mails.

Para transformar todo esse texto em um corpus com o qual algoritmos de computador possam aprender, também precisávamos avaliar os níveis de coerência de cada texto. Esse processo é chamado de anotação. Não importa quão bom seja o seu algoritmo, uma anotação desleixada distorcerá drasticamente seus resultados. Em nosso artigo, fornecemos detalhes sobre as muitas abordagens de anotação que testamos, incluindo algumas que envolviam crowdsourcing. Por fim, decidimos que anotadores especialistas avaliassem o nível de coerência de cada trecho de texto em uma escala de três pontos (coerência baixa, média ou alta). Cada texto foi julgado por três anotadores.

Colocando algoritmos à prova

Uma vez que tínhamos o corpus, era hora de testar com que precisão vários sistemas de computador poderiam identificar o nível de coerência de um determinado trecho de texto. Testamos três tipos de sistemas:

Na primeira categoria estão os modelos baseados em entidade. Esses sistemas rastreiam onde e com que frequência as mesmas entidades são mencionadas em um texto. Por exemplo, se o sistema encontra a palavra “transporte” em várias frases, isso é um sinal de que essas frases estão logicamente relacionadas umas com as outras.

Na segunda categoria, testamos um modelo baseado em um grafo de coerência lexical. Esta é uma maneira de representar sentenças como nós em um gráfico e conectar sentenças que contêm pares de palavras semelhantes. Por exemplo, esse tipo de modelo conectaria uma frase contendo “carro” e uma frase contendo “caminhão” porque ambas as frases são provavelmente sobre veículos ou transporte.

Na terceira categoria estão os modelos de rede neural, ou aprendizado profundo. Testamos vários deles, incluindo dois novos modelos construídos pela equipe Grammarly. Esses são sistemas baseados em IA que aprendem uma representação de cada frase que captura seu significado e podem aprender o significado geral de um documento combinando essas representações de frases. Eles podem procurar padrões que não estejam restritos a ocorrências de entidades ou pares de palavras semelhantes.

A tarefa de ordenação de sentenças

Usamos os textos de alta coerência do nosso novo corpus para criar uma tarefa de ordenação de frases para todos os três tipos de modelos. Descobrimos que os modelos que tiveram bom desempenho em outros conjuntos de dados de ordenação de sentenças também tiveram bom desempenho em nosso conjunto de dados, com desempenhos de até 89% de precisão. Os modelos baseados em entidade e os gráficos de coerência lexical mostraram precisão decente (geralmente 60 a 70 por cento de precisão), mas foram os modelos neurais que superaram os outros modelos em pelo menos dez pontos percentuais em três dos quatro domínios.

O verdadeiro teste de redação

O que realmente queríamos saber era se algum desses modelos poderia ter o mesmo nível de precisão em texto real, escrito naturalmente. Convertemos os rótulos dos anotadores em valores numéricos (baixo = 1, médio = 2, alto = 3) e calculamos a média dos números juntos para obter uma pontuação de coerência para cada parte do texto.

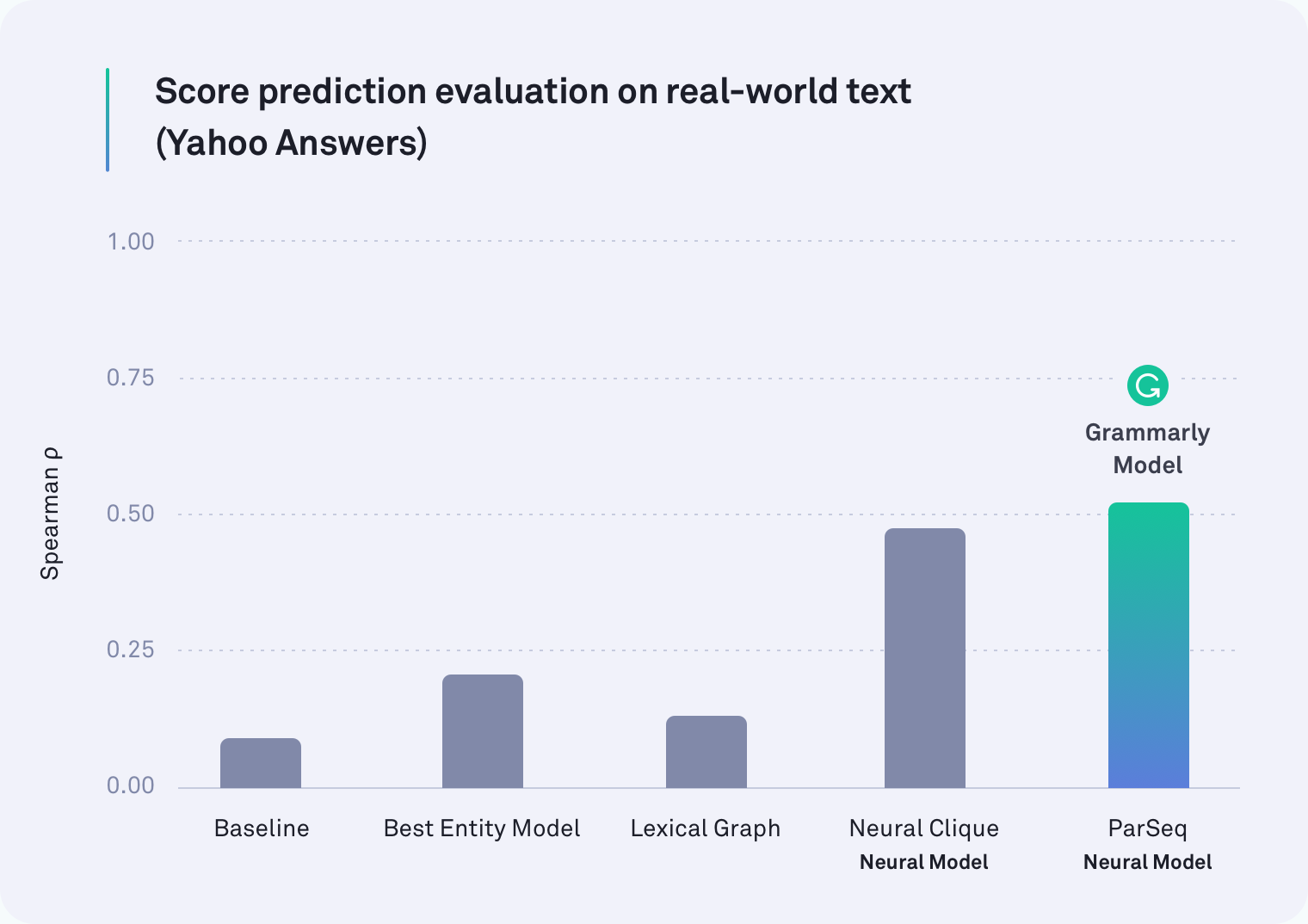

Em cada domínio, pelo menos um dos sistemas baseados em rede neural superou todos os outros. Na verdade, um dos modelos do Grammarly que leva em consideração as quebras de parágrafo foi o de melhor desempenho em texto do Yahoo Answers, conforme mostrado na tabela abaixo. O modelo Neural Clique, que foi desenvolvido por pesquisadores de Stanford, também teve um desempenho forte.

Mas nossa hipótese original estava correta: todos os modelos tiveram um desempenho pior na tarefa do mundo real do que na tarefa de ordem de sentença – alguns foram muito piores. Por exemplo, o método gráfico léxico foi 78% preciso para e-mails corporativos no cenário de reordenação artificial de frases, mas só conseguiu atingir 45% nessa avaliação mais realista.

O que encontramos

Acontece que trabalhos anteriores sobre coerência discursiva estavam testando a coisa errada. A tarefa de ordem de sentença definitivamente não é uma boa proxy para medir a coerência do discurso. Nossos resultados são claros: os sistemas que funcionam bem no cenário artificial se saem muito pior no texto do mundo real.

É importante notar que esta constatação não é um retrocesso. Longe disso, na verdade. Parte do crescimento de qualquer campo é avaliar como você está avaliando – parando de vez em quando para dar uma olhada no que você realmente está medindo. Por causa desse trabalho, os pesquisadores que trabalham com coerência discursiva agora têm duas informações importantes. Uma é a percepção de que a tarefa de ordenação de sentenças não deve mais ser a forma como medimos a precisão. O segundo é um corpus anotado publicamente disponível de texto do mundo real e novos benchmarks (nossos modelos neurais) para uso em pesquisas futuras.

Esperando ansiosamente

Há mais trabalho a ser feito e muitas aplicações interessantes para um sistema que pode julgar com segurança a coerência do discurso em um pedaço de texto. Um dia, um sistema como esse poderia não apenas dizer o quão coerente é sua mensagem geral, mas também apontar as passagens específicas que podem ser difíceis de seguir. Algum dia esperamos ajudá-lo a tornar essas passagens mais fáceis de entender para que o que você está tentando dizer fique claro para o seu destinatário.

Afinal, o caminho da Grammarly para se tornar um assistente de comunicação abrangente não é apenas garantir que sua escrita seja gramatical e estilisticamente precisa - é garantir que você seja entendido exatamente como pretendido.

—-

Joel Tetreault é Diretor de Pesquisa da Grammarly. Alice Lai é estudante de doutorado na Universidade de Illinois em Urbana-Champaign e foi estagiária de pesquisa na Grammarly. Esta pesquisa será apresentada na conferência anual SIGDIAL 2018 em Melbourne, Austrália, de 12 a 14 de julho de 2018. O documento de pesquisa que o acompanha, intitulado "Coerência do discurso na natureza: um conjunto de dados, avaliação e métodos" será publicado no Proceedings of a 19ª Reunião Anual do Grupo de Interesse Especial sobre Discurso e Diálogo. O conjunto de dados descrito nesta postagem do blog é chamado de Grammarly Corpus of Discourse Coherence e pode ser baixado gratuitamente para fins de pesquisa aqui.