Ce este o rețea neuronală?

Publicat: 2024-06-26Ce este o rețea neuronală?

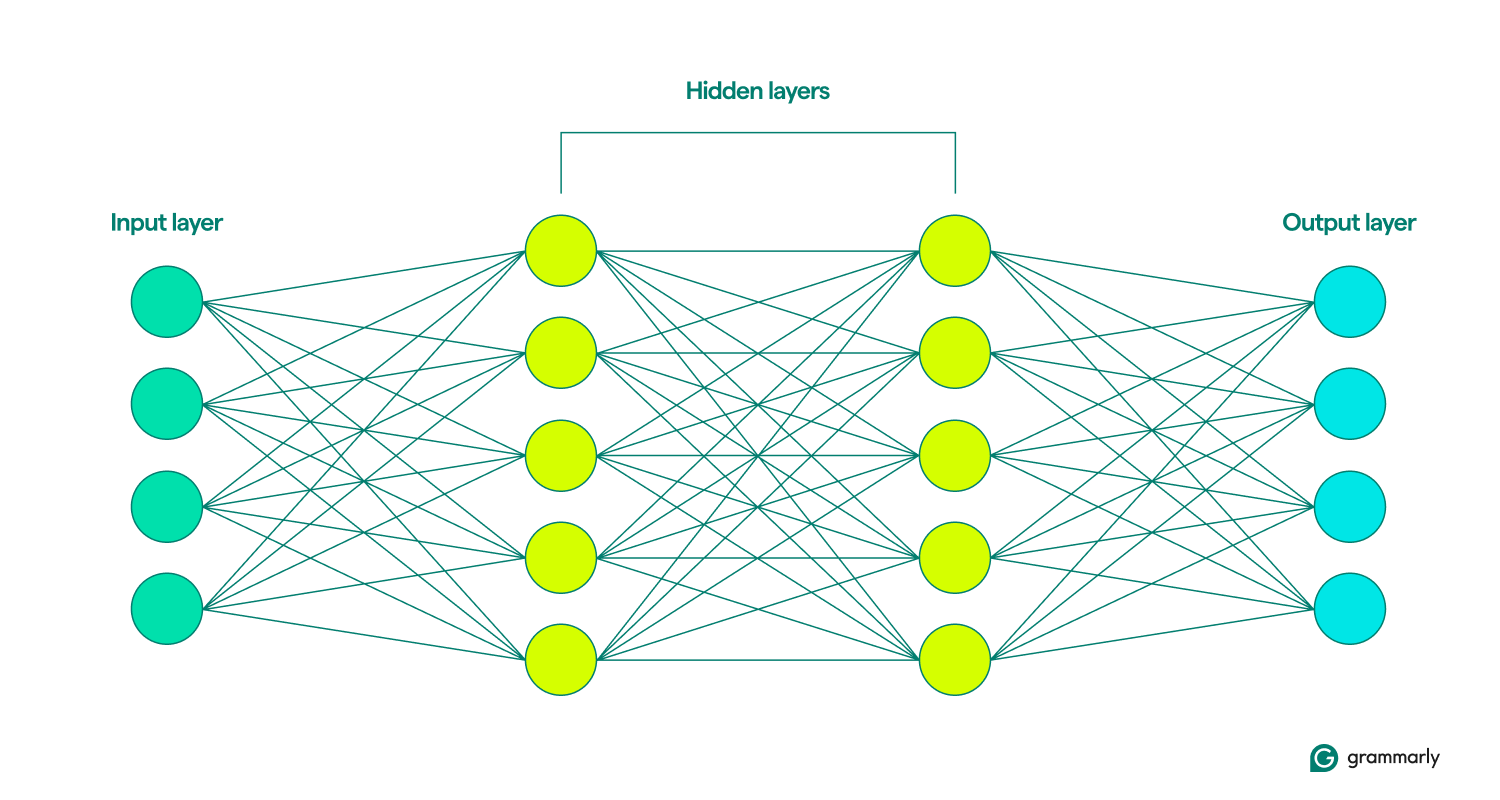

O rețea neuronală este un tip de model de învățare profundă în domeniul mai larg al învățării automate (ML) care simulează creierul uman. Procesează datele prin noduri interconectate sau neuroni aranjați în straturi - intrare, ascuns și ieșire. Fiecare nod efectuează calcule simple, contribuind la capacitatea modelului de a recunoaște tipare și de a face predicții.

Rețelele neuronale de învățare profundă sunt deosebit de eficiente în gestionarea sarcinilor complexe, cum ar fi recunoașterea imaginilor și a vorbirii, formând o componentă crucială a multor aplicații AI. Progresele recente în arhitecturile rețelelor neuronale și tehnicile de antrenament au îmbunătățit substanțial capacitățile sistemelor AI.

Cum sunt structurate rețelele neuronale

După cum indică numele său, un model de rețea neuronală se inspiră din neuroni, blocurile de construcție ale creierului. Oamenii adulți au aproximativ 85 de miliarde de neuroni, fiecare conectat la aproximativ 1.000 de alți. O celulă a creierului vorbește cu alta trimițând substanțe chimice numite neurotransmițători. Dacă celula primitoare primește suficiente din aceste substanțe chimice, se excită și își trimite propriile substanțe chimice către o altă celulă.

Unitatea fundamentală a ceea ce se numește uneori o rețea neuronală artificială (ANN) este unnod, care, în loc să fie o celulă, este o funcție matematică. La fel ca neuronii, ei comunică cu alte noduri dacă primesc suficientă intrare.

Cam aici se termină asemănările. Rețelele neuronale sunt structurate mult mai simplu decât creierul, cu straturi bine definite: intrare, ascuns și ieșire. O colecție a acestor straturi se numeștemodel.Ei învață sause antreneazăîncercând în mod repetat să genereze artificial rezultate care seamănă cel mai mult cu rezultatele dorite. (Mai multe despre asta într-un minut.)

Straturile de intrare și de ieșire sunt destul de explicite. Cea mai mare parte a ceea ce fac rețelele neuronale are loc în straturile ascunse. Când un nod este activat prin intrarea dintr-un strat anterior, acesta își face calculele și decide dacă va trece de-a lungul ieșirii la nodurile din stratul următor. Aceste straturi sunt numite astfel deoarece operațiunile lor sunt invizibile pentru utilizatorul final, deși există tehnici pentru ingineri pentru a vedea ce se întâmplă în așa-numitele straturi ascunse.

Când rețelele neuronale includ mai multe straturi ascunse, ele se numesc rețele de învățare profundă. Rețelele neuronale profunde moderne au de obicei multe straturi, inclusiv sub-straturi specializate care îndeplinesc funcții distincte. De exemplu, unele sub-straturi sporesc capacitatea rețelei de a lua în considerare informațiile contextuale dincolo de intrarea imediată care este analizată.

Cum funcționează rețelele neuronale

Gândiți-vă la cum învață bebelușii. Ei încearcă ceva, eșuează și încearcă din nou într-un mod diferit. Bucla continuă din nou și din nou până când au perfecționat comportamentul. Mai mult sau mai puțin așa învață și rețelele neuronale.

La începutul pregătirii lor, rețelele neuronale fac ghiciri aleatorii. Un nod din stratul de intrare decide aleatoriu care dintre nodurile din primul strat ascuns să activeze, iar apoi acele noduri activează aleatoriu noduri din stratul următor și așa mai departe, până când acest proces aleatoriu ajunge la stratul de ieșire. (Modelele de limbaj mari, cum ar fi GPT-4, au aproximativ 100 de straturi, cu zeci sau sute de mii de noduri în fiecare strat.)

Având în vedere toate aleatoriile, modelul își compară rezultatul - ceea ce este probabil teribil - și își dă seama cât de greșit a fost. Apoi ajustează conexiunea fiecărui nod la alte noduri, modificând cât de mult sau mai puțin predispuse ar trebui să fie activate în funcție de o anumită intrare. Face acest lucru în mod repetat până când rezultatele sale sunt cât mai aproape de răspunsurile dorite.

Deci, de unde știu rețelele neuronale ce ar trebui să facă? Învățarea automată (ML) poate fi împărțită în diferite abordări, inclusiv învățarea supravegheată și nesupravegheată. În învățarea supravegheată, modelul este antrenat pe date care includ etichete sau răspunsuri explicite, cum ar fi imagini asociate cu text descriptiv. Învățarea nesupravegheată, totuși, implică furnizarea modelului cu date neetichetate, permițându-i să identifice tipare și relații în mod independent.

Un supliment comun al acestei instruiri este învățarea prin întărire, în care modelul se îmbunătățește ca răspuns la feedback. Frecvent, acest lucru este oferit de evaluatori umani (dacă ați dat vreodată clic cu degetul în sus sau în jos la sugestia unui computer, ați contribuit la învățare de întărire). Totuși, există modalități prin care modelele pot învăța independent și iterativ.

Este corect și instructiv să ne gândim la ieșirea unei rețele neuronale ca la o predicție. Indiferent dacă evaluează solvabilitatea sau generează o melodie, modelele AI funcționează ghicind ce este cel mai probabil corect. AI generativ, cum ar fi ChatGPT, duce predicția cu un pas mai departe. Funcționează secvenţial, făcând presupuneri despre ce ar trebui să vină după rezultatul pe care tocmai l-a făcut. (Vom înțelege de ce acest lucru poate fi problematic mai târziu.)

Cum rețelele neuronale generează răspunsuri

Odată ce o rețea este instruită, cum procesează informațiile pe care le vede pentru a prezice răspunsul corect? Când introduceți o solicitare precum „Spune-mi o poveste despre zâne” în interfața ChatGPT, cum decide ChatGPT cum să răspundă?

Primul pas este ca stratul de intrare al rețelei neuronale să împartă promptul în bucăți mici de informații, cunoscute sub numele detoken-uri. Pentru o rețea de recunoaștere a imaginilor, jetoanele pot fi pixeli. Pentru o rețea care utilizează procesarea limbajului natural (NLP), cum ar fi ChatGPT, un simbol este de obicei un cuvânt, o parte a unui cuvânt sau o frază foarte scurtă.

Odată ce rețeaua a înregistrat jetoanele în intrare, informațiile respective sunt transmise prin straturile ascunse antrenate anterior. Nodurile pe care le trece de la un strat la altul analizează secțiuni din ce în ce mai mari ale intrării. În acest fel, o rețea NLP poate interpreta în cele din urmă o propoziție sau un paragraf întreg, nu doar un cuvânt sau o literă.

Acum, rețeaua poate începe să își creeze răspunsul, ceea ce face ca o serie de predicții cuvânt cu cuvânt despre ceea ce va urma, pe baza a tot ceea ce a fost instruit.

Luați în considerare solicitarea „Spune-mi o poveste despre zâne”. Pentru a genera un răspuns, rețeaua neuronală analizează promptul pentru a prezice primul cuvânt cel mai probabil. De exemplu, ar putea determina că există o șansă de 80% ca „The” să fie cea mai bună alegere, o șansă de 10% pentru „A” și o șansă de 10% pentru „O dată”. Apoi selectează aleatoriu un număr: Dacă numărul este între 1 și 8, alege „The”; dacă este 9, alege „A”; iar dacă este 10, alege „O dată”. Să presupunem că numărul aleatoriu este 4, care corespunde cu „The”. Rețeaua actualizează apoi solicitarea „Spune-mi o poveste despre zâne. The” și repetă procesul pentru a prezice următorul cuvânt după „The.” Acest ciclu continuă, cu fiecare predicție de cuvânt nou bazată pe promptul actualizat, până când este generată o poveste completă.

Diferite rețele vor face această predicție în mod diferit. De exemplu, un model de recunoaștere a imaginii poate încerca să prezică ce etichetă să dea unei imagini a unui câine și să determine că există o probabilitate de 70% ca eticheta corectă să fie „laborator de ciocolată”, 20% pentru „spaniel englezesc” și 10% pentru „golden retriever”. În cazul clasificării, în general, rețeaua va merge mai degrabă cu alegerea cea mai probabilă decât cu o presupunere probabilistică.

Tipuri de rețele neuronale

Iată o prezentare generală a diferitelor tipuri de rețele neuronale și a modului în care funcționează.

- Rețele neuronale feedforward (FNN): În aceste modele, informațiile circulă într-o singură direcție: de la nivelul de intrare, prin straturile ascunse și, în final, la nivelul de ieșire.Acest tip de model este cel mai bun pentru sarcini de predicție mai simple, cum ar fi detectarea fraudelor cu cardul de credit.

- Rețele neuronale recurente (RNN): Spre deosebire de FNN, RNN-urile iau în considerare intrările anterioare atunci când generează o predicție.Acest lucru le face potrivite pentru sarcinile de procesare a limbajului, deoarece sfârșitul unei propoziții generate ca răspuns la un prompt depinde de modul în care a început propoziția.

- Rețele de memorie pe termen lung (LSTM): LSTM-urile uită selectiv informațiile, ceea ce le permite să lucreze mai eficient.Acest lucru este crucial pentru procesarea unor cantități mari de text; de exemplu, upgrade-ul Google Translate din 2016 la traducerea automată neuronală s-a bazat pe LSTM.

- Rețele neuronale convoluționale (CNN): CNN-urile funcționează cel mai bine atunci când procesează imagini.Ei folosescstraturi convoluționalepentru a scana întreaga imagine și pentru a căuta caracteristici precum linii sau forme. Acest lucru permite CNN-urilor să ia în considerare locația spațială, cum ar fi stabilirea dacă un obiect este situat în jumătatea superioară sau inferioară a imaginii și, de asemenea, să identifice o formă sau un tip de obiect, indiferent de locația sa.

- Rețele adverse generative (GAN): GAN-urile sunt adesea folosite pentru a genera noi imagini bazate pe o descriere sau pe o imagine existentă.Ele sunt structurate ca o competiție între două rețele neuronale: o rețeageneratoare, care încearcă să păcălească o rețeadiscriminatoare, făcându-le să creadă că o intrare falsă este reală.

- Transformatoare și rețele de atenție: transformatoarele sunt responsabile pentru explozia actuală a capabilităților AI.Aceste modele încorporează un reflector atent care le permite să își filtreze intrările pentru a se concentra asupra celor mai importante elemente și asupra modului în care aceste elemente se leagă între ele, chiar și în paginile de text. Transformers se pot antrena și pe cantități enorme de date, astfel încât modele precum ChatGPT și Gemini sunt numitemodele de limbaj mari (LLM).

Aplicații ale rețelelor neuronale

Sunt mult prea multe de enumerat, așa că iată o selecție de moduri în care rețelele neuronale sunt folosite astăzi, cu accent pe limbajul natural.

Asistență la scriere: Transformers au transformat, bine, modul în care computerele pot ajuta oamenii să scrie mai bine.Instrumentele de scriere AI, cum ar fi Grammarly, oferă rescrieri la nivel de propoziție și paragraf pentru a îmbunătăți tonul și claritatea. Acest tip de model a îmbunătățit, de asemenea, viteza și acuratețea sugestiilor gramaticale de bază. Aflați mai multe despre cum folosește Grammarly AI.

Generarea de conținut: dacă ați folosit ChatGPT sau DALL-E, ați experimentat personal AI generativ.Transformers au revoluționat capacitatea computerelor de a crea medii care rezonează cu oamenii, de la povești de culcare până la redări arhitecturale hiperrealiste.

Recunoașterea vorbirii: computerele devin mai bune în fiecare zi în ceea ce privește recunoașterea vorbirii umane.Cu tehnologiile mai noi care le permit să ia în considerare mai mult context, modelele au devenit din ce în ce mai precise în recunoașterea a ceea ce intenționează să spună vorbitorul, chiar dacă doar sunetele ar putea avea mai multe interpretări.

Diagnostic și cercetare medicală: rețelele neuronale excelează la detectarea și clasificarea modelelor, care sunt din ce în ce mai folosite pentru a ajuta cercetătorii și furnizorii de servicii medicale să înțeleagă și să abordeze boala.De exemplu, avem AI de mulțumit parțial pentru dezvoltarea rapidă a vaccinurilor COVID-19.

Provocări și limitări ale rețelelor neuronale

Iată o scurtă privire la unele, dar nu la toate, problemele ridicate de rețelele neuronale.

Prejudecăți: O rețea neuronală poate învăța doar din ceea ce i s-a spus.Dacă este expus la conținut sexist sau rasist, rezultatul său va fi probabil sexist sau rasist. Acest lucru se poate întâmpla în traducerea dintr-o limbă fără gen într-una cu gen, unde stereotipurile persistă fără identificarea explicită de gen.

Supraadaptare: un model antrenat necorespunzător poate citi prea mult în datele care i-au fost date și poate avea probleme cu intrări noi.De exemplu, software-ul de recunoaștere facială antrenat mai ales pe oameni de o anumită etnie ar putea avea rezultate slabe cu fețele din alte rase. Sau un filtru de spam ar putea pierde o nouă varietate de mesaje nedorite, deoarece este prea concentrat pe modelele pe care le-a mai văzut.

Halucinații: O mare parte din IA generativă de astăzi folosește probabilitatea într-o oarecare măsură pentru a alege ce să producă, în loc să selecteze întotdeauna alegerea de top.Această abordare îl ajută să fie mai creativ și să producă text care sună mai natural, dar îl poate determina și să facă afirmații care sunt pur și simplu false. (De asemenea, acesta este motivul pentru care LLM greșesc uneori matematica de bază.) Din păcate, aceste halucinații sunt greu de detectat, cu excepția cazului în care știți mai bine sau verificați cu alte surse.

Interpretabilitate: este adesea imposibil să știi exact cum o rețea neuronală face predicții.Deși acest lucru poate fi frustrant din perspectiva cuiva care încearcă să îmbunătățească modelul, poate fi, de asemenea, consecință, deoarece se bazează din ce în ce mai mult pe inteligența artificială pentru a lua decizii care influențează foarte mult viața oamenilor. Unele modele folosite astăzi nu se bazează pe rețele neuronale tocmai pentru că creatorii lor doresc să poată inspecta și înțelege fiecare etapă a procesului.

Proprietate intelectuală: mulți cred că LLM-urile încalcă drepturile de autor prin încorporarea scrisului și a altor opere de artă fără permisiune.Deși tind să nu reproducă în mod direct operele protejate prin drepturi de autor, se știe că aceste modele creează imagini sau fraze care sunt probabil derivate de la artiști anumi sau chiar creează lucrări în stilul distinctiv al unui artist atunci când li se solicită.

Consumul de energie: Toată această pregătire și funcționare a modelelor de transformatoare utilizează o energie extraordinară.De fapt, în câțiva ani, AI ar putea consuma la fel de multă energie ca Suedia sau Argentina. Acest lucru evidențiază importanța tot mai mare a luării în considerare a surselor de energie și a eficienței în dezvoltarea IA.

Viitorul rețelelor neuronale

Prezicerea viitorului AI este notoriu dificilă. În 1970, unul dintre cei mai buni cercetători AI a prezis că „în trei până la opt ani, vom avea o mașină cu inteligența generală a unei ființe umane obișnuite”. (Nu suntem încă foarte aproape de inteligența generală artificială (AGI). Cel puțin majoritatea oamenilor nu cred asta.)

Cu toate acestea, putem indica câteva tendințe la care să fim atenți. Modelele mai eficiente ar reduce consumul de energie și ar rula rețele neuronale mai puternice direct pe dispozitive precum smartphone-urile. Noile tehnici de antrenament ar putea permite predicții mai utile cu mai puține date de antrenament. O descoperire în interpretabilitate ar putea crește încrederea și ar deschide noi căi pentru îmbunătățirea rețelei neuronale. În cele din urmă, combinarea calculului cuantic și a rețelelor neuronale ar putea duce la inovații pe care abia începem să ni le imaginăm.

Concluzie

Rețelele neuronale, inspirate de structura și funcția creierului uman, sunt fundamentale pentru inteligența artificială modernă. Ei excelează în sarcinile de recunoaștere a modelelor și predicție, care stau la baza multor aplicații AI de astăzi, de la recunoașterea imaginilor și a vorbirii până la procesarea limbajului natural. Odată cu progresele în arhitectură și tehnici de antrenament, rețelele neuronale continuă să conducă la îmbunătățiri semnificative ale capabilităților AI.

În ciuda potențialului lor, rețelele neuronale se confruntă cu provocări, cum ar fi părtinirea, supraadaptarea și consumul ridicat de energie. Abordarea acestor probleme este crucială, deoarece AI continuă să evolueze. Privind în viitor, inovațiile în eficiența modelului, interpretabilitatea și integrarea cu calculul cuantic promit să extindă și mai mult posibilitățile rețelelor neuronale, ceea ce poate duce la aplicații și mai transformatoare.