Grammarly 的幕后花絮:用 AI 改变写作风格

已发表: 2018-05-31当您需要给正在写信的人留下好印象时,您需要考虑的不仅仅是您所说的内容。 你怎么说它通常同样重要。 选择正确的正式程度可能是一项特别的挑战——它高度依赖于上下文,而且您经常不得不猜测收件人将如何解释您的语气。

想象一下,你正在写一封求职信。 如果你有一个工具可以检测你的写作何时过于随意(或者,有时甚至更糟,过于正式),那将有多大的改变? 突然间,你关于如何说出你想说的话的决定变得不那么模糊了。 您不仅仅依赖于猜测收件人将如何看待您的信息——您拥有的算法可以利用您个人没有的大量数据。 更进一步,如果这个工具不仅可以告诉您什么时候出现问题,而且实际上可以为您提供收件人更喜欢的替代措辞,该怎么办?

让计算机自动将一篇文章从一种风格转换为另一种风格的过程称为风格转换,这是我与同事 Sudha Rao 即将发表的一篇论文的主题。 在 Grammarly,这是我们特别感兴趣的一个领域,因为我们知道以正确的方式进行交流是多么重要。

如果您想知道 Grammarly 的研究工程师如何构建为您提供写作建议的系统,请继续阅读。

形式的非正式背景

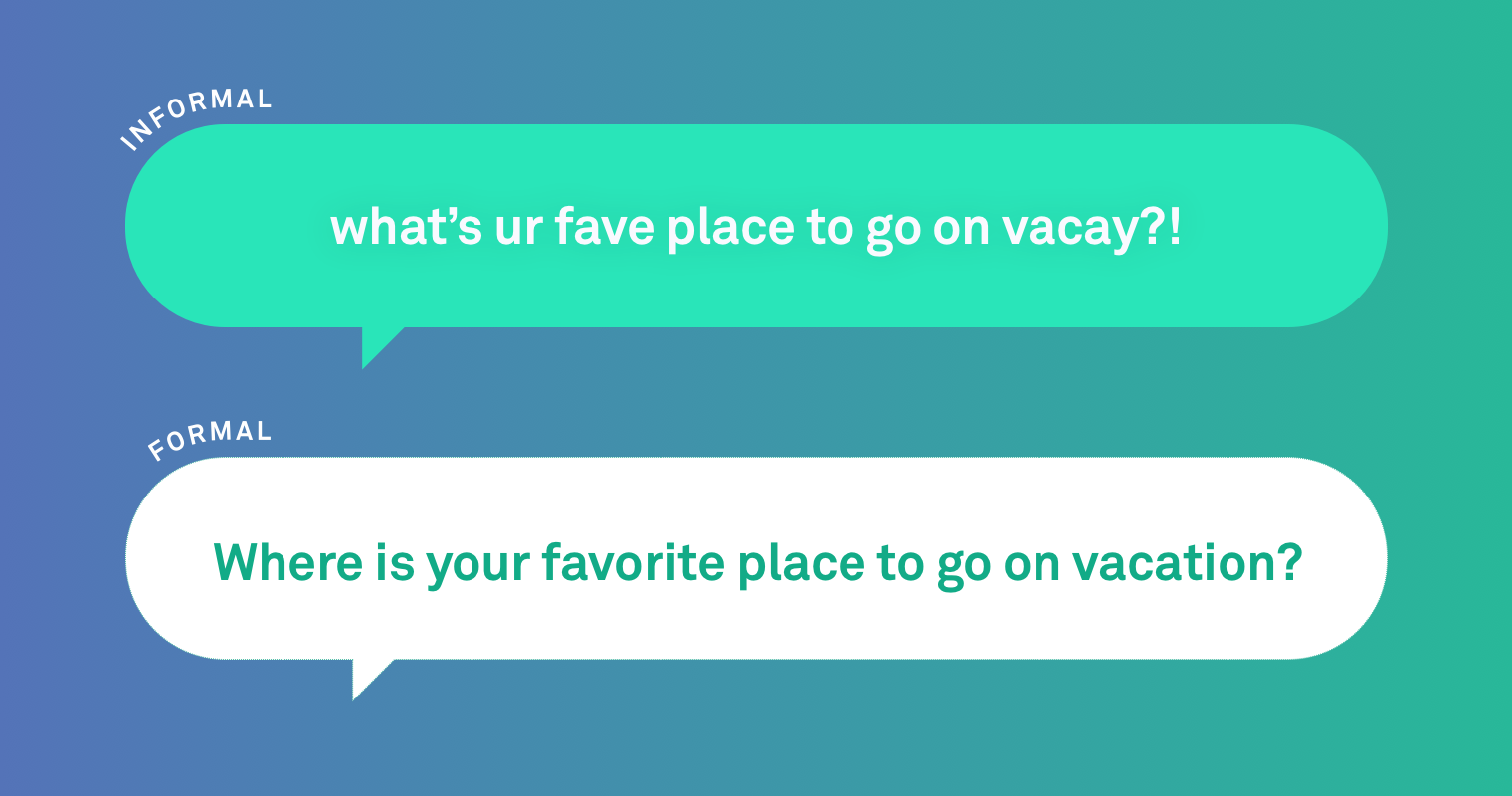

在深入了解我们的算法细节之前,让我们看一个非正式与正式语言的例子。

非正式:必须看到故事的两面

正式:你必须看到故事的两面。

这些句子之间有几个明显的区别。 俚语(“Gotta”)的使用和第一句末尾没有标点符号表示非正式。 这种句子有时间和地点——例如朋友之间的短信交流。

当我们研究人类如何以更正式的风格重写非正式句子时,我们发现他们所做的最频繁的更改涉及大小写、标点符号和俗语。 我们还注意到,人类有时必须对句子进行更大幅度的重写以改善形式:

非正式:你什么时候来开会?

正式:请让我知道您何时参加会议。

但是我们如何教计算机进行上述编辑呢? 有几种方法可以解决这个问题。

我们使用的那个承认教计算机在写作风格之间进行翻译类似于教它翻译语言。 这种方法称为机器翻译,计算机自动将一种语言(如法语)翻译成另一种语言(德语)。 因此,在解决风格迁移问题时,从翻译模型开始是有意义的——或者在我们的例子中,是多个模型。

什么是翻译模型?

人工智能最近的一项突破是使用深度学习或神经网络技术来构建机器翻译模型。

神经机器翻译 (NMT) 模型可以学习句子潜在含义的表示。 这有助于模型学习复杂的句型,从而使翻译流畅,其含义忠实于原句。

较旧的机器翻译方法,例如基于规则或基于短语的模型 (PBMT),将句子分解成更小的单元,例如单词或短语,并独立翻译它们。 这可能会导致翻译出现语法错误或无意义的结果。 然而,这些模型更容易调整并且往往更保守——这可能是一个优势。 例如,我们可以轻松地合并将俚语转换为标准词的规则。

我们研究了几种不同的机器翻译方法,看看哪种方法最适合风格转换。

建立模型

NMT 和 PBMT 充满挑战,其中最重要的是找到一个好的数据集来训练你的模型。 在这种情况下,我们估计我们需要一个包含数十万个非正式和正式句子对的数据集。 理想情况下,你会用数百万个句子对来训练你的模型,但由于风格迁移是自然语言处理领域的一个相当新的领域,我们确实没有可以使用的现有数据集。 所以,我们创造了一个。

我们从收集非正式句子开始。 我们的句子来源于在 Yahoo! 上公开发布的问题和回复。 答案。 我们自动从该集合中选择了超过 10 万个非正式句子,并让一个团队使用正式语言重写每个句子,再次使用预定义的标准。 (查看我们的论文以了解有关此过程的详细信息。)

一旦你有了数据集,你就可以开始训练你的模型了。 训练模型意味着给它很多“源”句子——在我们的例子中是非正式句子——以及很多“目标”句子——对我们来说,这些是正式的重写。 然后,模型的算法会寻找模式来确定如何从源到目标。 它拥有的数据越多,它的学习效果就越好。

在我们的例子中,该模型有十万个非正式的源句和它们的正式重写来学习。 我们还尝试了不同的方法来创建人工形式数据以增加我们的训练数据集的大小,因为 NMT 和 PBMT 模型通常需要更多的数据才能表现良好。

但是您还需要一种方法来评估您的模型完成任务的情况。 句子的意思有变化吗? 新句子语法正确吗? 它实际上更正式吗? 那里有分类器——可以自动评估句子的语气和写作风格的程序——我们测试了一些在学术界最常用的分类器。 但是,它们都不是很准确。 因此,我们最终让人类比较了我们测试的各种模型的输出,并根据形式、准确性和流畅性对它们进行排名。

我们向我们的团队展示了原始的非正式句子、几个不同模型的输出以及人工重写。 我们没有告诉他们是谁——或者是什么——产生了每个句子。 然后,他们对重写进行排名,允许平局。 理想情况下,最好的模型将与人工重写相关,甚至比人工重写更好。 该团队总共对 500 个非正式句子的改写进行了评分。

我们发现了什么

总而言之,我们测试了数十种模型,但我们将专注于顶级模型:基于规则的、基于短语的 (PBMT)、基于神经网络的 (NMT),以及结合各种方法的一对。

人工重写的总体得分最高,但 PBMT 和 NMT 模型也不甘落后。 事实上,在某些情况下,人类更喜欢模型输出而不是人类输出。 这两个模型进行了更广泛的重写,但它们往往会改变原句的含义。

另一方面,基于规则的模型进行了较小的更改。 这意味着他们更善于保留意义,但他们产生的句子不那么正式。 所有模型处理较短的句子都比处理较长的句子更容易。

以下是带有人工和模型重写的非正式句子的示例。 在这种特殊情况下,它是最后一个模型(带有 PBMT 翻译的 NMT)在形式、含义和听起来自然的措辞之间取得了最佳平衡。

非正式原文:我在学校也很少见到他,通常我在我兄弟的篮球比赛中见到他。

人工重写:我在学校几乎见不到他。 我经常看到他和我的兄弟们一起打篮球。

基于规则的模式:我在学校也很少见到他,通常我在我兄弟的篮球比赛中看到他。

PBMT 模型:我在学校也几乎见不到他,但我兄弟的篮球比赛。

NMT 模型:我在学校很少见到他,要么在我哥哥的篮球赛上见到他。

NMT(根据额外的 PBMT 生成的数据进行训练):我很少在学校看到他,通常我会在我兄弟的篮球比赛中看到他。

风格迁移是自然语言处理的一个令人兴奋的新领域,具有广泛应用的潜力。 我一开始就假设的那个工具——它可以帮助你弄清楚如何说出你需要说的话? 还有很多工作要做,但这个工具是可能的,它对于求职者、语言学习者以及任何需要通过写作给某人留下好印象的人来说都是无价的。 我们希望通过公开我们的数据,我们和该领域的其他人将有办法相互进行基准测试并推动这一研究领域的发展。

至于 Grammarly,这项工作是朝着我们的愿景迈出的又一步,即创建一个全面的沟通助手,帮助您按照预期理解您的信息。

Joel Tetreault 是 Grammarly 的研究总监。 Sudha Rao 是马里兰大学的博士生,曾在 Grammarly 担任研究实习生。 Joel 和 Sudha 将在 2018 年 6 月 1 日至 6 日在新奥尔良举行的计算语言学协会北美分会第 16 届年会上介绍这项研究。随附的研究论文题为“尊敬的先生或女士” ,我可以介绍 GYAFC 数据集:形式风格迁移的语料库、基准和指标”,将发表在 NAACL 论文集上。