什么是神经网络?

已发表: 2024-06-26什么是神经网络?

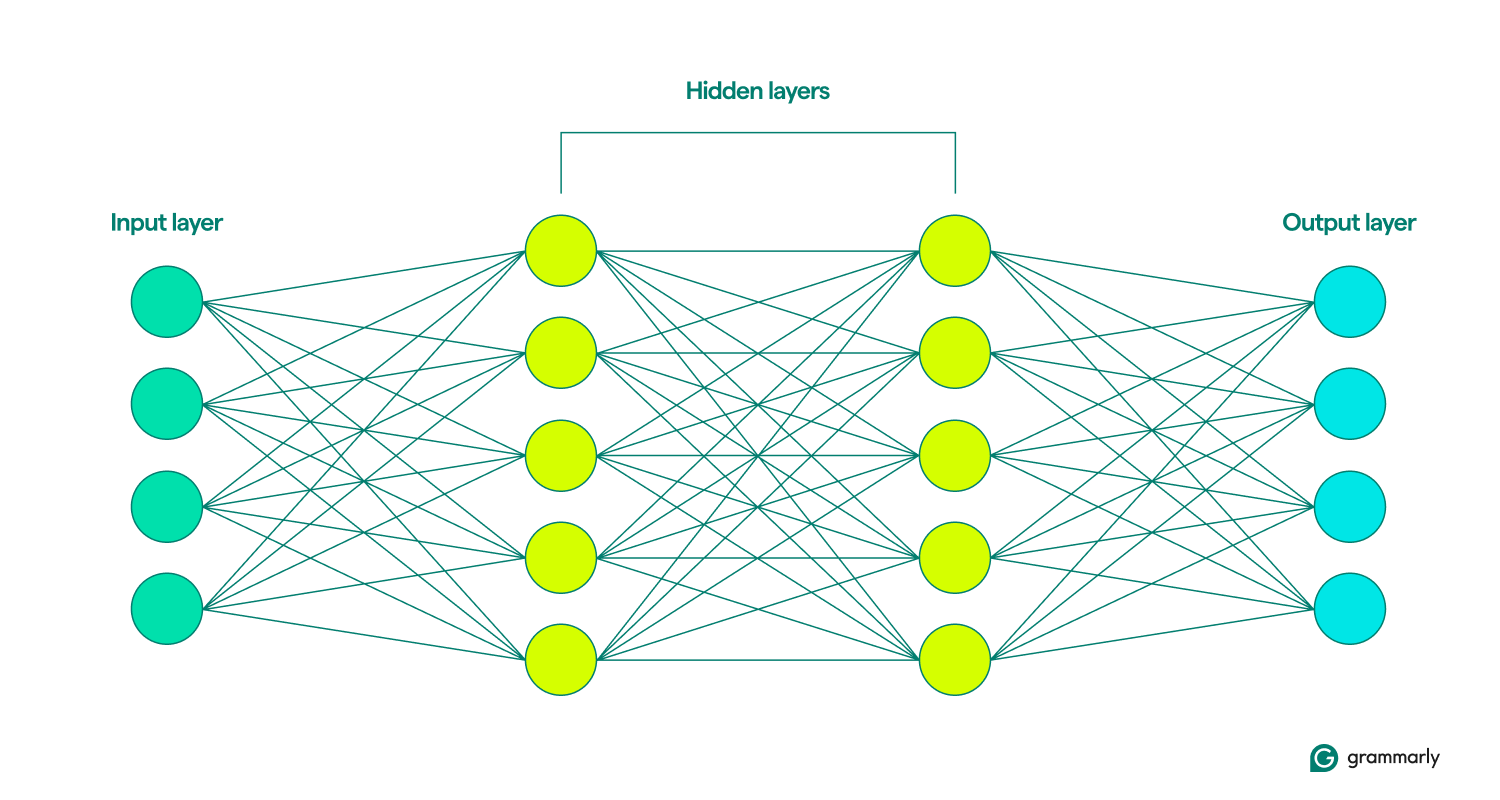

神经网络是更广泛的机器学习 (ML) 领域内的一种深度学习模型,可模拟人脑。 它通过分层排列的互连节点或神经元(输入层、隐藏层和输出层)处理数据。 每个节点执行简单的计算,有助于模型识别模式和做出预测的能力。

深度学习神经网络在处理图像和语音识别等复杂任务方面特别有效,是许多人工智能应用的重要组成部分。 神经网络架构和训练技术的最新进展极大地增强了人工智能系统的能力。

神经网络的结构如何

正如其名称所示,神经网络模型的灵感来自神经元,即大脑的构建模块。 成年人有大约 850 亿个神经元,每个神经元与大约 1,000 个其他神经元相连。 一个脑细胞通过发送称为神经递质的化学物质与另一个脑细胞进行交流。 如果接收细胞获得足够的这些化学物质,它就会兴奋并将自己的化学物质发送到另一个细胞。

有时称为人工神经网络 (ANN) 的基本单位是节点,它不是一个单元,而是一个数学函数。 就像神经元一样,如果它们获得足够的输入,它们就会与其他节点进行通信。

相似之处就到此为止。 神经网络的结构比大脑简单得多,具有明确定义的层:输入、隐藏和输出。 这些层的集合称为模型。 他们通过反复尝试人为地生成最接近期望结果的输出来学习或训练。 (稍后会详细介绍。)

输入层和输出层非常不言自明。 神经网络所做的大部分工作都发生在隐藏层中。 当节点被前一层的输入激活时,它会进行计算并决定是否将输出传递到下一层的节点。 这些层之所以如此命名,是因为它们的操作对最终用户来说是不可见的,尽管工程师可以通过一些技术来查看所谓的隐藏层中发生的情况。

当神经网络包含多个隐藏层时,它们被称为深度学习网络。 现代深度神经网络通常有很多层,包括执行不同功能的专用子层。 例如,某些子层增强了网络考虑正在分析的直接输入之外的上下文信息的能力。

神经网络如何工作

想想婴儿是如何学习的。 他们尝试某件事,失败,然后以不同的方式再次尝试。 这个循环一遍又一遍地继续,直到他们完善了行为。 这或多或少也是神经网络学习的方式。

在训练的一开始,神经网络会进行随机猜测。 输入层上的节点随机决定激活第一个隐藏层中的哪些节点,然后这些节点随机激活下一层中的节点,依此类推,直到这个随机过程到达输出层。 (像 GPT-4 这样的大型语言模型大约有 100 层,每层有数万或数十万个节点。)

考虑到所有的随机性,该模型会比较其输出(这可能很糟糕)并找出它的错误程度。 然后,它调整每个节点与其他节点的连接,根据给定的输入更改它们激活的可能性。 它会重复执行此操作,直到其输出尽可能接近所需的答案。

那么,神经网络如何知道它们应该做什么? 机器学习(ML)可以分为不同的方法,包括监督学习和无监督学习。 在监督学习中,模型根据包含明确标签或答案的数据进行训练,例如与描述性文本配对的图像。 然而,无监督学习涉及为模型提供未标记的数据,使其能够独立识别模式和关系。

这种训练的常见补充是强化学习,模型根据反馈进行改进。 通常,这是由人类评估者提供的(如果您曾经对计算机的建议表示赞成或反对,那么您就为强化学习做出了贡献)。 尽管如此,模型也有办法独立迭代学习。

将神经网络的输出视为预测是准确且有启发性的。 无论是评估信用度还是生成歌曲,人工智能模型的工作原理都是猜测最有可能正确的内容。 ChatGPT 等生成式人工智能将预测更进一步。 它按顺序工作,猜测刚刚输出后应该发生什么。 (稍后我们将讨论为什么这会出现问题。)

神经网络如何生成答案

一旦网络经过训练,它如何处理它看到的信息以预测正确的响应? 当你在ChatGPT界面中输入“给我讲一个关于仙女的故事”这样的提示时,ChatGPT如何决定如何响应?

第一步是神经网络的输入层将您的提示分解为小块信息,称为标记。 对于图像识别网络,标记可能是像素。 对于使用自然语言处理 (NLP) 的网络(例如 ChatGPT),标记通常是一个单词、单词的一部分或非常短的短语。

一旦网络在输入中注册了标记,该信息就会通过早期训练的隐藏层传递。 它从一层传递到下一层的节点分析输入的越来越大的部分。 这样,NLP 网络最终可以解释整个句子或段落,而不仅仅是一个单词或一个字母。

现在,网络可以开始制定其响应,它根据所训练的所有内容对接下来会发生的事情进行一系列逐字预测。

考虑一下提示:“给我讲一个关于仙女的故事。” 为了生成响应,神经网络分析提示以预测最可能的第一个单词。 例如,它可能确定“The”有 80% 的机会是最佳选择,“A”有 10% 的机会,“Once”有 10% 的机会。 然后它随机选择一个数字:如果数字在 1 到 8 之间,则选择“The”;如果数字在 1 到 8 之间,则选择“The”; 如果是9,则选择“A”; 如果是 10,则选择“一次”。 假设随机数为 4,对应于“The”。 然后,网络将提示更新为“告诉我一个关于仙女的故事。 The”并重复该过程来预测“The”之后的下一个单词。 这个循环继续进行,每个新词预测都基于更新的提示,直到生成一个完整的故事。

不同的网络会做出不同的预测。 例如,图像识别模型可能会尝试预测为狗的图像赋予哪个标签,并确定正确标签有 70% 的概率是“巧克力实验室”,20% 的概率是“英国西班牙猎狗”,10% 的概率是“英国西班牙猎犬”。为“金毛猎犬”。 在分类的情况下,通常,网络会选择最可能的选择,而不是概率猜测。

神经网络的类型

以下概述了不同类型的神经网络及其工作原理。

- 前馈神经网络 (FNN):在这些模型中,信息沿一个方向流动:从输入层,通过隐藏层,最后到达输出层。此模型类型最适合更简单的预测任务,例如检测信用卡欺诈。

- 递归神经网络 (RNN):与 FNN 相比,RNN 在生成预测时会考虑先前的输入。这使得它们非常适合语言处理任务,因为响应提示而生成的句子的结尾取决于句子的开始方式。

- 长短期记忆网络 (LSTM): LSTM 选择性地忘记信息,这使它们能够更有效地工作。这对于处理大量文本至关重要; 例如,谷歌翻译 2016 年对神经机器翻译的升级就依赖于 LSTM。

- 卷积神经网络 (CNN): CNN 在处理图像时效果最佳。他们使用卷积层扫描整个图像并寻找线条或形状等特征。 这使得 CNN 能够考虑空间位置,例如确定对象是否位于图像的上半部分或下半部分,并且还可以识别形状或对象类型,无论其位置如何。

- 生成对抗网络 (GAN): GAN 通常用于根据描述或现有图像生成新图像。它们的结构是两个神经网络之间的竞争:一个生成器网络,试图欺骗鉴别器网络,使其相信虚假输入是真实的。

- 变形金刚和注意力网络:变形金刚是当前人工智能能力爆炸性增长的原因。这些模型包含注意力聚光灯,使他们能够过滤输入以关注最重要的元素,以及这些元素如何相互关联,甚至跨文本页面。 Transformer 还可以训练大量数据,因此 ChatGPT 和 Gemini 等模型被称为大型语言模型 (LLM) 。

神经网络的应用

种类太多,无法一一列出,因此这里精选了当今神经网络的使用方式,重点是自然语言。

写作帮助:变形金刚已经改变了计算机帮助人们更好地写作的方式。Grammarly 等人工智能写作工具可以提供句子和段落级别的重写,以提高语气和清晰度。 这种模型类型还提高了基本语法建议的速度和准确性。 详细了解 Grammarly 如何使用人工智能。

内容生成:如果您使用过 ChatGPT 或 DALL-E,那么您已经亲身体验了生成式 AI。 变形金刚彻底改变了计算机创建与人类产生共鸣的媒体的能力,从睡前故事到超现实的建筑渲染。

语音识别:计算机在识别人类语音方面每天都在进步。新技术使模型能够考虑更多的上下文,模型在识别说话者的意图方面变得越来越准确,即使声音本身就可能有多种解释。

医学诊断和研究:神经网络擅长模式检测和分类,越来越多地用于帮助研究人员和医疗保健提供者了解和解决疾病。例如,COVID-19 疫苗的快速开发在一定程度上要归功于人工智能。

神经网络的挑战和局限性

以下简要介绍了神经网络提出的一些问题,但不是全部。

偏差:神经网络只能从被告知的内容中学习。如果它暴露于性别歧视或种族主义内容,它的输出也可能是性别歧视或种族主义的。 这种情况可能发生在从非性别语言翻译成性别语言的过程中,在没有明确性别认同的情况下,刻板印象仍然存在。

过度拟合:训练不当的模型可能会读取过多的数据,并难以应对新的输入。例如,主要针对特定种族的人进行训练的面部识别软件可能对其他种族的面孔表现不佳。 或者,垃圾邮件过滤器可能会错过新类型的垃圾邮件,因为它过于关注以前见过的模式。

幻觉:当今的生成式人工智能在某种程度上使用概率来选择生产什么,而不是总是选择排名最高的选择。这种方法有助于它更具创造性并生成听起来更自然的文本,但它也可能导致它做出完全错误的陈述。 (这也是法学硕士有时会犯基本数学错误的原因。)不幸的是,除非您了解更多或与其他来源进行事实核查,否则这些幻觉很难被发现。

可解释性:通常不可能确切地知道神经网络如何进行预测。虽然从试图改进模型的人的角度来看,这可能令人沮丧,但它也可能产生后果,因为人工智能越来越依赖于做出极大影响人们生活的决策。 今天使用的一些模型并不是基于神经网络,正是因为它们的创建者希望能够检查和理解过程的每个阶段。

知识产权:许多人认为法学硕士在未经许可的情况下合并写作和其他艺术作品,侵犯了版权。虽然他们往往不会直接复制受版权保护的作品,但众所周知,这些模型会创建可能来自特定艺术家的图像或措辞,甚至在提示时以艺术家独特的风格创作作品。

功耗:变压器模型的所有训练和运行都消耗巨大的能量。事实上,几年之内,人工智能消耗的电力可能与瑞典或阿根廷一样多。 这凸显了在人工智能开发中考虑能源和效率变得越来越重要。

神经网络的未来

预测人工智能的未来是出了名的困难。 1970 年,一位顶尖的人工智能研究人员预测,“三到八年内,我们将拥有一台具有普通人类一般智能的机器。” (我们距离通用人工智能(AGI)还不是很近。至少大多数人不这么认为。)

然而,我们可以指出一些值得关注的趋势。 更高效的模型将降低功耗,并直接在智能手机等设备上运行更强大的神经网络。 新的训练技术可以用更少的训练数据进行更有用的预测。 可解释性方面的突破可以增加信任并为改善神经网络输出铺平新途径。 最后,量子计算和神经网络的结合可能会带来我们只能想象的创新。

结论

受人脑结构和功能启发的神经网络是现代人工智能的基础。 它们擅长模式识别和预测任务,支撑着当今许多人工智能应用,从图像和语音识别到自然语言处理。 随着架构和训练技术的进步,神经网络继续推动人工智能能力的显着改进。

尽管神经网络具有潜力,但仍面临偏差、过度拟合和高能耗等挑战。 随着人工智能的不断发展,解决这些问题至关重要。 展望未来,模型效率、可解释性以及与量子计算集成方面的创新有望进一步扩大神经网络的可能性,从而有可能带来更具变革性的应用。