什么是自动编码器?初学者指南

已发表: 2024-10-28自动编码器是深度学习的重要组成部分,特别是在无监督机器学习任务中。在本文中,我们将探讨自动编码器的工作原理、其架构以及可用的各种类型。您还将发现它们的实际应用程序,以及使用它们所涉及的优点和权衡。

目录

- 什么是自动编码器?

- 自动编码器架构

- 自动编码器的类型

- 应用

- 优点

- 缺点

什么是自动编码器?

自动编码器是深度学习中使用的一种神经网络,用于学习输入数据的高效、低维表示,然后用于重建原始数据。通过这样做,该网络在训练过程中学习数据最基本的特征,而不需要明确的标签,使其成为自我监督学习的一部分。自动编码器广泛应用于图像去噪、异常检测和数据压缩等任务,其中它们压缩和重建数据的能力非常有价值。

自动编码器架构

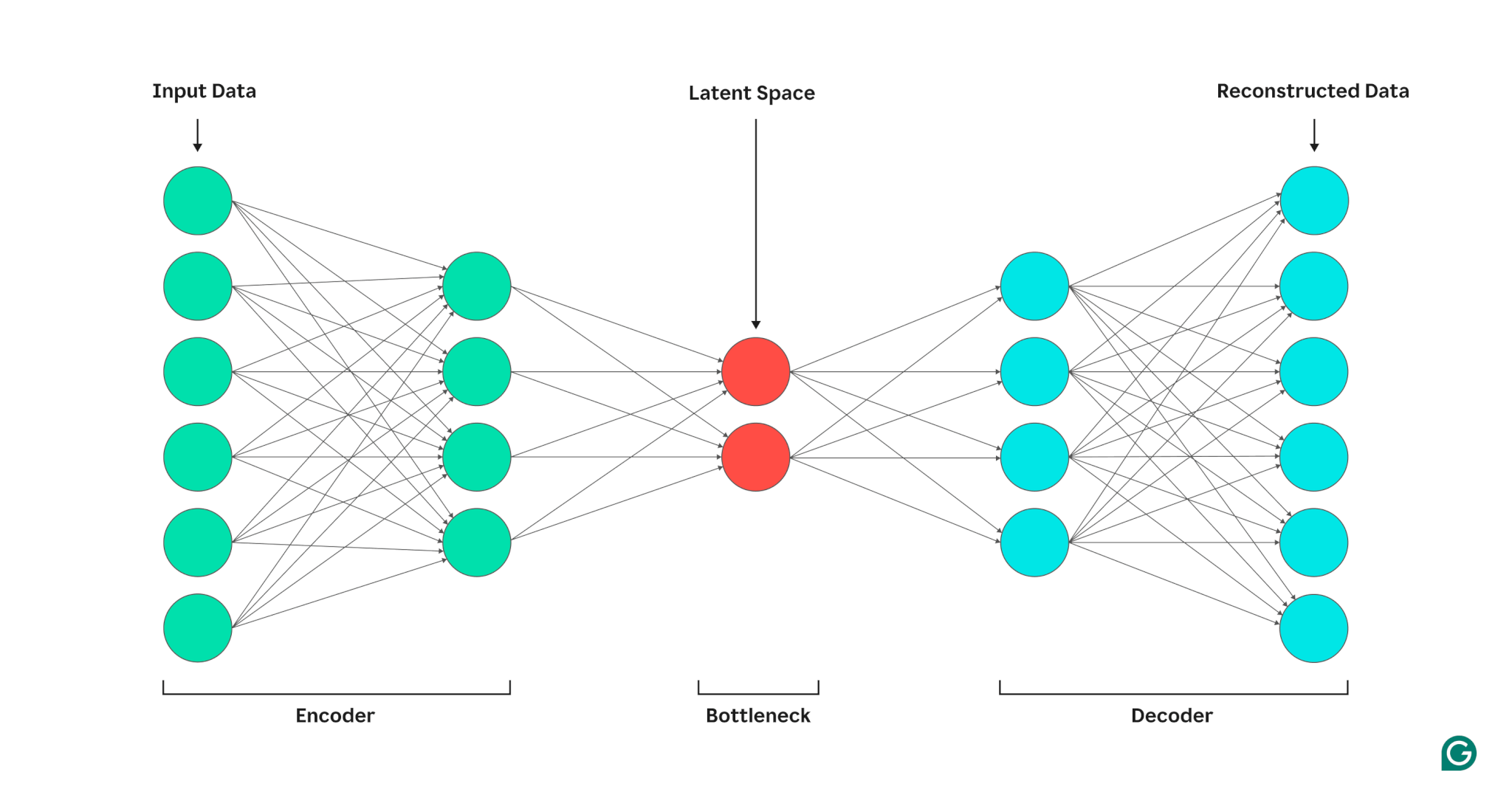

自动编码器由三部分组成:编码器、瓶颈(也称为潜在空间或代码)和解码器。这些组件协同工作以捕获输入数据的关键特征并使用它们来生成准确的重建。

自动编码器通过调整编码器和解码器的权重来优化其输出,旨在生成保留关键特征的输入的压缩表示。这种优化最大限度地减少了重建误差,该误差代表输入和输出数据之间的差异。

编码器

首先,编码器将输入数据压缩为更有效的表示形式。编码器通常由多层组成,每层中的节点较少。随着数据通过每一层进行处理,节点数量的减少迫使网络学习数据最重要的特征,以创建可以存储在每一层中的表示。这个过程称为降维,将输入转换为数据关键特征的紧凑摘要。编码器中的关键超参数包括层数和每层神经元的数量,它们决定压缩的深度和粒度,以及激活函数,它决定如何在每层表示和转换数据特征。

瓶颈

瓶颈也称为潜在空间或代码,是在处理过程中存储输入数据的压缩表示的位置。瓶颈节点数量少;这限制了可以存储的数据量并决定了压缩级别。瓶颈中的节点数量是一个可调的超参数,允许用户控制压缩和数据保留之间的权衡。如果瓶颈太小,自动编码器可能会因丢失重要细节而错误地重建数据。另一方面,如果瓶颈太大,自动编码器可能只是复制输入数据,而不是学习有意义的通用表示。

解码器

在最后一步中,解码器使用在编码过程中学到的关键特征从压缩形式重新创建原始数据。这种解压的质量是使用重建误差来量化的,重建误差本质上是衡量重建数据与输入数据的差异程度的指标。重建误差通常使用均方误差(MSE)来计算。由于 MSE 测量原始数据和重建数据之间的平方差,因此它提供了一种数学上简单的方法来更严厉地惩罚较大的重建误差。

自动编码器的类型

有几种类型的专用自动编码器,每种都针对特定应用进行了优化,类似于其他神经网络。

去噪自动编码器

去噪自动编码器旨在从噪声或损坏的输入中重建干净的数据。在训练过程中,有意将噪声添加到输入数据中,使模型能够学习在存在噪声的情况下保持一致的特征。然后将输出与原始的干净输入进行比较。这一过程使得去噪自动编码器在图像和音频降噪任务中非常有效,包括消除视频会议中的背景噪声。

稀疏自动编码器

稀疏自动编码器在任何给定时间限制活动神经元的数量,从而鼓励网络学习比标准自动编码器更有效的数据表示。这种稀疏性约束是通过惩罚来强制执行的,该惩罚阻止激活比指定阈值更多的神经元。稀疏自动编码器简化了高维数据,同时保留了基本特征,这使得它们对于提取可解释特征和复杂数据集可视化等任务很有价值。

变分自动编码器 (VAE)

与典型的自动编码器不同,VAE 通过将训练数据中的特征编码为概率分布而不是固定点来生成新数据。通过从该分布中采样,VAE 可以生成各种新数据,而不是根据输入重建原始数据。此功能使 VAE 对于生成任务非常有用,包括合成数据生成。例如,在图像生成中,在手写数字数据集上训练的 VAE 可以根据训练集创建新的、逼真的数字,但这些数字并非精确的复制品。

收缩自动编码器

收缩自动编码器在计算重建误差期间引入了额外的惩罚项,鼓励模型学习对噪声具有鲁棒性的特征表示。这种惩罚通过促进对输入数据的微小变化不变的特征学习来帮助防止过度拟合。因此,收缩自动编码器比标准自动编码器对噪声具有更强的鲁棒性。

卷积自动编码器 (CAE)

CAE 利用卷积层捕获高维数据中的空间层次结构和模式。卷积层的使用使得 CAE 特别适合处理图像数据。 CAE 通常用于图像压缩和图像异常检测等任务。

自动编码器在人工智能中的应用

自动编码器有多种应用,例如降维、图像去噪和异常检测。

降维

自动编码器是在保留关键特征的同时降低输入数据维度的有效工具。此过程对于可视化高维数据集和压缩数据等任务非常有价值。通过简化数据,降维还可以提高计算效率,降低规模和复杂性。

异常检测

通过学习目标数据集的关键特征,自动编码器可以在提供新输入时区分正常数据和异常数据。高于正常的重建错误率表明偏离正常。因此,自动编码器可以应用于预测维护和计算机网络安全等不同领域。

去噪

去噪自动编码器可以通过学习从噪声训练输入中重建噪声数据来清理噪声数据。这种功能使得去噪自动编码器对于图像优化等任务非常有价值,包括提高模糊照片的质量。去噪自动编码器在信号处理中也很有用,它们可以清除噪声信号,以实现更有效的处理和分析。

自动编码器的优点

自动编码器具有许多关键优势。其中包括从未标记数据中学习的能力、无需显式指令即可自动学习特征以及提取非线性特征的能力。

能够从未标记的数据中学习

自动编码器是一种无监督的机器学习模型,这意味着它们可以从未标记的数据中学习底层数据特征。此功能意味着自动编码器可以应用于标记数据可能稀缺或不可用的任务。

自动特征学习

标准特征提取技术,例如主成分分析 (PCA),在处理复杂和/或大型数据集时通常不切实际。由于自动编码器在设计时考虑了降维等任务,因此它们可以自动学习数据中的关键特征和模式,而无需手动特征设计。

非线性特征提取

自动编码器可以处理输入数据中的非线性关系,使模型能够从更复杂的数据表示中捕获关键特征。这种能力意味着自动编码器比只能处理线性数据的模型具有优势,因为它们可以处理更复杂的数据集。

自动编码器的局限性

与其他机器学习模型一样,自动编码器也有自己的一系列缺点。其中包括缺乏可解释性、需要大量训练数据集才能表现良好以及泛化能力有限。

缺乏可解释性

与其他复杂的机器学习模型类似,自动编码器缺乏可解释性,这意味着很难理解输入数据和模型输出之间的关系。在自动编码器中,出现这种可解释性的缺乏是因为自动编码器会自动学习特征,而不是传统模型,其中特征是明确定义的。这种机器生成的特征表示通常是高度抽象的,并且往往缺乏人类可解释的特征,使得很难理解表示中每个组成部分的含义。

需要大量训练数据集

自动编码器通常需要大型训练数据集来学习关键数据特征的通用表示。给定较小的训练数据集,自动编码器可能会过度拟合,从而导致在呈现新数据时泛化能力较差。另一方面,大型数据集为自动编码器提供了必要的多样性,以学习可应用于各种场景的数据特征。

对新数据的概括有限

在一个数据集上训练的自动编码器通常具有有限的泛化能力,这意味着它们无法适应新的数据集。出现这种限制是因为自动编码器适合基于给定数据集中的突出特征的数据重建。因此,自动编码器通常在训练期间从数据中丢弃较小的细节,并且无法处理不符合广义特征表示的数据。