Grammarly 的幕後花絮:用 AI 檢測雜亂無章的寫作

已發表: 2018-07-10每當你寫出比句子更長的東西時,你需要決定如何組織和表達你的想法。 好的寫作很容易理解,因為每個句子都建立在它之前的句子之上。 當主題發生變化時,強大的作家會使用過渡句和段落分隔符作為路標,告訴讀者接下來會發生什麼。

語言學家稱這方面的寫作語篇連貫性,這是本週將在澳大利亞墨爾本舉行的 SIGDIAL 會議上出現的 Grammarly 研究團隊的一些很酷的新研究的主題。

什麼是話語連貫性,為什麼要關心它?

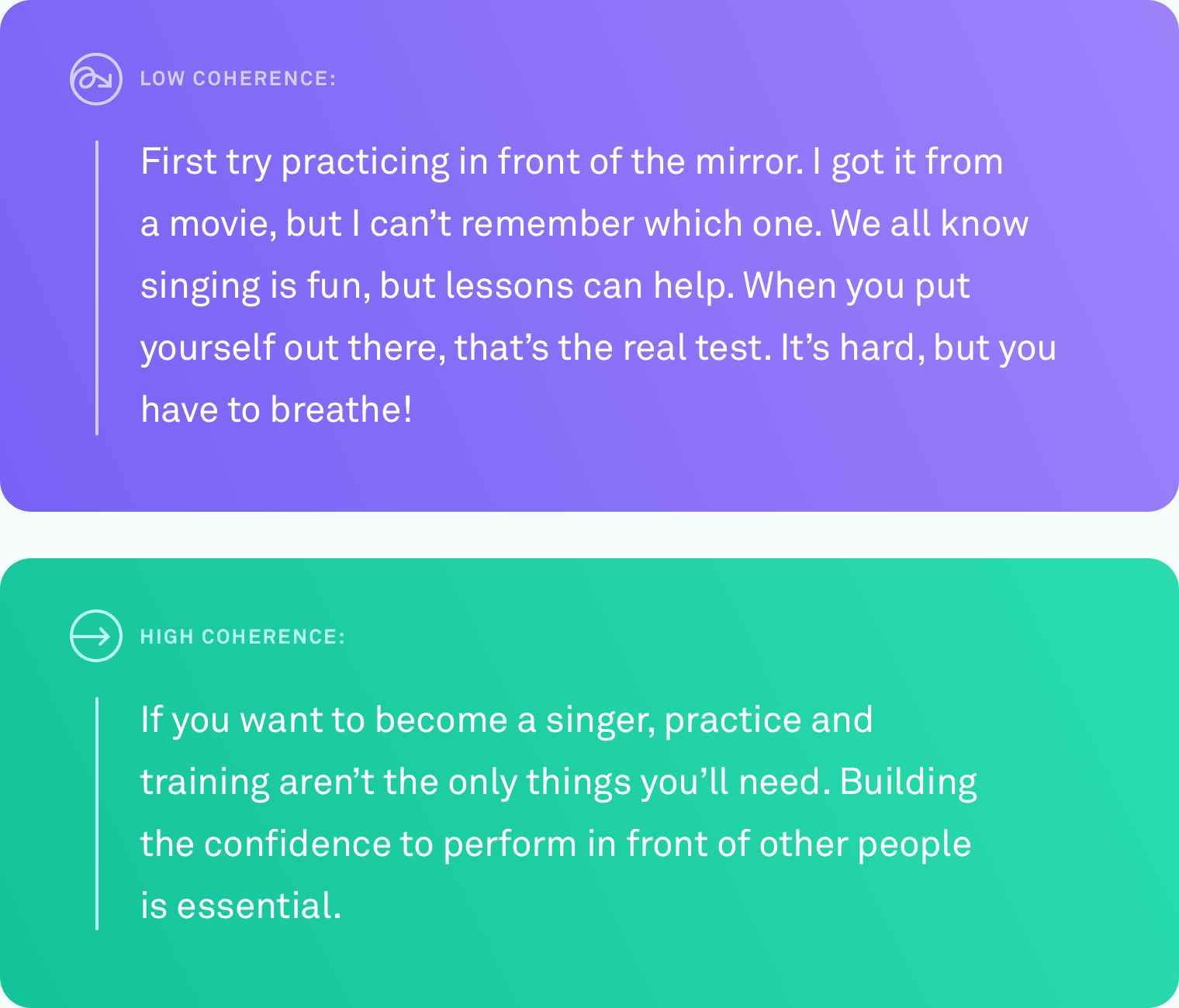

當我們說一個文本具有高度的語篇連貫性時,我們的意思是所有的句子都在邏輯上聯繫在一起。 作者沒有偏離主題。 不同的點通過轉換連接。 文本從頭到尾都很容易理解。

這種類型的組織並不總是自然而然的。 我們中很少有人以完美線性的想法進行思考。 一個系統可以自動告訴你什麼時候你寫了一些其他人難以理解的東西——並最終提出如何解決這個問題——將極大地幫助你傳達你的意思。

做了什麼

教計算機準確判斷文本的連貫程度是一項挑戰。 迄今為止,評估計算機語篇連貫性的最常用方法是基於句子排序任務。 使用這種方法,研究人員獲取現有的、經過良好編輯的文本,例如新聞文章,並隨機重新排列所有句子。 假設是隨機排列可以被視為不連貫的,而原始排序可以被視為連貫的。 任務是建立一種計算機算法,可以區分不連貫的版本和原始版本。 在這些條件下,一些系統的準確率已高達 90%。 相當令人印象深刻。

但是這種方法有一個很大的潛在缺陷。 也許你已經發現了。 隨機重新排序句子可能會產生低連貫性的文本,但它不會產生看起來像人類自然會寫的任何文本。

在 Grammarly,我們專注於解決現實世界的問題,因此我們知道我們在該領域所做的任何工作都需要以真實寫作為基準,而不是人工場景。 令人驚訝的是,很少有工作在普通情況下測試人們所寫的真實文本的話語評估方法。 是時候改變這一點了。

現實世界的研究,現實世界的作家

我們必須解決的第一個問題是所有其他從事話語連貫性研究的研究人員都面臨的問題:缺乏真實世界的數據。 沒有現有的普通、自然書寫的文本語料庫可以用來測試我們的算法。

我們通過從多個公共來源收集文本創建了一個語料庫:Yahoo Answers、Yelp 評論以及公開可用的政府和企業電子郵件。 我們選擇這些特定的來源是因為它們代表了人們在典型的一天中所寫的東西——論壇帖子、評論和電子郵件。

為了將所有這些文本變成計算機算法可以學習的語料庫,我們還需要對每個文本的連貫程度進行評分。 這個過程稱為註解。 無論您的算法有多好,草率的註釋都會嚴重扭曲您的結果。 在我們的論文中,我們提供了我們測試的許多註釋方法的詳細信息,包括一些涉及眾包的方法。 我們最終決定讓專家註釋者以三分制(低、中或高連貫性)對每段文本的連貫程度進行評分。 每段文字都由三位註釋者評判。

測試算法

一旦我們有了語料庫,就該測試各種計算機系統識別給定文本的連貫性水平的準確度了。 我們測試了三種類型的系統:

第一類是基於實體的模型。 這些系統跟踪同一實體在文本中被提及的位置和頻率。 例如,如果系統在多個句子中找到“運輸”一詞,則將其視為這些句子在邏輯上相互關聯的標誌。

在第二類中,我們測試了一個基於詞彙連貫圖的模型。 這是一種將句子表示為圖形中的節點並連接包含相似詞對的句子的方法。 例如,這種類型的模型將連接一個包含“汽車”的句子和一個包含“卡車”的句子,因為這兩個句子都可能是關於車輛或交通工具的。

第三類是神經網絡或深度學習模型。 我們測試了其中的幾個,包括由 Grammarly 團隊構建的兩個全新模型。 這些是基於 AI 的系統,可以學習捕獲其含義的每個句子的表示,並且它們可以通過組合這些句子表示來學習文檔的一般含義。 他們可以尋找不限於實體出現或相似詞對的模式。

句子排序任務

我們使用新語料庫中的高連貫性文本為所有三種類型的模型創建了一個句子排序任務。 我們發現在其他句子排序數據集上表現良好的模型在我們的數據集上也表現良好,準確率高達 89%。 基於實體的模型和詞彙連貫圖顯示出不錯的準確性(通常為 60% 到 70% 的準確率),但在四個領域中的三個領域中,神經模型的表現至少比其他模型高出 10 個百分點。

真正的寫作測試

我們真正想知道的是,這些模型中的任何一個是否可以在真實的、自然書寫的文本上以相同的準確度水平執行。 我們將註釋者的標籤轉換為數值(低=1、中=2、高=3),並將這些數字平均在一起,以獲得每段文本的連貫性分數。

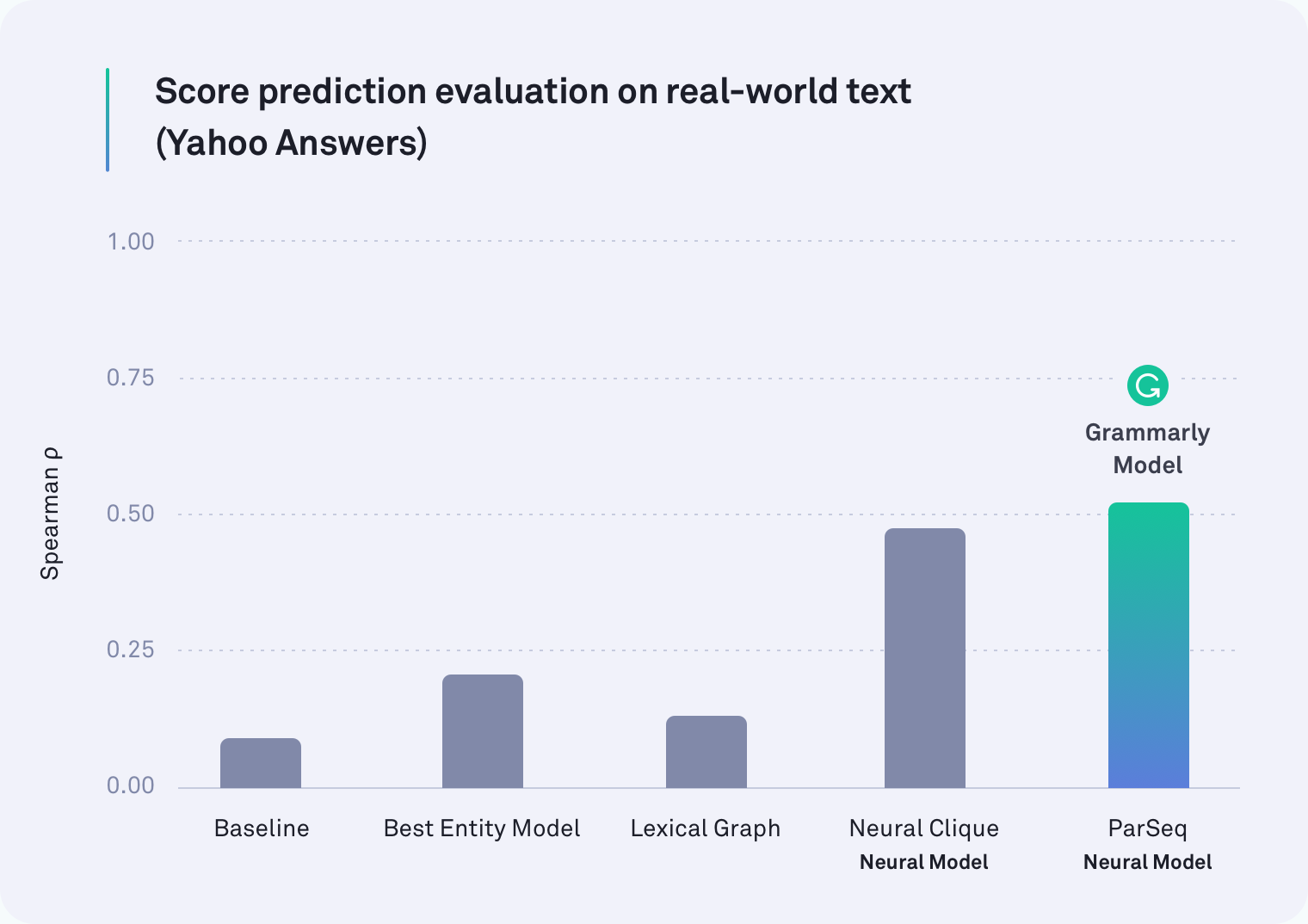

在每個領域中,至少有一個基於神經網絡的系統優於其他所有系統。 事實上,Grammarly 的其中一個將段落分隔符考慮在內的模型是 Yahoo Answers 文本中表現最好的模型,如下表所示。 由斯坦福大學的研究人員開發的神經團模型也表現出色。

但我們最初的假設是正確的:所有模型在現實世界任務中的表現都比在句子順序任務上的表現更差——有些更差。 例如,在人工句子重新排序場景中,詞彙圖法對企業電子郵件的準確率為 78%,但在這個更現實的評估中,它只達到了 45%。

我們發現了什麼

事實證明,之前關於語篇連貫性的工作一直在測試錯誤的東西。 句子順序任務絕對不是衡量語篇連貫性的好方法。 我們的結果很清楚:在人工場景中表現良好的系統在現實世界的文本中表現更差。

重要的是要注意這一發現並不是一個挫折。 事實並非如此。 發展任何領域的一部分是評估你的評估方式——每隔一段時間停下來看看你真正在衡量什麼。 由於這項工作,研究語篇連貫性的研究人員現在掌握了兩條重要信息。 一個觀點是,句子排序任務不再是我們衡量準確性的方式。 第二個是公開可用的、帶註釋的真實世界文本和新基準(我們的神經模型)的語料庫,以用於未來的研究。

期待

對於一個能夠可靠地判斷一段文本中的話語連貫性的系統,還有更多的工作要做,還有很多令人興奮的應用程序。 有一天,這樣的系統不僅可以告訴您整體信息的連貫性,還可以指出可能難以理解的特定段落。 有朝一日,我們希望幫助您使這些段落更容易理解,以便您的收件人清楚地了解您要說的內容。

畢竟,Grammarly 成為一名綜合溝通助手的途徑不僅僅是確保你的寫作在語法和文體上準確——而是確保你的理解符合預期。

——

Joel Tetreault 是 Grammarly 的研究總監。 Alice Lai 是伊利諾伊大學厄巴納-香檳分校的博士生,曾在 Grammarly 擔任研究實習生。 這項研究將於 2018 年 7 月 12 日至 14 日在澳大利亞墨爾本舉行的 SIGDIAL 2018 年會上發表。隨附的研究論文題為“Wild Discourse Coherence: A Dataset, Evaluation and Methods”將發表在 Proceedings of話語與對話特別興趣小組第 19 屆年會。 本博文中描述的數據集稱為語篇連貫性語法語料庫,可在此處免費下載用於研究目的。